1. 数据选择

数据选择(Data Choices) 模块收集匿名使用统计数据,并发送到 https://stats.opennms.org。

当具有 Admin 角色的用户第一次登录系统时,将提示是否希望选择加入来发布这些统计数据。

只有 Administrator 选择加入后,才会发布统计数据。

稍后可以在 'Admin' 菜单中的 'Data Choices' 链接来禁用使用统计信息。

启用后,将在系统启动时和每24小时收集并发布以下匿名统计数据:

-

系统 ID (随机生成的 UUID)

-

OpenNMS Horizon 发行版

-

OpenNMS Horizon 版本

-

OS 体系结构

-

OS 名称

-

OS 版本

-

alarms表中的告警数 -

events表中的事件数 -

ipinterface表中的 IP 接口数 -

node表的设备数 -

设备数,按 System OID 分组

-

2. 用户管理

用户 是 OpenNMS Horizon 系统中可以登录的账户。 理论上,每个用户对应一个人。 OpenNMS Horizon 用户 代表一个参与者,该参与者可以通过关联 安全角色 在系统中被授予权限。 OpenNMS Horizon 默认将 用户 信息和凭证存储在本地文件中。 凭证和用户详细信息,例如,联系信息、描述或 安全角色 可以通过 Web 用户界面中的 Admin 部分 进行管理。

2.1. 用户

管理 用户 是通过 Web 用户界面 完成的,并且需要具有管理权限的 用户 身份登录。

默认情况下,admin 用户用于最初创建和修改 用户。

用户, 密码 和其它详细描述保存在 users.xml 文件中。

当 用户 属性更改时,不需要重新启动 OpenNMS Horizon。

如果要把管理任务分配给 用户,则可以把名为 ROLE_ADMIN 的 安全角色 赋予用户。

| 不要删除 admin 和 rtc 用户。 RTC 用户用来在开始页面上计算设备和服务的可用性来进行实时通讯。 |

| 修改默认的 admin 密码。 |

-

以具有管理权限的 用户 身份登录

-

从用户的主导航中选择 Configure OpenNMS ,该导航菜单在你的登录用户名下

-

选择 Configure Users, Groups and On-Call roles 然后选择 Configure Users

-

单击现有 用户 旁边的 修改 图标,并选择 Reset Password

-

设置新的 密码, 确认密码 ,然后单击 OK

-

单击 Finish 以保存并应用更改

-

使用用户名和旧密码登录

-

从用户的主导航中选择 Change Password ,该导航菜单在你的登录用户名下

-

选择 Change Password

-

使用旧密码验证身份,并设置新密码和确认密码

-

单击 Submit

-

注销并使用新密码登录

-

以具有管理权限的 用户 身份登录

-

从用户的主导航中选择 Configure OpenNMS ,该导航菜单在你的登录用户名下

-

选择 Configure Users, Groups and On-Call roles 然后选择 Configure Users

-

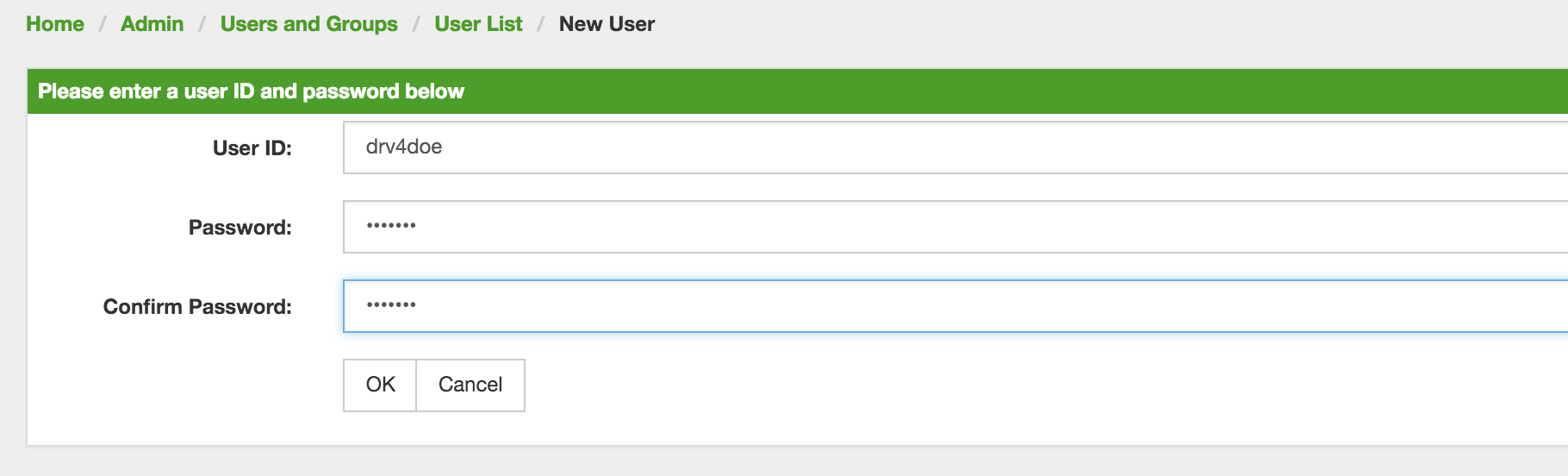

使用 Add new user ,输入 登录名 作为 用户 ID 和 密码 ,再输入确认密码,或者单击现有 用户 旁边的 修改。

-

可选项: 填写详细的 用户信息,提供关于系统中新用户的更多上下文信息

-

可选项: 分配 安全角色 以授予或删除系统中的权限

-

可选项: 提供 通知 目标中使用的 通知信息,以便向 用户 发送消息

-

可选项: 设置 用户 接收 通知 的时间表

-

单击 Finish 以保存并应用更改

| 默认情况下,新 用户 会分配一个 ROLE_USER 的 安全角色。 确认和处理 告警 以及 通知 是可以的。 管理菜单 Configure OpenNMS 不可用。 |

-

以具有管理权限的 用户 身份登录

-

从用户的主导航中选择 Configure OpenNMS ,该导航菜单在你的登录用户名下

-

选择 Configure Users, Groups and On-Call roles 然后选择 Configure Users

-

使用 用户 旁边的垃圾箱图标删除

-

使用 OK 确认删除请求

2.2. 安全角色

安全角色 是一组权限,可以分配给 用户。 它们可以控制访问 Web 用户界面和 ReST API,来进行监视和查看信息。 在分布式部署的情况下,Minion 或 远程轮询 实例与 OpenNMS Horizon 交互时,需要 ROLE_MINION 和 ROLE_REMOTING 定义的 安全角色。 可以使用以下 安全:

| 安全角色名称 | 描述 |

|---|---|

anyone |

如果安装了 |

ROLE_ANONYMOUS |

允许 HTTP OPTIONS 请求,在 ReST 资源和 Web 用户界面的登录和注销页面上显示允许的 HTTP 方法。 |

ROLE_ADMIN |

在 Web 用户界面和 ReST API 中创建,读取,更新和删除的权限。 |

ROLE_ASSET_EDITOR |

只更新设备的资产记录的权限。 |

ROLE_DASHBOARD |

允许用户只访问 Dashboard。 |

ROLE_DELEGATE |

允许代表另一个用户执行操作 (例如,确认告警)。 |

ROLE_JMX |

允许检索 JMX 度量指标,但是不允许执行 OpenNMS Horizon JVM 的 MBeans,即使它们只返回简单的值。 |

ROLE_MINION |

Minion 操作所需的最小权限。 |

ROLE_MOBILE |

允许用户使用 OpenNMS COMPASS 移动应用程序通过 ReST API 确认 告警 和 通知。 |

ROLE_PROVISION |

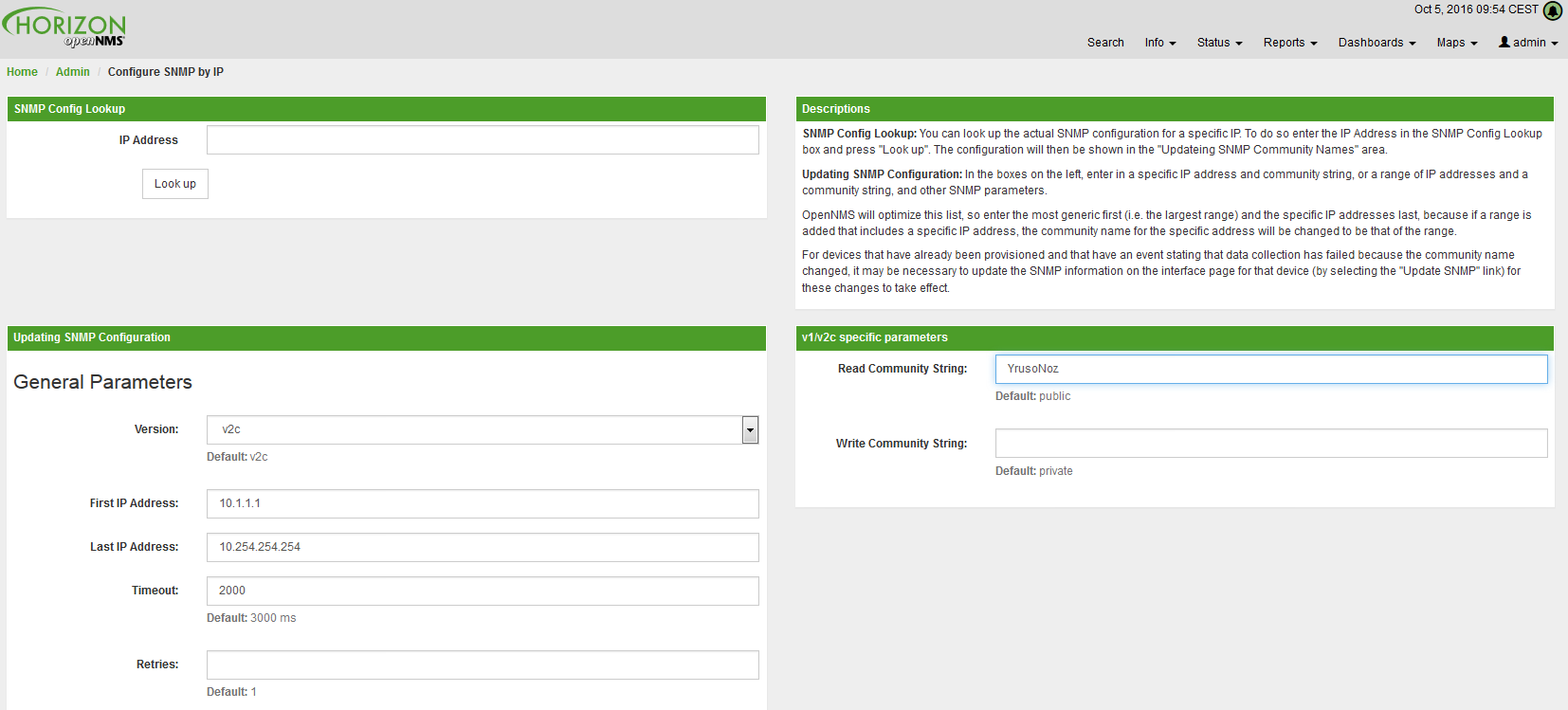

允许用户使用 Provisioning 系统 ,并在 OpenNMS Horizon 中配置 SNMP 来从设备服务管理信息。 |

ROLE_READONLY |

仅限于读取 Web 用户界面中的信息,而不能更改 告警 状态或 通知。 |

ROLE_REMOTING |

允许从 Remote Poller(远程轮询) 实例访问交互监控信息的权限。 |

ROLE_REST |

允许用户与 OpenNMS Horizon 的整个 ReST API 进行交互 |

ROLE_RTC |

与 OpenNMS Horizon Real-Time Console 交换可用性计算信息。 |

ROLE_USER |

新建用户的默认权限,Web 用户界面上允许升级和确认 告警 和 通知。 |

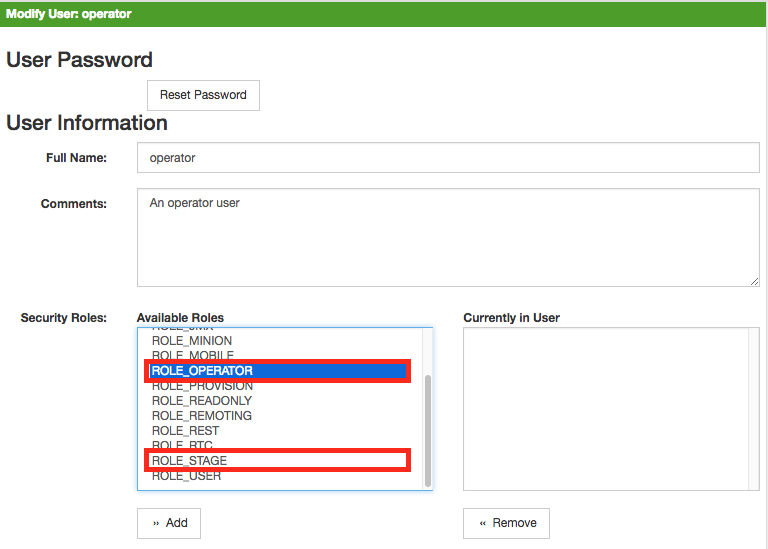

-

以具有管理权限的 用户 身份登录

-

从用户的主导航中选择 Configure OpenNMS ,该导航菜单在你的登录用户名下

-

选择 Configure Users, Groups and On-Call roles 然后选择 Configure Users

-

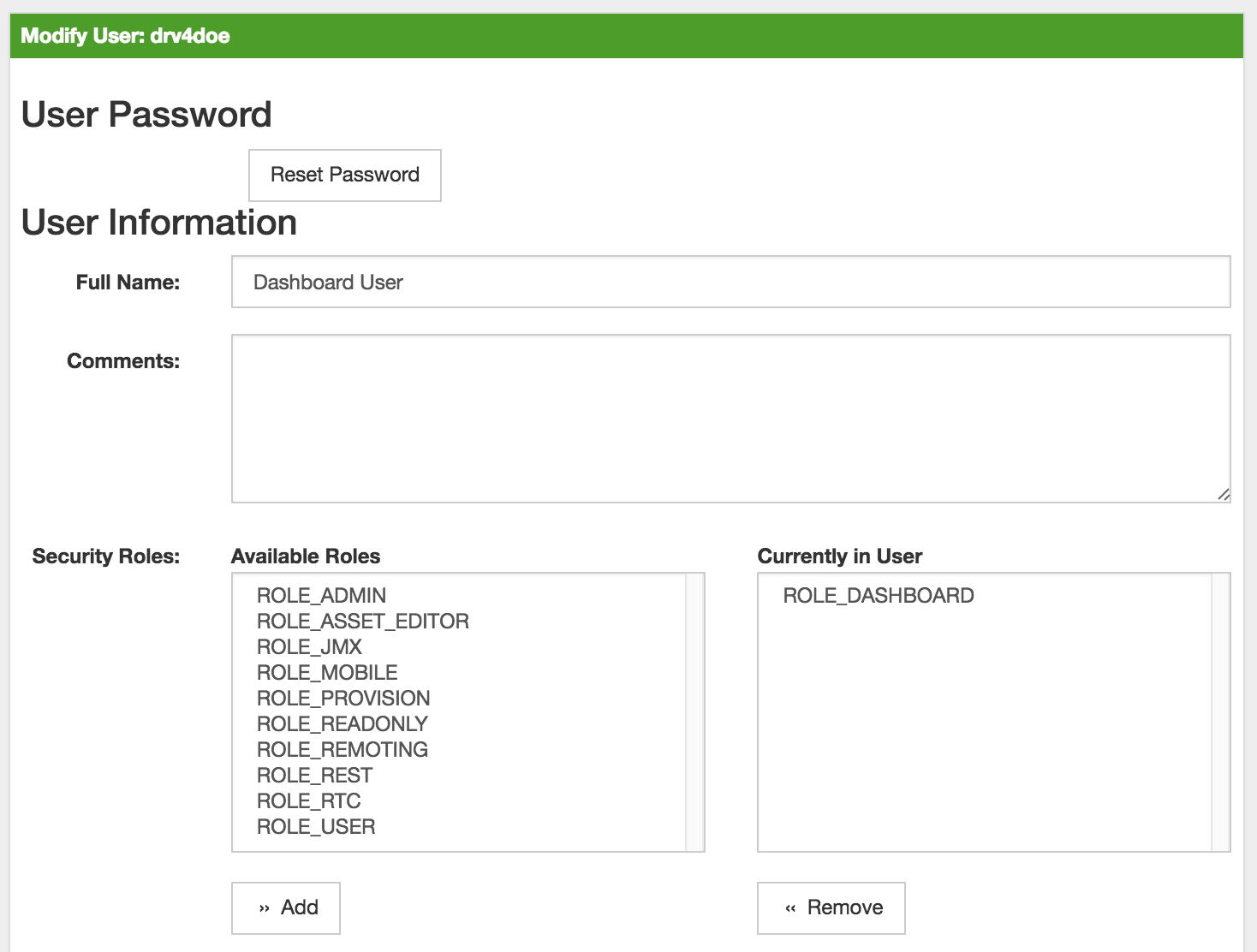

通过单击 用户 旁边的修改图标修改现有 用户

-

在 安全角色 里从 可以角色 中选择 角色

-

使用 Add 和 Remove 从 用户 分配和删除 安全角色

-

单击 Finish 以保存并应用更改

-

注销 然后 登录 以应用新的 安全角色 设置

-

创建一个名为

$OPENNMS_HOME/etc/security-roles.properties的文件。 -

添加名为

roles的属性,并添加逗号分隔列表的自定义角色,例如:

roles=operator,stage-

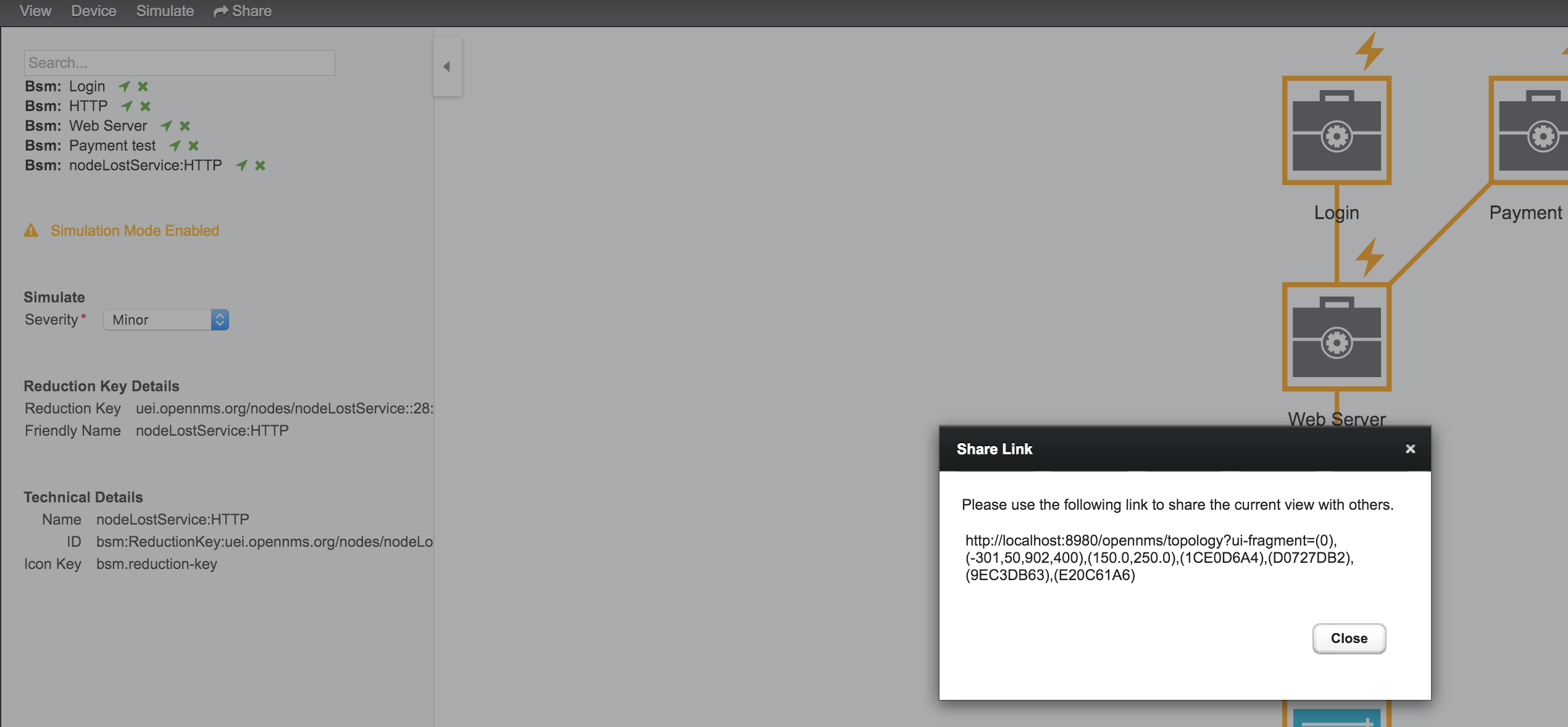

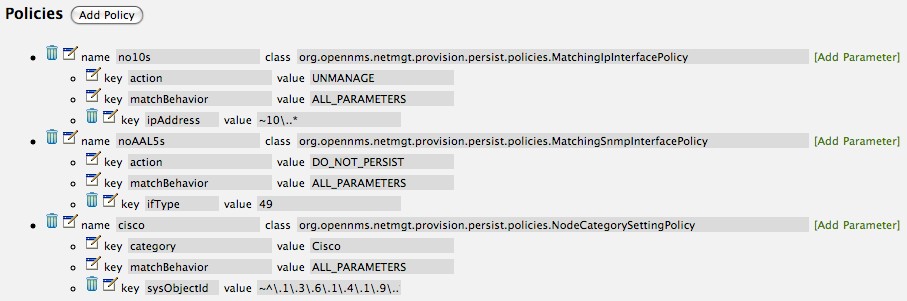

将安全角色和用户关联后,新的自定义角色就可用了,如下图所示:

:imagesdir: ../../images

:imagesdir: ../../images

2.3. Web UI Pre-Authentication

可用配置 OpenNMS Horizon 运行在代理后面提供身份认证,然后使用 header 将 pre-authenticated 的用户传递给 OpenNMS Horizon webapp。

配置 pre-authentication 在 $OPENNMS_HOME/jetty-webapps/opennms/WEB-INF/spring-security.d/header-preauth.xml 中定义。此文件自动引入到 Spring Security context 中,但默认不启用。

| 不要 以这种方式配置 OpenNMS Horizon ,除非你确定 web UI 只会被代理访问,不会被最终用户访问。 否则,恶意攻击者可以设计包含 pre-authentication header ,并完全控制 web UI 和 ReST APIs。 |

2.3.1. 启用 Pre-Authentication

编辑 header-preauth.xml 文件,并设置 enabled 属性:

<beans:property name="enabled" value="true" />2.3.2. 配置 Pre-Authentication

可以设置许多其它属性来更改 pre-authentication 插件的行为。

| 属性 | 描述 | 默认值 |

|---|---|---|

|

插件 pre-authentication 是否处于激活状态。 |

|

|

如果为 true,那么如果 header 未设置或用户不存在,则禁止登录。如果为 false,则转向其它机制 (基本身份验证,表单登录等。) |

|

|

用来指定进行身份验证的用户的 HTTP header。 |

|

|

用逗号分隔的用户具有的附加凭据 (角色) 列表。 |

3. 管理 Web 界面

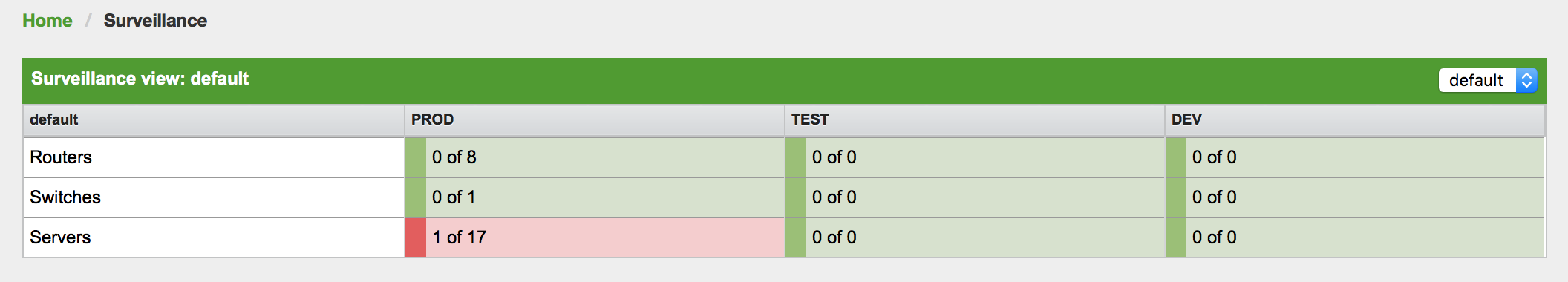

3.1. 监视视图

当网络较大并且包含不同优先级的设备时,如何清楚地显示 "整个系统" 是怎样工作的变得很重要。 监视视图旨在实现这一目标。 通过使用类别,您可以定义一个矩阵,以便汇总监控结果。 想象一下,你有10台服务器,10个互联网连接和5台带 DSL 线路的 PCs:

| 服务器 | 互联网连接 | |

|---|---|---|

Super important |

1 of 10 |

0 of 10 |

Slightly important |

0 of 10 |

0 of 10 |

Vanity |

4 of 10 |

0 of 10 |

整个想法是让人们一眼就能看出问题所在。 矩阵类型的显示允许比简单列表高得多的聚合。 此外,监视视图显示节点而不是服务 - 当您查看类别时,这是一个重要的信息。 乍一看,您想知道有多少服务器存在问题,而不是此类别中有多少服务存在问题。

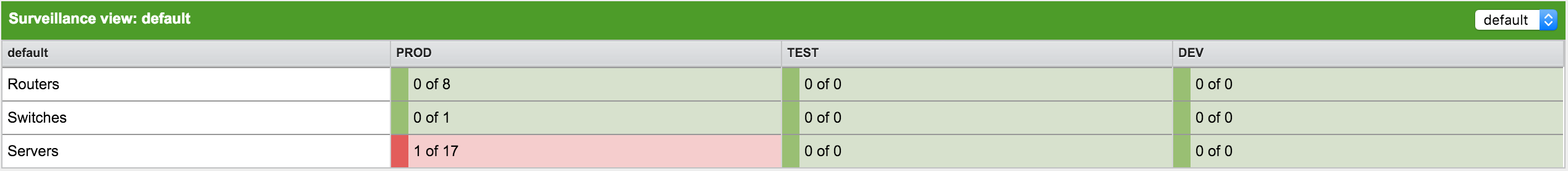

监视视图单元故障的可视指示定义如下:

-

没有服务 down: 绿色正常

-

一个 (1) 服务 down: 黄色作为警告

-

超过一项 (1) 服务 down: 红色,严重警告

此 监视视图 模型还构建了 Dashboard View 的基础。

3.1.1. 默认监视视图配置

监视视图 在 surveillance-views.xml 文件中定义。

该文件位于 OpenNMS Horizon etc 目录中。

| 此文件可以在文本编辑器中修改,并在每次加载 监视视图 页面时重新读取。 因此,对此文件的更改不需要重新启动 OpenNMS Horizon。 |

默认配置如下所示:

<?xml version="1.0" encoding="UTF-8"?>

<surveillance-view-configuration

xmlns:this="http://www.opennms.org/xsd/config/surveillance-views"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://www.opennms.org/xsd/config/surveillance-views http://www.opennms.org/xsd/config/surveillance-views.xsd"

default-view="default" >

<views >

<view name="default" refresh-seconds="300" >

<rows>

<row-def label="Routers" >

<category name="Routers"/>

</row-def>

<row-def label="Switches" >

<category name="Switches" />

</row-def>

<row-def label="Servers" >

<category name="Servers" />

</row-def>

</rows>

<columns>

<column-def label="PROD" >

<category name="Production" />

</column-def>

<column-def label="TEST" >

<category name="Test" />

</column-def>

<column-def label="DEV" >

<category name="Development" />

</column-def>

</columns>

</view>

</views>

</surveillance-view-configuration>

请注意,旧的 report-category 属性已弃用,不再受支持。

|

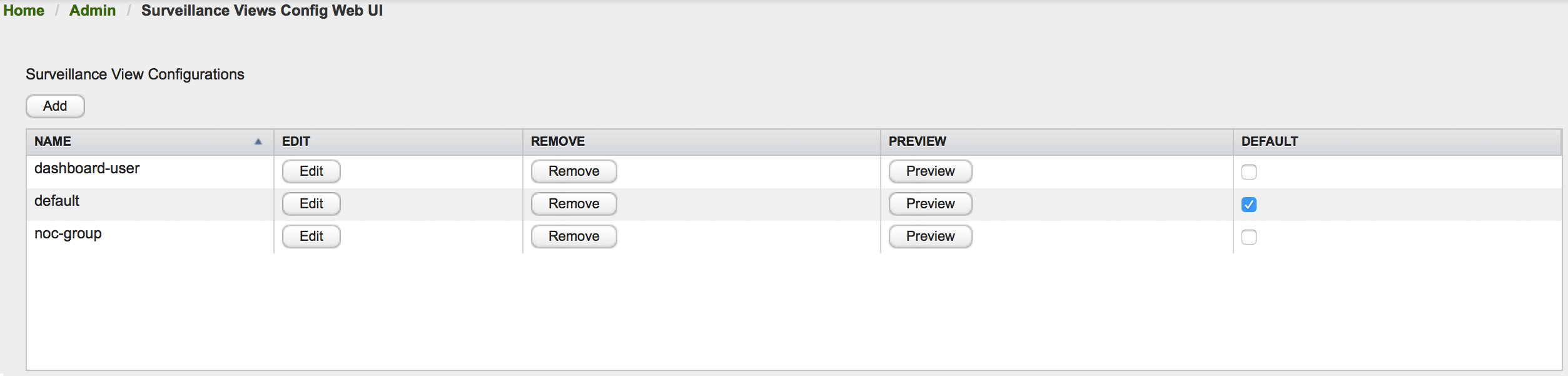

3.1.2. 配置监控视图

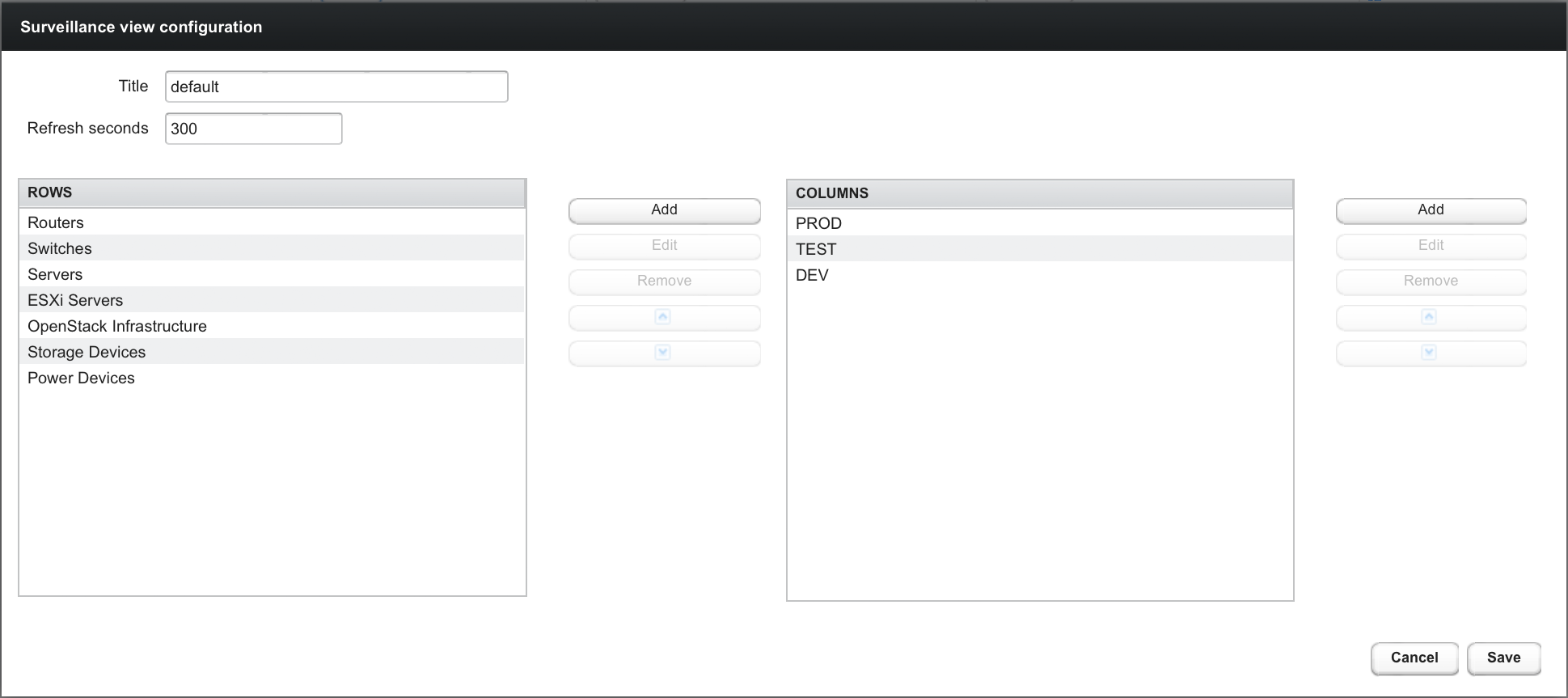

也可以使用 OpenNMS Horizon Admin 页面上的 监视视图配置 功能修改 监视视图 配置。

此页面概括了已配置的 监视视图,并允许用户编辑,删除以及预览定义的 监视视图。 此外,可以使用 DEFAULT 列中的复选框选择默认的 监视视图。

编辑监视视图时,用户必须定义视图的标题以及连续刷新之间的时间间隔,以秒为单位。 在此对话框的左侧,列出已定义的行,右侧是已定义的列。 除了添加新条目,用户还可以修改或删除现有条目。 此外,可以使用 up/down 按钮修改条目的位置。

编辑行或列定义需要为此条目选择唯一标签,并至少选择一个 OpenNMS Horizon 类别。 完成后,你可以点击 Save 按钮以保存修改的配置,或者 Cancel 关闭此对话框。

3.1.3. 分类设备

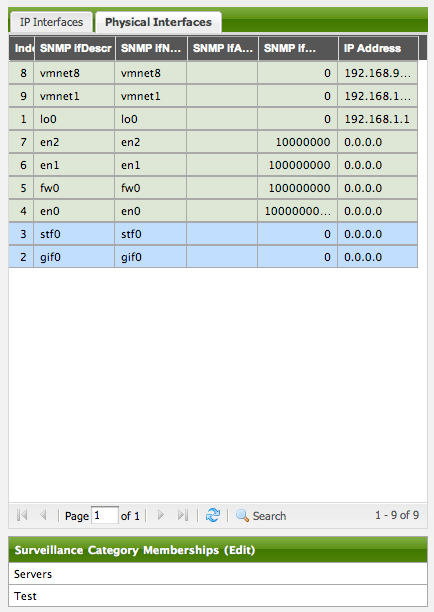

要在监视视图中对节点进行分类,请选择一个节点,然后单击 Surveillance Category Memberships 旁边的 Edit。 返回 监视视图,选择两个代表一列和一行的类别,例如 Servers 和 Test,然后单击 Add。

3.1.4. 为用户和组创建视图

您可以将用户和组名称用于 监视视图。 调用 监视视图 页面时,根据以下条件选择要显示的 监视视图。 按顺序匹配:

-

监视视图名称等于登录 OpenNMS Horizon 时使用的用户名。

-

监视视图名称等于用户指定的 OpenNMS Horizon 组名称。

-

监视视图名称等于

surveillance-views.xml配置文件中的default-view属性。

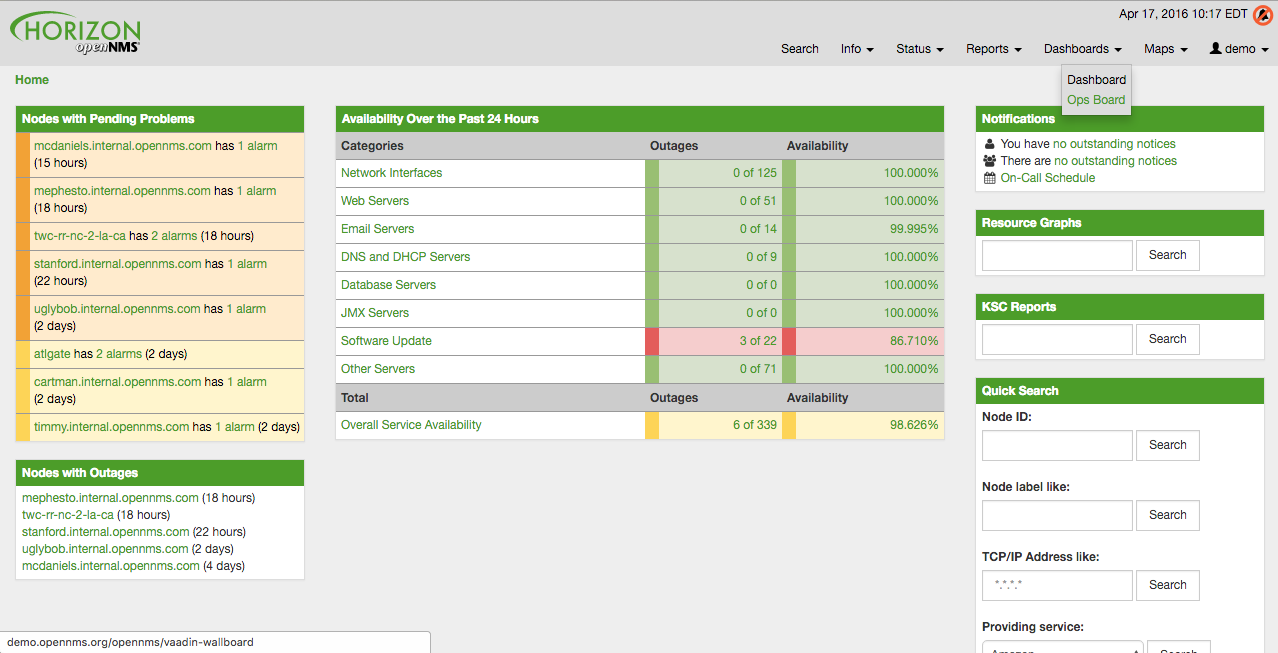

3.2. Dashboard

在网络运营中心 NOC 中,关于网络中的问题的概览很重要,通常被描述为 Dashboards。 大型网络具有不同职责的人员(操作员),Dashboard 应仅显示指定 监控上下文 的信息。 网络或服务器运营商需要自定义或过滤 Dashboard 上的信息。 Dashboard 作为一种概览,通常也用于监控系统提供的信息为更详细的诊断切入点。 监视视图 允许通过选择行,列和单元来缩减可见信息,以快速定位要导航的信息。

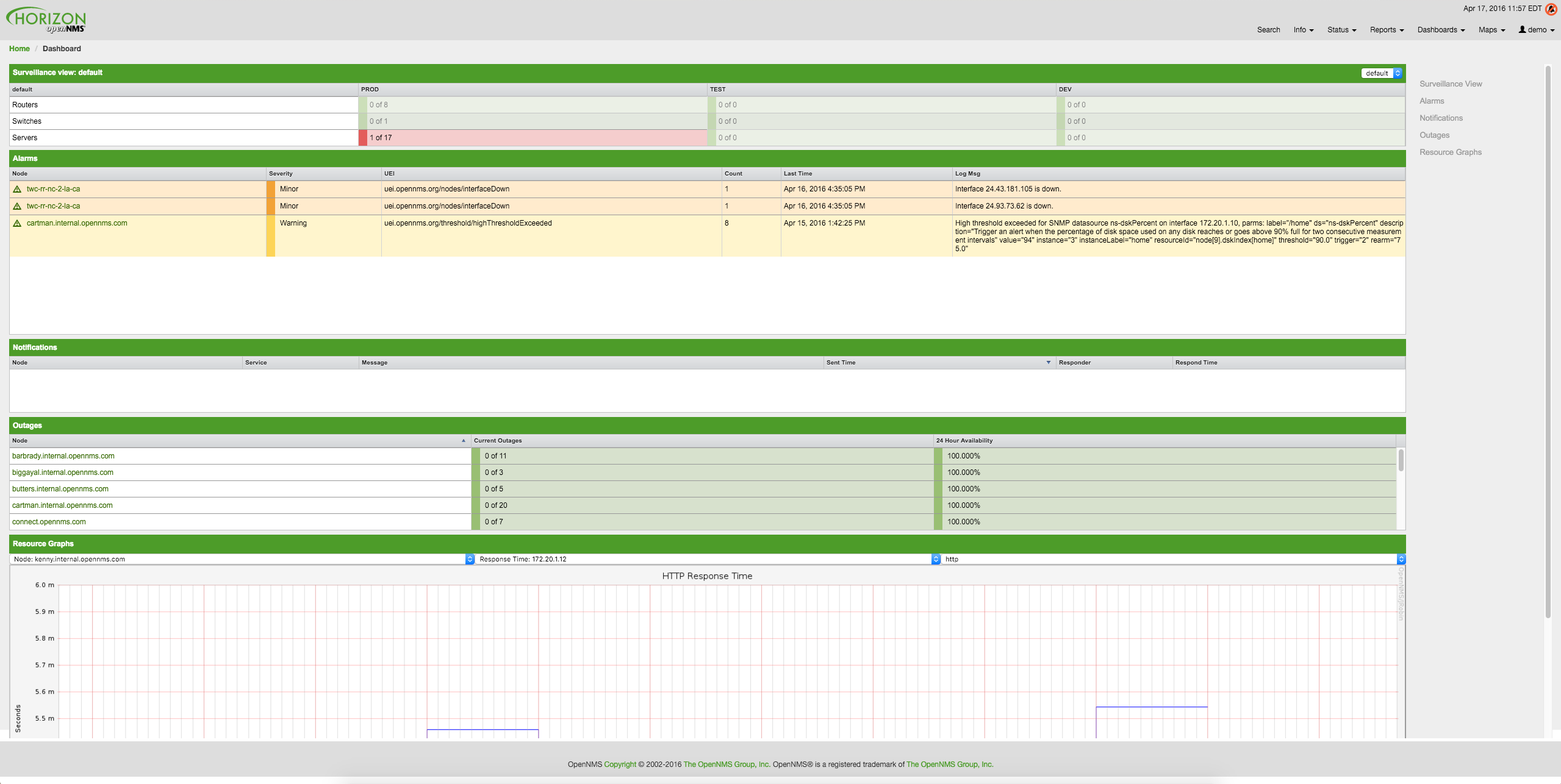

3.2.1. 组件

Dashboard 由五个组件构成:

-

监视视图: 允许为 Dashboard 建模 监控上下文。

-

告警: 显示未确认的 告警,应由 操作员 升级。

-

通知: 显示发送到 Engineers 的活动和未确认的通知。

-

设备状态: 显示所有当前的网络 故障。

-

资源图视图: 显示性能判断的性能时间序列报表。

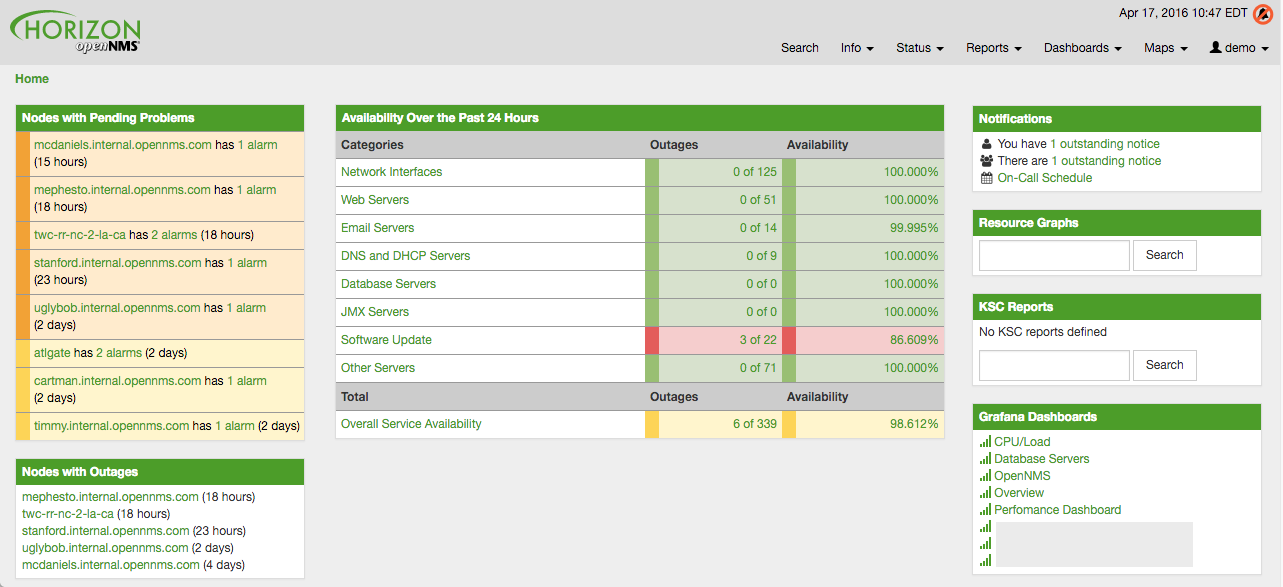

以下屏幕截图显示了已配置的 Dashboard,以及哪些信息显示在组件中。

以下部分描述了每个组件中显示的信息。 所有其他组件都根据 监视视图 显示信息。

监视视图

监视视图 具有多种功能。

-

允许对 监控上下文 进行建模,并在矩阵视图中显示服务和节点 故障。

-

允许通过选择行,列和单元格来定位 Dashboard 中的信息。

您可以选择列,行,单个单元格,当然还可以选择 监视视图 中的所有条目。 有关如何配置 监视视图 的详细信息,请参阅 监视视图部分。

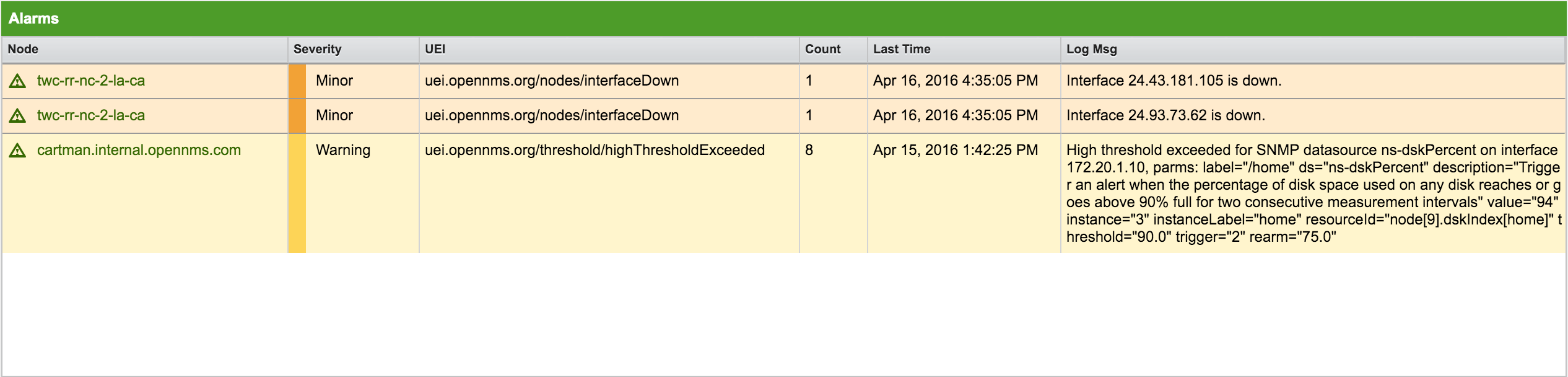

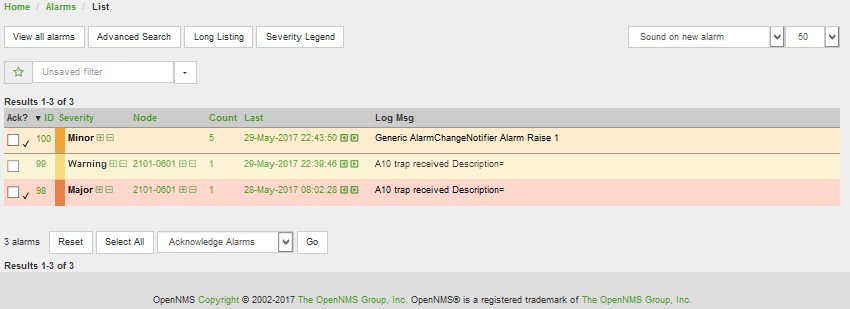

告警

告警 组件概括了严重性高于 Normal(1) 的所有未确认的 告警。 已确认 告警 将从 操作员 的职责中删除。 以下信息显示在:

-

设备: 告警 关联的设备名称

-

严重级别: 告警 的严重级别

-

UEI: 显示 告警 的 UEI

-

告警次数: 通过 告警 压缩进行重复数据删除的 告警 数

-

最后发生时间: 最后一次出现 告警 的时间

-

记录消息: 来自 事件 的日志消息,它是此 告警 的来源。它在事件配置文件的

<logmsg />中指定

告警 组件显示最新的 告警,并允许用户滚动查看最近 100 条 告警。

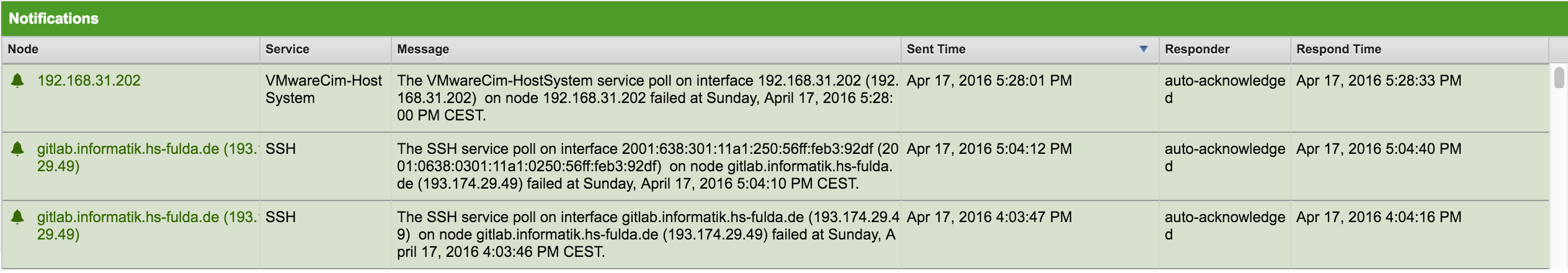

通知

为了通知人们有关工作时间的通知,并强制采取措施立即修复或重新配置系统。 在 OpenNMS Horizon 中,可以确认通知,以查看谁在处理特定问题。 Dashboard 应在 NOC 中显示活动的通知,以提供概览并提供干预的可能性。

-

设备: 与通知关联的受监视节点的名称

-

服务: 与通知关联的服务的名称

-

信息: 通知消息

-

发送时间: 发送通知的时间

-

响应人: 确认通知的用户名

-

响应时间: 用户确认通知的时间

通知 组件显示最近未确认的通知,并允许用户滚动查看最近 100 条 通知。

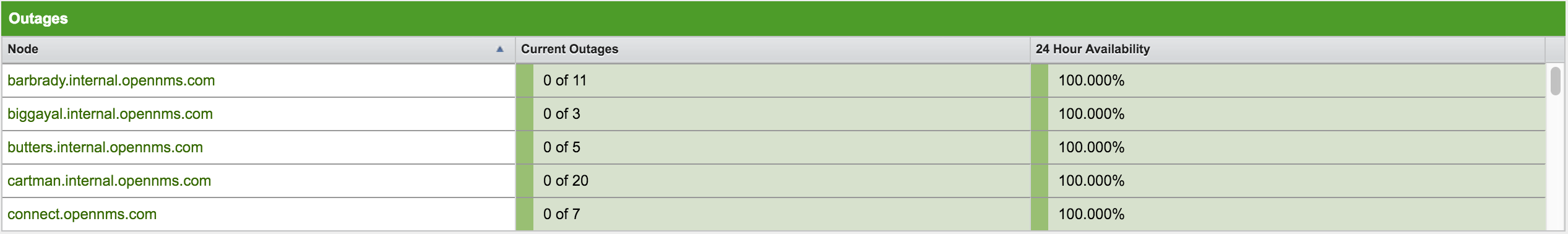

设备状态

已确认的 告警 并不意味着故障必须已解决。 为了提供有关网络中活动 故障 的概述信息,Dashboard 显示 设备状态 组件中的故障列表。

-

设备: 活动故障的监控设备的名称

-

目前的故障: 具有故障的设备上的服务数量和受监控服务的总数,例如 这意味着 "3 个服务中的 3 个受到影响"。

-

24 小时可用性: 过去24小时计算的设备提供的所有服务的可用性。

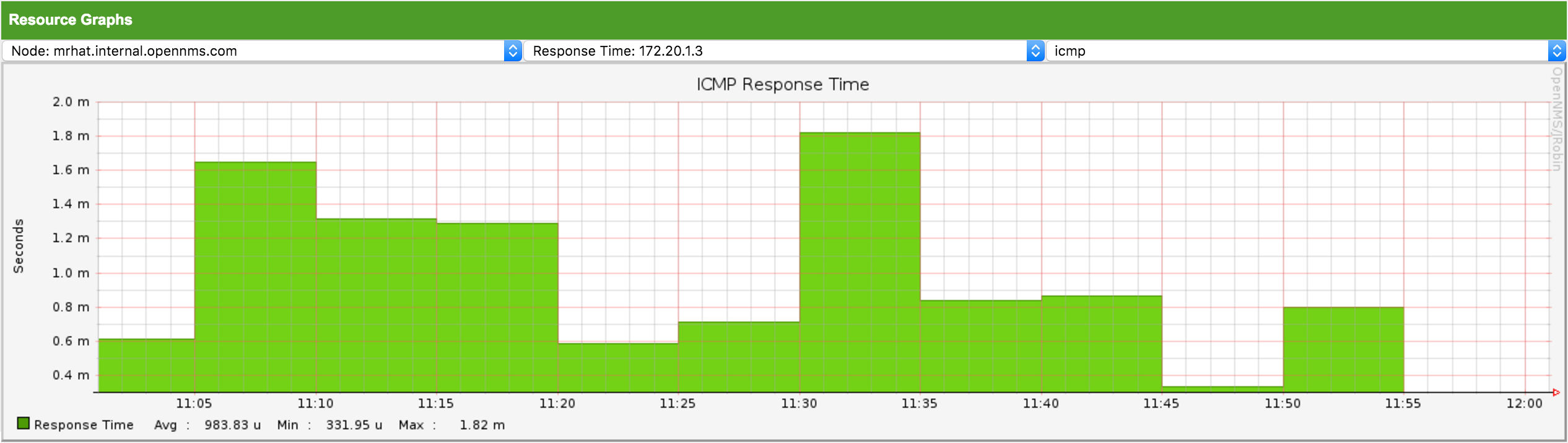

资源图视图

为了提供诊断性能问题快速入口,资源图视图 允许在 监视视图 的上下文中导航到过滤的时间序列数据报表。

它允许按顺序浏览由 监视视图 上下文和选择过滤的设备提供的资源图,并显示一个图表报表。

3.2.2. 高级配置

监视视图 组件允许为不同的监视上下文建模多个视图。 它为网络运营商或服务器运营商提供了创建特殊视图的可能性。 Dashboard 仅显示 一个 监视视图 配置。 为了给不同的用户提供使用 监视视图 组件的可能性,可以将登录用户使用的 监视视图 映射到 Dashboard 中。

监视视图 选择设备也可以使用 用户限制过滤器。 如果您有一组用户,应该只看到设备的子集,监视视图 将过滤分配给用户组无关的设备。

Dashboard 旨在将用户的视图集中,并因此也集中他们感兴趣的设备。 为此,添加了一个新角色,可以将其分配给用户,该用户将仅查看 Dashboard。

使用 Dashboard 角色

以下示例说明了如何使用此 Dashboard 角色。

例如,用户 drv4doe 被分配了 dashboard 角色。

因此,当 drv4doe 登录时,用户将直接进入 Dashboard 页面,并根据 drv4doe 的 监视视图 定义显示自定义 Dashboard。

第1步: 创建用户

以下示例将 Dashboard 分配给用户 "drv4doe" (路由器和交换机 jockey),并限制用户导航到 OpenNMS Horizon WebUI 中的任何其它链接。

drv4doe第2步: 更改安全角色

现在,通过 WebUI 将 ROLE_PROVISION 角色添加到用户,或者在 /opt/opennms/etc 目录中的 users.xml 文件手动编辑用户 drv4doe。

drv4doe 添加 dashboard 角色<user>

<user-id>drv4doe</user-id>

<full-name>Dashboard User</full-name>

<password salt="true">6FOip6hgZsUwDhdzdPUVV5UhkSxdbZTlq8M5LXWG5586eDPa7BFizirjXEfV/srK</password>

<role>ROLE_DASHBOARD</role>

</user>第3步: 定义监视视图

编辑 $OPENNMS_HOME/etc/surveilliance-view.xml 文件,为你在步骤1中创建的用户 drv4doe 添加定义。

<?xml version="1.0" encoding="UTF-8"?>

<surveillance-view-configuration

xmlns:this="http://www.opennms.org/xsd/config/surveillance-views"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://www.opennms.org/xsd/config/surveillance-views http://www.opennms.org/xsd/config/surveillance-views.xsd"

default-view="default" >

<views >

<view name="drv4doe" refresh-seconds="300" >

<rows>

<row-def label="Servers" >

<category name="Servers"/>

</row-def>

</rows>

<columns>

<column-def label="PROD" >

<category name="Production" />

</column-def>

<column-def label="TEST" >

<category name="Test" />

</column-def>

</columns>

</view>

<!-- default view here -->

<view name="default" refresh-seconds="300" >

<rows>

<row-def label="Routers" >

<category name="Routers"/>

</row-def>

<row-def label="Switches" >

<category name="Switches" />

</row-def>

<row-def label="Servers" >

<category name="Servers" />

</row-def>

</rows>

<columns>

<column-def label="PROD" >

<category name="Production" />

</column-def>

<column-def label="TEST" >

<category name="Test" />

</column-def>

<column-def label="DEV" >

<category name="Development" />

</column-def>

</columns>

</view>

</views>

</surveillance-view-configuration>这种配置和设备分类的正确分配,将为所有用户生成默认的 Dashboard,除了 drv4doe 用户。

你可以通过在 OpenNMS Horizon URL 的末尾指定 ?quiet=true; 来隐藏所有页面的上部导航。

在大型显示器或电视屏幕上使用 dashboard 进行大屏展示时,这非常方便。

|

但是,但以 drv4doe 身份登录时,用户将直接进入 Dashboard 页面,并根据自定义 监视视图 显示 Dashboard。

不允许 drv4doe 用户导航到 dashboard.jsp URL 以外的链接。

这样做会导致 Access Denied 错误。

|

匿名 dashboards

你可以修改安全框架的配置文件,以便无需登录即可访问一个或多个 dashboards。

最后,你可以将浏览器指向特定 URL,像 http://…/opennms/dashboard1 或 http://…/opennms/dashboard2,通过无认证方式查看 dashboard。

首先,如上所述配置监视视图并创建 dashboard 用户。

例如,制作两个 dashboards 并创建两个名为 dashboard1 和 dashboard2 的用户。

测试您是否可以作为每个新用户登录并查看正确的 dashboard。

现在创建一些可用于区分 dashboards 的别名。

在 /opt/opennms/jetty-webapps/opennms/WEB-INF 中编辑 web.xml。

在第一个 <servlet-mapping> 标记之前,添加以下 servlet 条目:

<servlet>

<servlet-name>dashboard1</servlet-name>

<jsp-file>/dashboard.jsp</jsp-file>

</servlet>

<servlet>

<servlet-name>dashboard2</servlet-name>

<jsp-file>/dashboard.jsp</jsp-file>

</servlet>在第一个 <error-page> 标记之前,添加以下 servlet-mapping 条目:

<servlet-mapping>

<servlet-name>dashboard1</servlet-name>

<url-pattern>/dashboard1</url-pattern>

</servlet-mapping>

<servlet-mapping>

<servlet-name>dashboard2</servlet-name>

<url-pattern>/dashboard2</url-pattern>

</servlet-mapping>在最后一个 <filter-mapping> 标记之后,添加以下 filter-mapping 条目:

<filter-mapping>

<filter-name>AddRefreshHeader-120</filter-name>

<url-pattern>/dashboard.jsp</url-pattern>

</filter-mapping>

<filter-mapping>

<filter-name>AddRefreshHeader-120</filter-name>

<url-pattern>/dashboard1</url-pattern>

</filter-mapping>

<filter-mapping>

<filter-name>AddRefreshHeader-120</filter-name>

<url-pattern>/dashboard2</url-pattern>

</filter-mapping>接下来编辑 applicationContext-acegi-security.xml 已对 /dashboard1 and /dashboard2 别名启用匿名访问认证。

在文件顶部附近,找到 <bean id="filterChainProxy" …>。

在 /rss.jsp* 条目下面,为每个 dashboard 别名添加一个条目:

<bean id="filterChainProxy" class="org.acegisecurity.util.FilterChainProxy">

<property name="filterInvocationDefinitionSource">

<value>

CONVERT_URL_TO_LOWERCASE_BEFORE_COMPARISON

PATTERN_TYPE_APACHE_ANT

/rss.jsp*=httpSessionContextIntegrationFilter,logoutFilter,authenticationProcessingFilter,basicProcessingFilter,securityContextHolderAwareRequestFilter,anonymousProcessingFilter,basicExceptionTranslationFilter,filterInvocationInterceptor

/dashboard1*=httpSessionContextIntegrationFilter,logoutFilter,securityContextHolderAwareRequestFilter,dash1AnonymousProcessingFilter,filterInvocationInterceptor

/dashboard2*=httpSessionContextIntegrationFilter,logoutFilter,securityContextHolderAwareRequestFilter,dash2AnonymousProcessingFilter,filterInvocationInterceptor

/**=httpSessionContextIntegrationFilter,logoutFilter,authenticationProcessingFilter,basicProcessingFilter,securityContextHolderAwareRequestFilter,anonymousProcessingFilter,exceptionTranslationFilter,filterInvocationInterceptor

...大约在文件一半的位置,查找 <bean id="filterInvocationInterceptor" …>。

在 /dashboard.jsp 的条目下面,为每个别名添加一个条目:

<bean id="filterInvocationInterceptor" class="org.acegisecurity.intercept.web.FilterSecurityInterceptor">

...

/frontpage.htm=ROLE_USER,ROLE_DASHBOARD

/dashboard.jsp=ROLE_USER,ROLE_DASHBOARD

/dashboard1=ROLE_USER,ROLE_DASHBOARD

/dashboard2=ROLE_USER,ROLE_DASHBOARD

/gwt.js=ROLE_USER,ROLE_DASHBOARD

...最后,在文件底部附近,为每个别名添加一个新的 AnonymousProcessingFilter 实例。

<!-- Set the anonymous username to dashboard1 so the dashboard page

can match it to a surveillance view of the same name. -->

<bean id="dash1AnonymousProcessingFilter" class="org.acegisecurity.providers.anonymous.AnonymousProcessingFilter">

<property name="key"><value>foobar</value></property>

<property name="userAttribute"><value>dashboard1,ROLE_DASHBOARD</value></property>

</bean>

<bean id="dash2AnonymousProcessingFilter" class="org.acegisecurity.providers.anonymous.AnonymousProcessingFilter">

<property name="key"><value>foobar</value></property>

<property name="userAttribute"><value>dashboard2,ROLE_DASHBOARD</value></property>

</bean>重新启动 OpenNMS Horizon,你应该在没有登录的情况下,在 http://…/opennms/dashboard1 上显示一个 dashboard。

| 不关闭浏览器 (或删除 JSESSIONID session cookie) 就无法切换 dashboards。 |

如果你不小心点击了需要完全用户权限的链接 (例如,设备列表),你将获得一个登录表单。

进入登录表单后,如果不重新启动浏览器,则无法返回 dashboard。

如果这个问题困扰你,你可以在你的 userAttribute 属性中在 ROLE_DASHBOARD 后添加 ROLE_USER。

但是,这将使用户完全可以访问匿名浏览器。

|

3.3. Grafana Dashboard Box

Grafana 提供了一个 API key,可以访问第三方应用程序,如 OpenNMS Horizon。 在 Grafana Dashboard Box 的开始页面上显示 OpenNMS Horizon 相关的 dashboards。 要过滤相关 dashboards,你可以使用 tag 来让 dashboards 可访问。 如果没有提供 tag,将显示 Grafana 中的所有 dashboards。

默认情况下,该功能停用,可以通过 opennms.properties 进行配置。请注意,

此功能适用于 Grafana API v2.5.0。

| 名称 | 类型 | 描述 | 默认值 |

|---|---|---|---|

|

Boolean |

此设置控制是否在展示页面上显示可用 dashboards 的 grafana 框。

有两个有效选项是 |

|

|

String |

如果启用 box,则还需要指定 Grafana 服务器的主机名 |

|

|

Integer |

Grafana 服务器 ReST API 的端口 |

|

|

String |

要使用的 Grafana 基本路径 |

|

|

String |

ReST 调用需要 API key 才能工作 |

|

|

String |

当指定 tag 时,仅显示此给定 tag 的 dashboards。 如果没有给出 tag,则将显示所有 dashboards。 |

|

|

String |

也可以指定 ReST 调用的协议 |

|

|

Integer |

从 Grafana 服务器获取信息的超时, 以毫秒为单位 |

|

|

Integer |

Socket 超时 |

|

|

Integer |

要显示的最大条目数 (0 表示无限制) |

|

如果 Grafana 在代理后面,则可以通过 org.opennms.grafanaBox.hostname 访问。

此主机名用于生成指向 Grafana dashboards 的链接。

|

生成 Grafana API Key 的过程可以在 HTTP API 文档 中找到。

将 API Key 复制到 opennms.properties 文件中的 org.opennms.grafanaBox.apiKey。

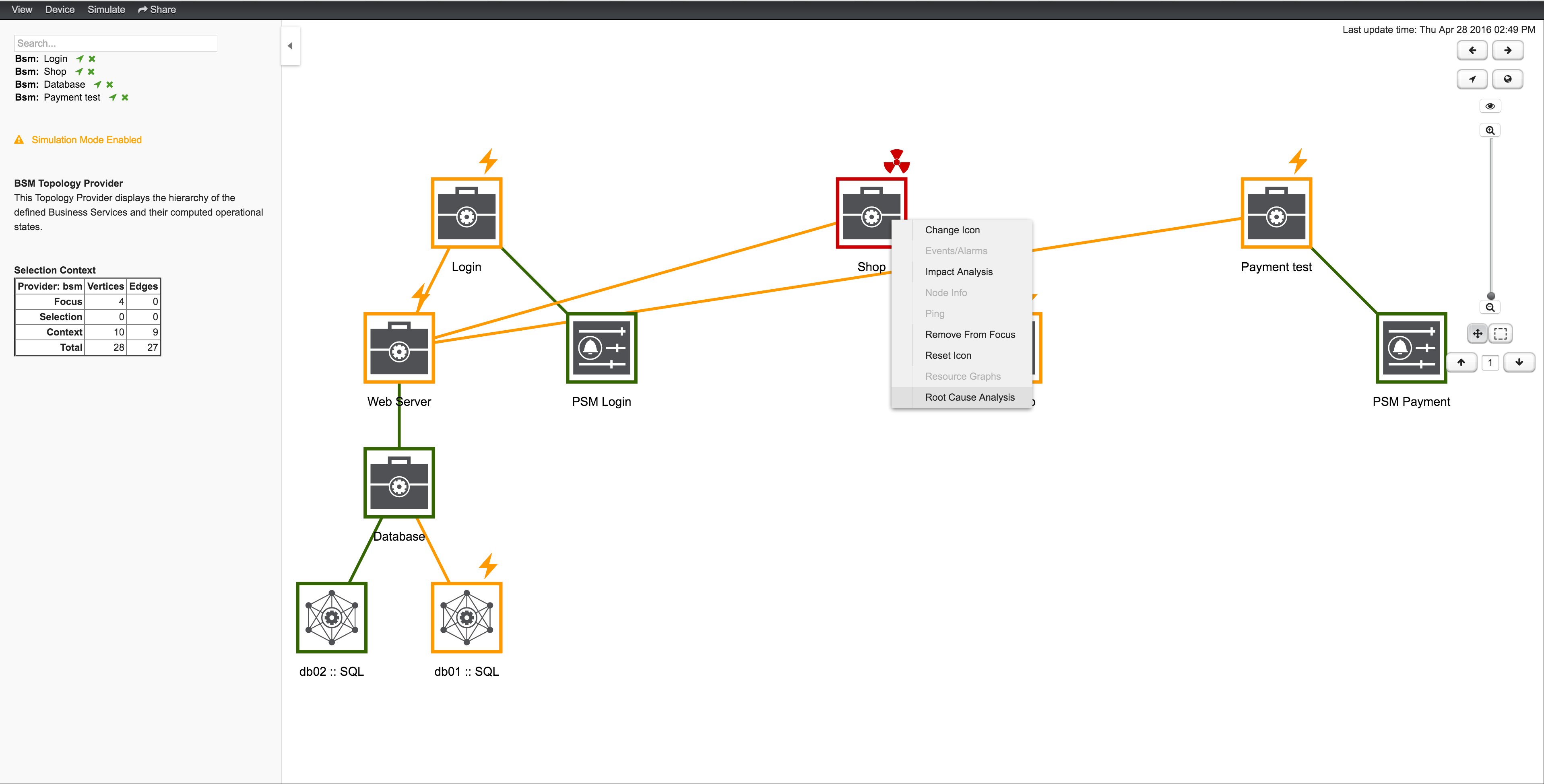

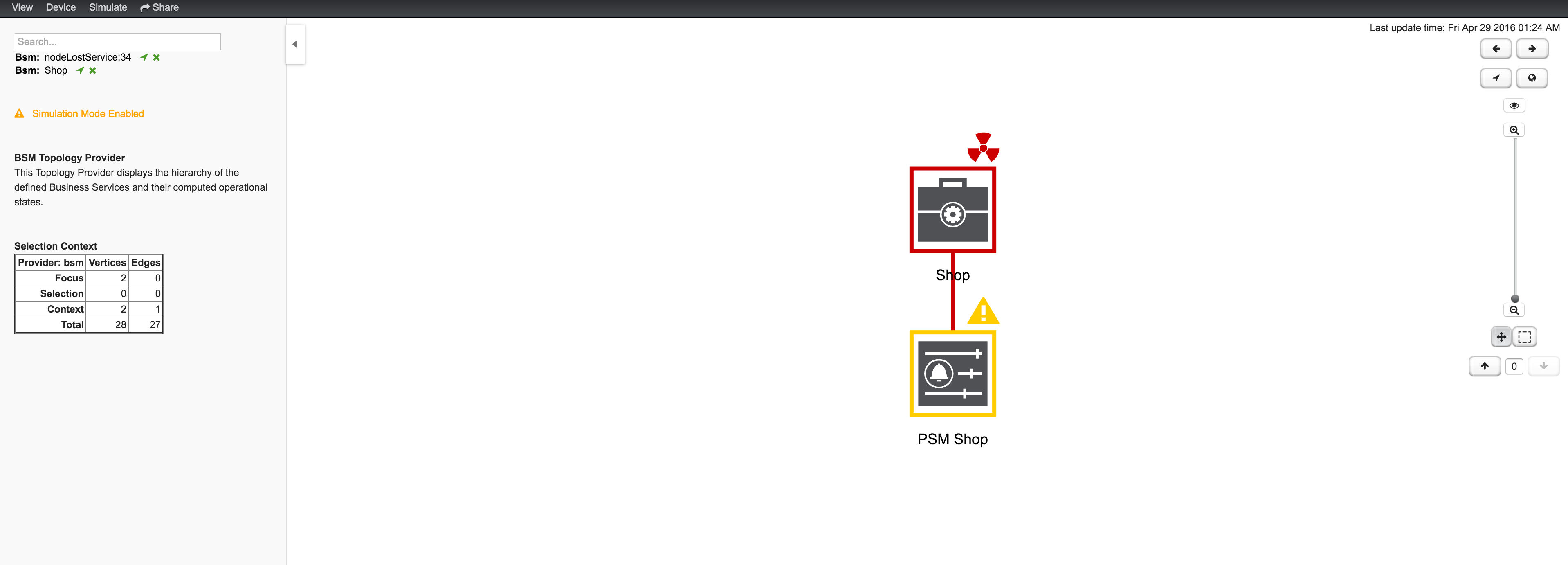

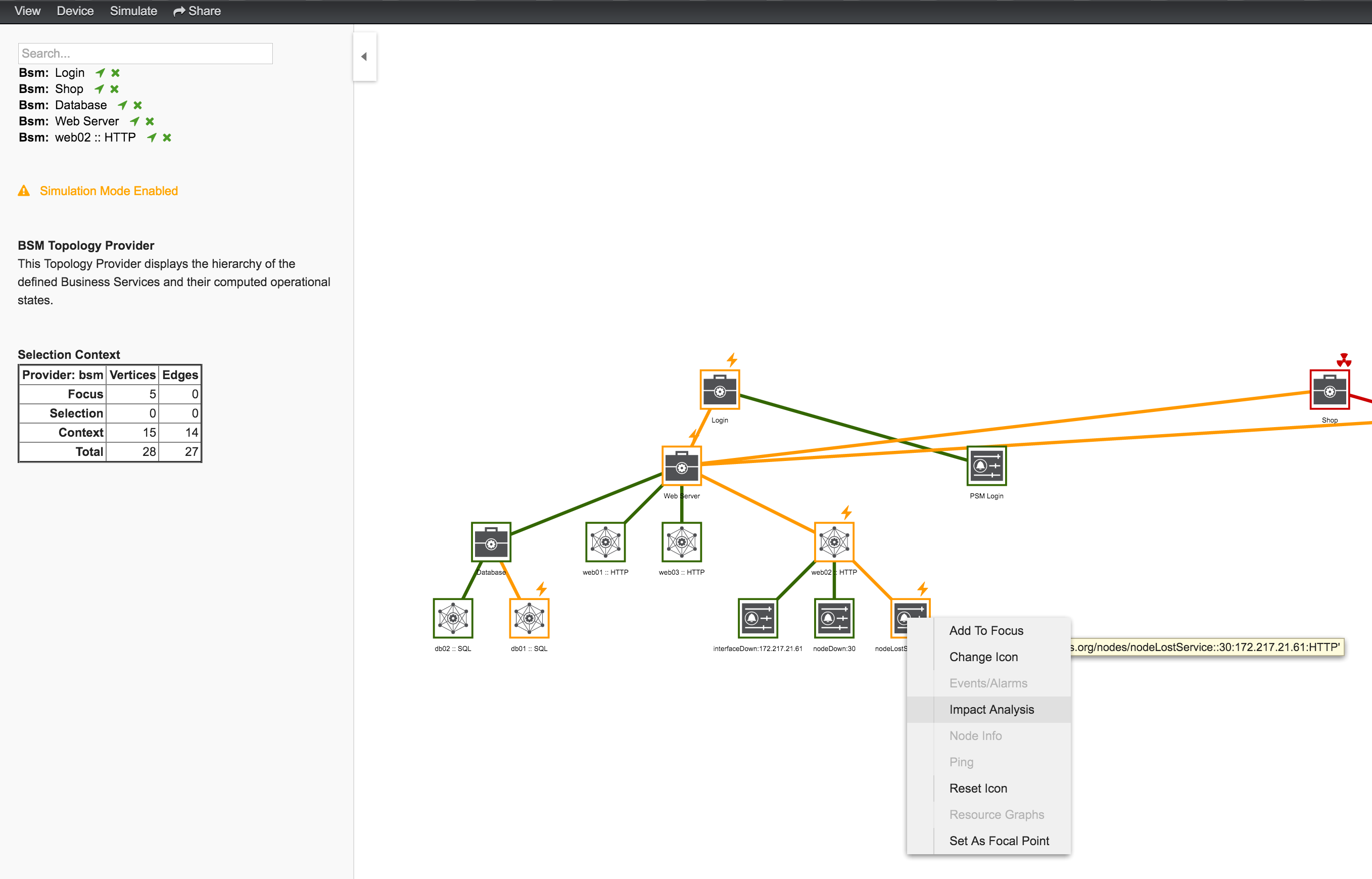

3.4. Operator Board

在网络操作中心 (NOC) 中,Ops Board 用于可视化监控信息。 各种用例的监视信息以可配置的 Dashlets 排列。 为了解决不同的用户组,可以创建多个 Ops Boards。

有两个可视化组件可以显示 Dashlets:

-

Ops Panel: 在一个屏幕上显示多个 Dashlets,例如 在 NOC 操作员工作站上

-

Ops Board: 一次滚动显示一个 Dashlet,例如,用于 NOC 中的大屏幕

3.4.1. 配置

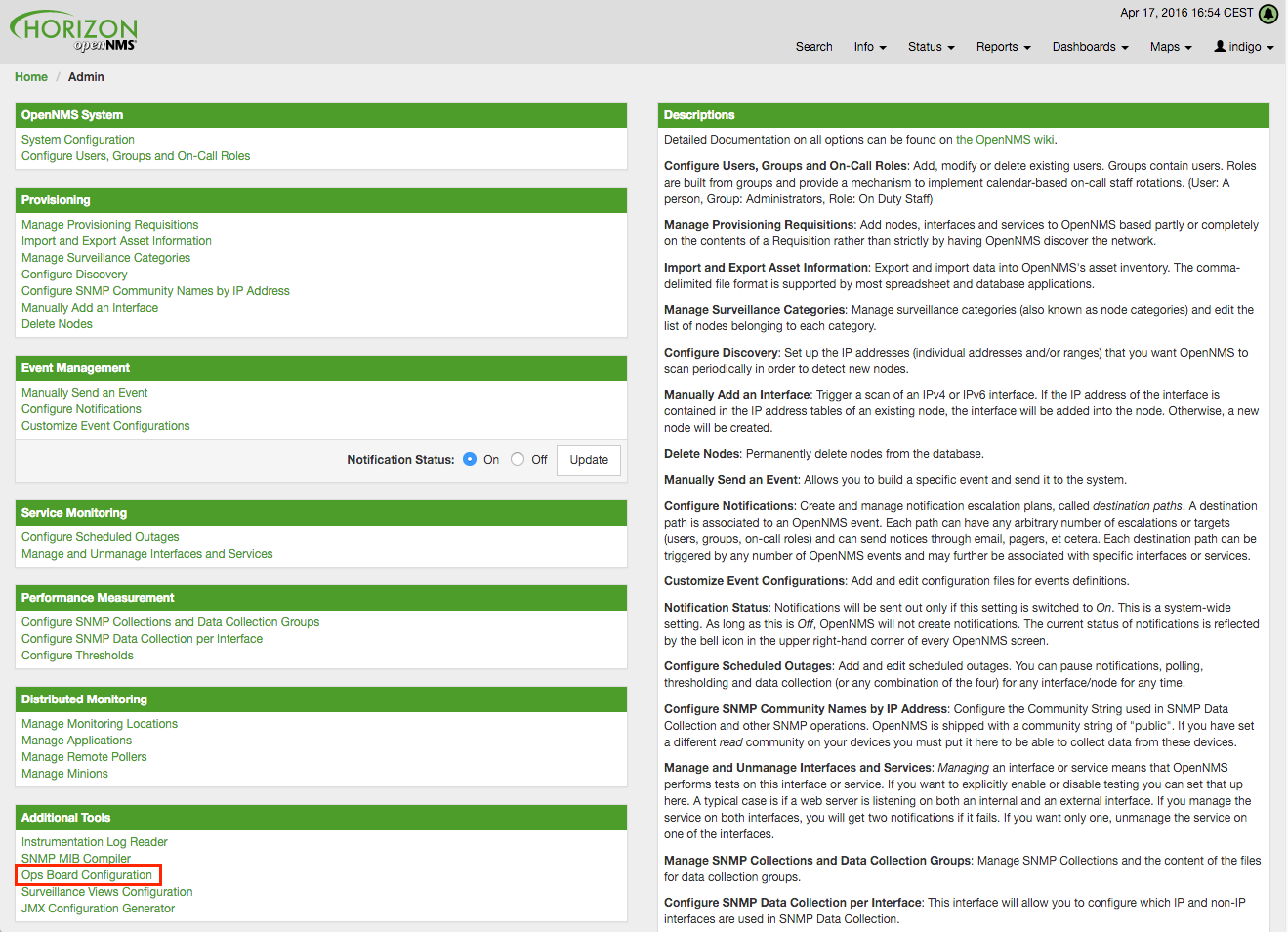

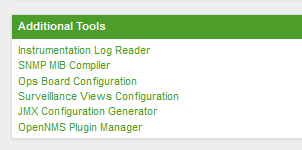

要创建和配置 Ops Boards,需要管理员权限。 配置部分位于 OpenNMS Horizon 的管理区域中,名称是 Ops Board Config Web Ui。

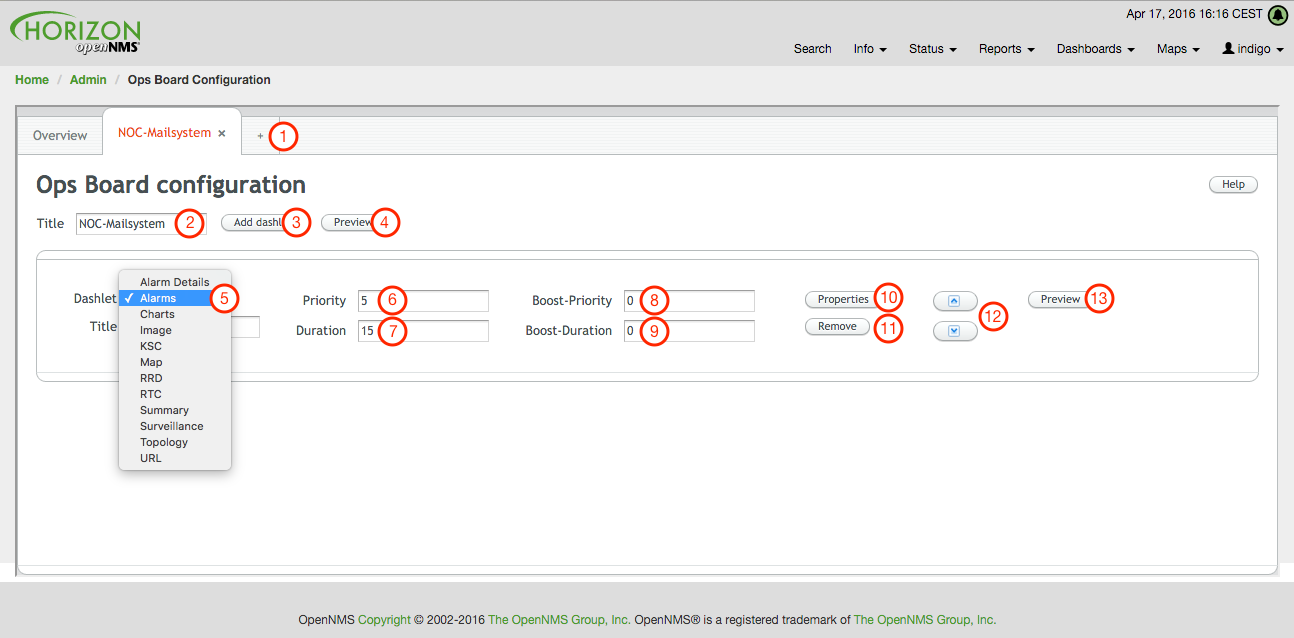

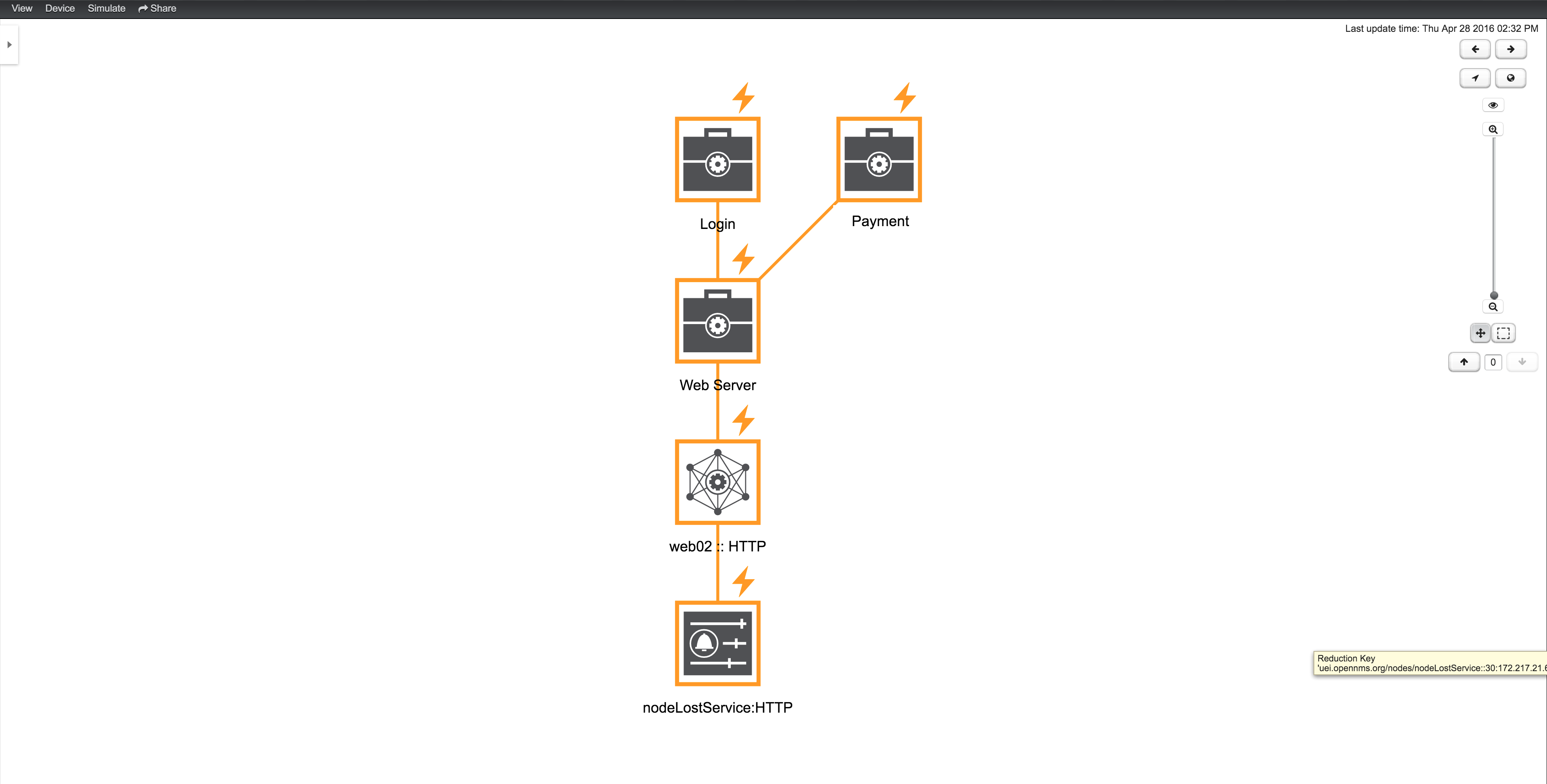

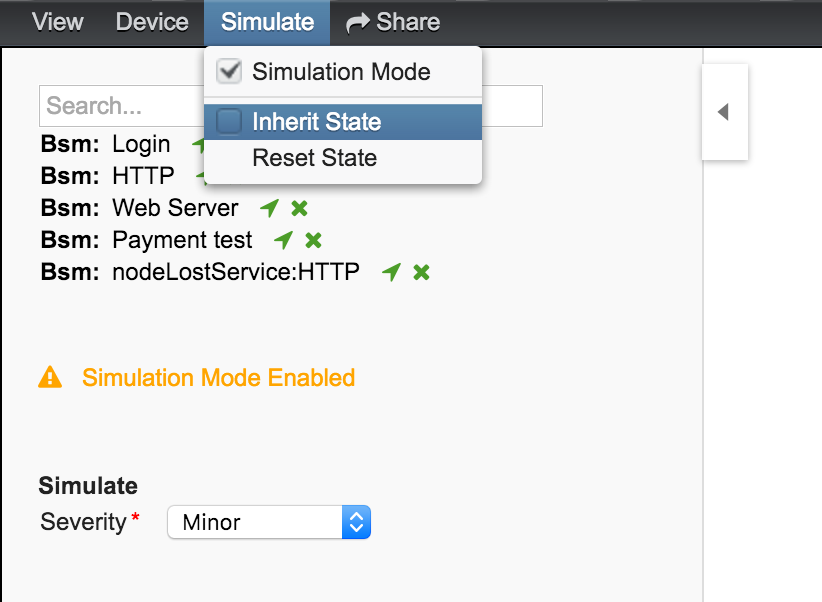

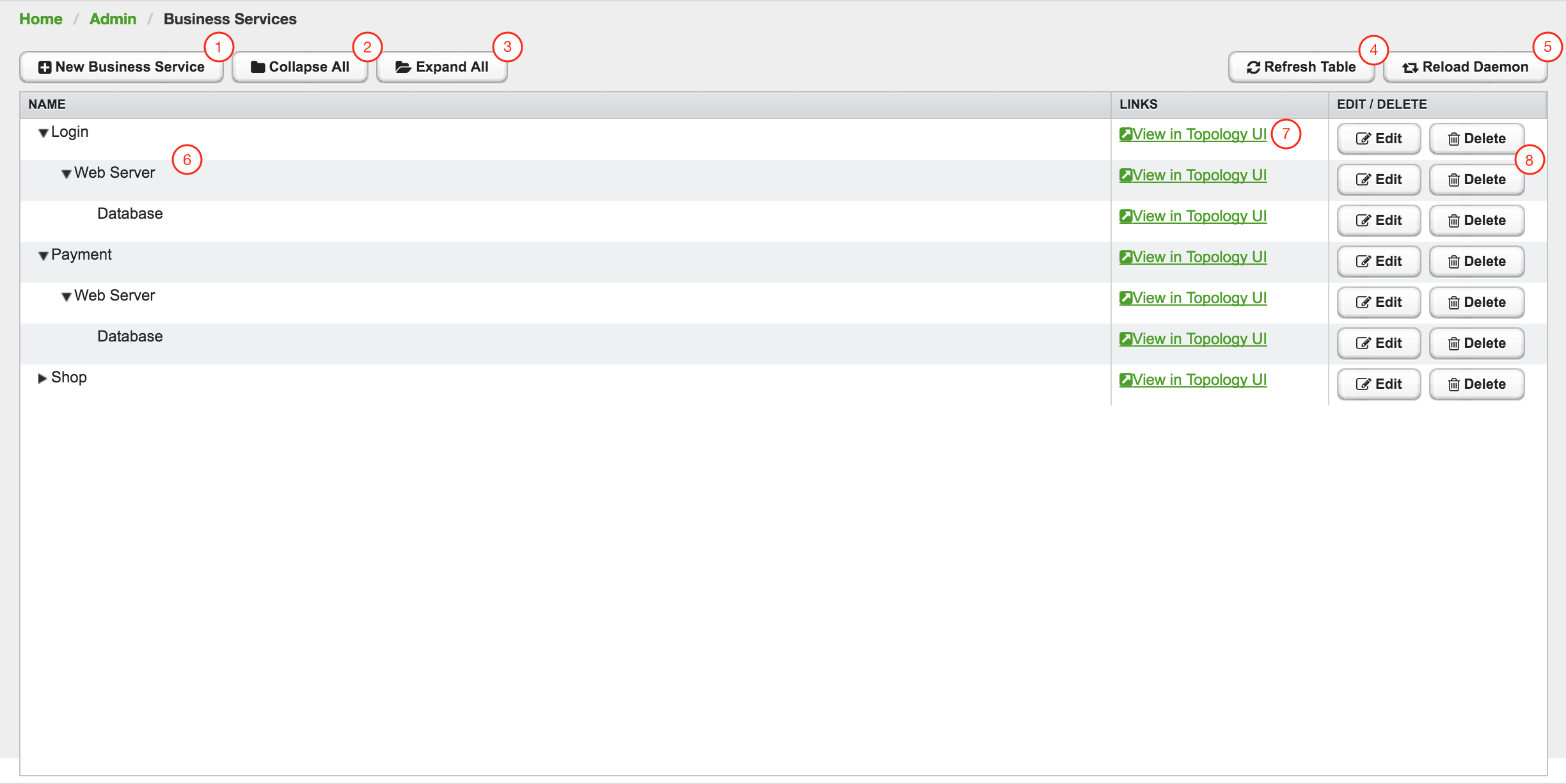

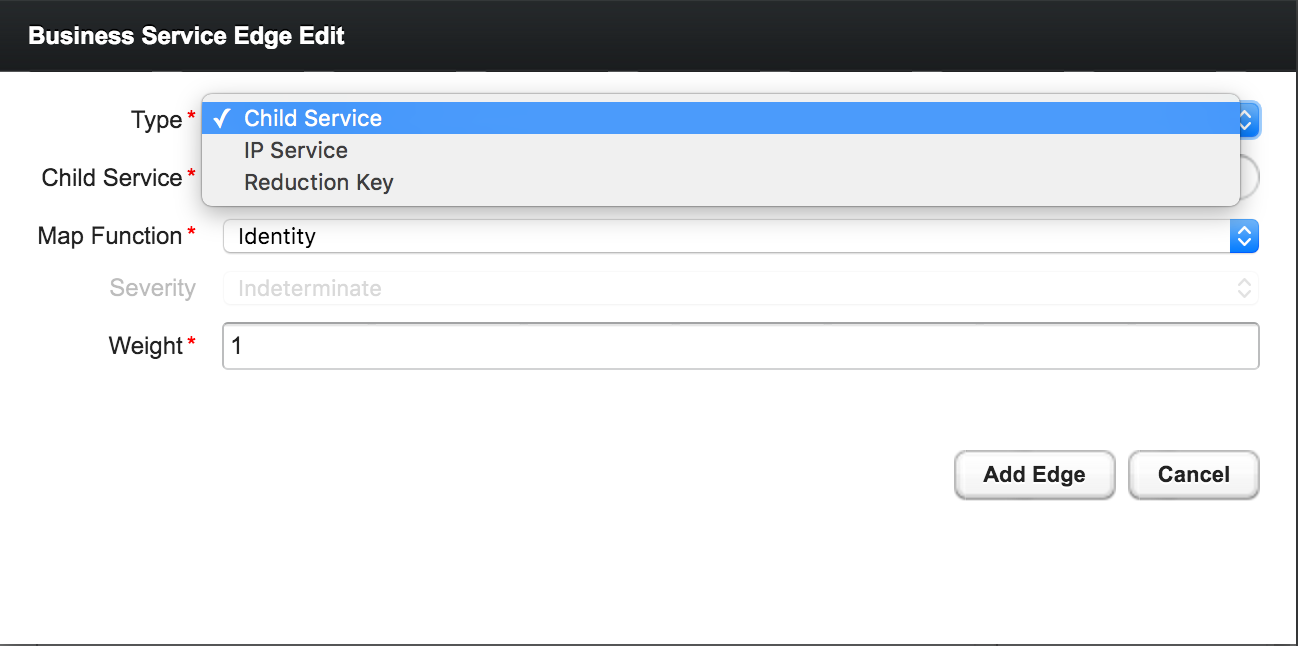

以下屏幕截图中描述了创建和修改 Ops Boards。

-

创建一个新的 Ops Board,来组织和安排不同的 Dashlets

-

用于标识 Ops Board 的名称

-

添加 Dashlet 以显示 OpenNMS Horizon 监控信息

-

显示整个 Ops Board 预览

-

可用的 Dashlets 列表

-

Dashlet 在 Ops Board 中滚动的 优先级,较低优先级意味着它将更频繁地显示

-

Dashlet 在 Ops Board 中滚动显示的 持续时间,以秒为单位

-

如果 Dashlet 处于告警状态,则更改 优先级,这是可选的,并且可能并非在所有 Dashlets 中都可用

-

如果 Dashlet 处于告警状态,则更改 持续时间,这是可选的,并且可能并非所有 Dashlets 中都可用

-

此 Dashlet 的配置属性

-

从 Ops Board 中删除此 Dashlet

-

Dashlets 在 Ops Board 上的滚动顺序,和在 Ops Panel 中的标题视图

-

显示整个 Ops Board 的预览

通过在主菜单中导航到 Dashboard → Ops Board,可用配置 Ops Board。

3.4.2. Dashlets

在 Dashlets 中实现信息的可视化。 本节将介绍不同 Dashlets 具有的所有可用配置参数。

Dashlet 要配置过滤信息,可用使用通用 Criteria Builder。

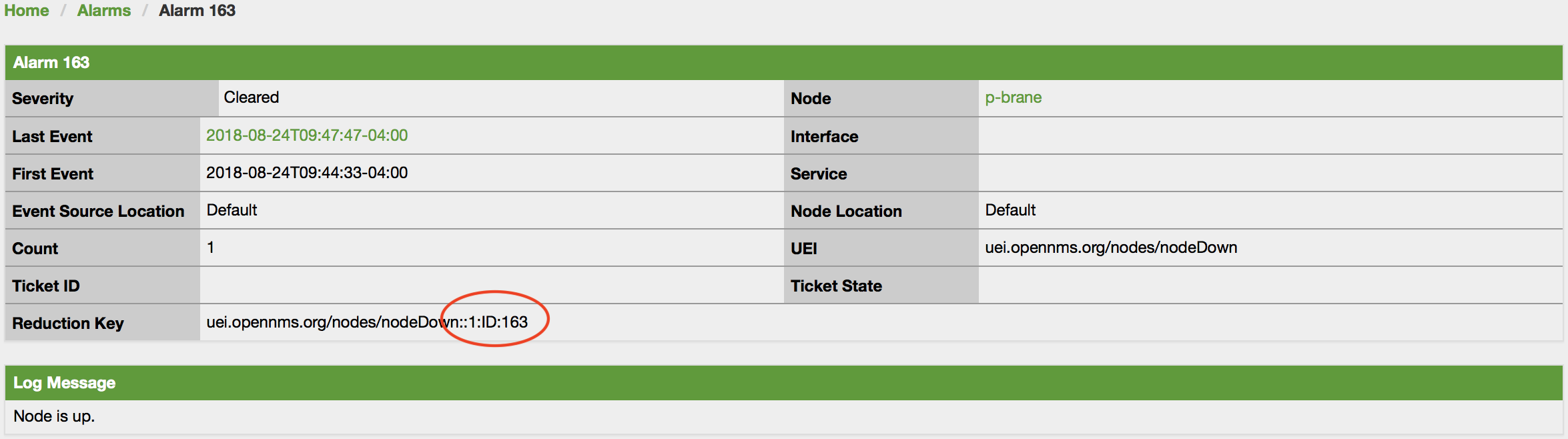

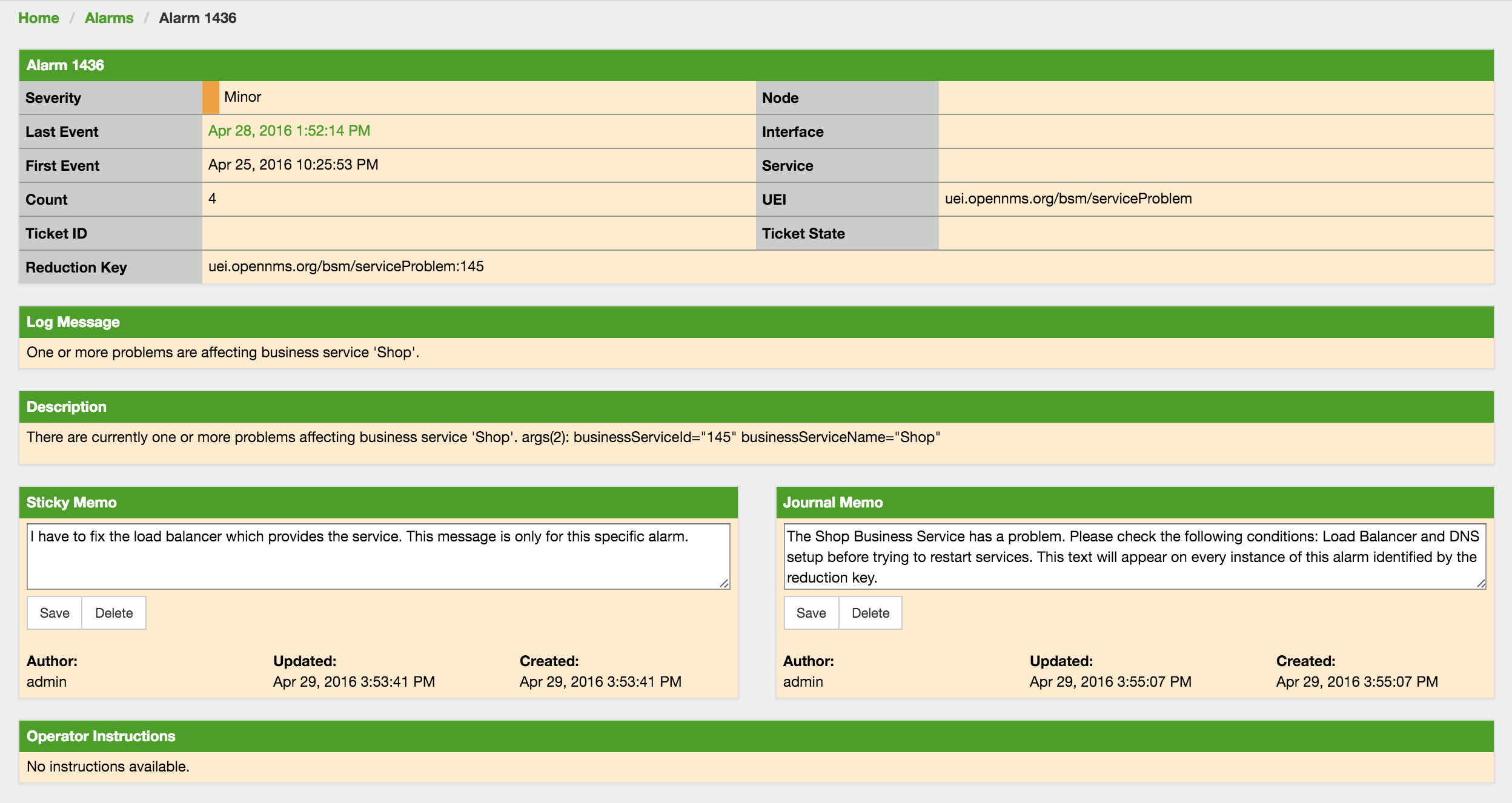

告警详情

此 告警-详情 Dashlet 显示一个包含告警和详细信息的表。

| 字段 | 描述 |

|---|---|

告警 ID |

OpenNMS Horizon 的告警 ID |

严重级别 |

告警严重性 (Cleared, Indeterminate, Normal, Warning, Minor, Major, Critical) |

设备名称 |

发生告警的设备名称 |

告警次数 |

告警重复发生次数 |

最后事件时间 |

告警最后发生时间 |

日志消息 |

告警的原因和详细日志消息 |

可以使用以下参数配置 告警详情 Dashlet。

提升支持 |

|

配置 |

告警

此 告警 Dashlet 显示一个具有短告警描述的表。

| 字段 | 描述 |

|---|---|

时间 |

告警出现的绝对时间 |

设备名称 |

发生告警的设备名称 |

UEI |

OpenNMS Horizon 告警的 唯一事件标识符 |

可以使用以下参数配置 告警 Dashlet。

提升支持 |

|

配置 |

图表

此 Dashlet 显示现有 图表。

提升支持 |

false |

|

要显示的现有图表的名称 |

|

重新缩放图像以填充显示宽度 |

|

重新缩放图像以填充显示高度 |

Grafana

此 Dashlet 在给定时间范围内显示 Grafana Dashboard。

配置文件 opennms.properties 中定义的 Grafana Dashboard Box 配置用于访问 Grafana 实例。

提升支持 |

false |

|

要显示的 Grafana dashboard 的标题 |

|

要显示的 Grafana Dashboard 的 URI |

|

开始时间范围 |

|

结束时间范围 |

图片

此 Dashlet 按给定的 URL 显示图像。

提升支持 |

false |

|

要在此 Dashlet 中显示的图像的 URL |

|

重新缩放图像以填充显示高度 |

|

重新缩放图像以填充显示宽度 |

KSC(自定义报表)

此 Dashlet 显示现有的 KSC 报表。 该视图与 KSC 报表 相同,使用同样的排列和时间范围。

提升支持 |

false |

|

要在此 Dashlet 中显示的 KSC 报表的名称 |

RRD

此 Dashlet 显示一个或多个 RRD 图。 可以在多个列和行中排列和排序 RRD 图。 所有 RRD 图都使用给定的宽度和高度进行规划。

提升支持 |

false |

|

Dashlet 中的列数 |

|

Dashlet 中的行数 |

|

从现有 KSC 报表导入 RRD 图并重新排列。 |

|

此 Dashlet 中所有 RRD 图的通用宽度 |

|

此 Dashlet 中所有 RRD 图的通用高度 |

|

给定 |

|

RRD 图的,分,时,天,周,月和年 |

RTC

此 Dashlet 显示 OpenNMS Horizon 起始页中配置的 SLA 类别。

提升支持 |

false |

|

- |

拓扑图

此 Dashlet 显示 拓扑图。 可以使用以下参数配置 拓扑图。

提升支持 |

false |

|

指定哪个节点是拓扑图的焦点 |

|

应该显示哪种拓扑图,例如 Linkd, VMware |

|

设置拓扑图的缩放级别 |

URL

该 Dashlet 显示网页或其它网络应用程序的内容,例如,给定 URL 的其它监控系统。

提升支持 |

false |

|

如果需要基本身份验证,则为可选密码 |

|

web 应用程序或 web 网页的 URL |

|

如果需要基本身份验证,则为可选用户名 |

3.4.3. 提升 Dashlet

提升 Dashlet 的特性,是 Dashlet 用来显示关键监视信息的功能。 它可以提高在 Ops Board 中的优先级,以指示问题。 可以使用配置参数 Boost Priority 和 Boost Duration 配置此行为。 这些配置参数会影响 Ops Board 上的滚动行为。

-

Boost Priority: 具有关键监视信息的 Dashlet 的绝对优先级。

-

Boost Duration: 具有关键监视信息的 Dashlet 的绝对持续时间,单位秒。

3.4.4. Criteria Builder

Criteria Builder 是用于过滤 Dashlet 信息的通用组件。 某些 Dashlets 使用此组件来过滤 Dashlet 上显示的信息。 可以组合多个 Criteria,来仅显示指定 Dashlet 中的信息子集。

| 选项 | 属性 | 值1 | 值2 | 描述 |

|---|---|---|---|---|

|

- |

- |

- |

升序 |

|

- |

- |

- |

降序 |

|

数据库属性 |

String |

String |

值1和值2之间的数据子集 |

|

数据库属性 |

String |

- |

选择包含给定数据库属性中给定文本字符串的所有数据 |

|

数据库属性 |

- |

- |

选择一个实例 |

|

数据库属性 |

String |

- |

选择属性等于 ( |

|

数据库属性 |

String |

- |

选择属性大于等于 ( |

|

数据库属性 |

String |

- |

选择属性大于 ( |

|

数据库属性 |

String |

- |

unknown |

|

数据库属性 |

String |

- |

unknown |

|

数据库属性 |

String |

- |

选择属性与给定 IPLIKE 表达式匹配的数据 |

|

数据库属性 |

- |

- |

选择属性为 null 的数据 |

|

数据库属性 |

- |

- |

选择属性 不 为 null 的数据 |

|

数据库属性 |

String |

- |

选择属性小于等于 ( |

|

数据库属性 |

String |

- |

选择属性小于 ( |

|

数据库属性 |

String |

- |

选择属性类似于 SQL |

|

- |

Integer |

- |

将结果集限制为给定数字 |

|

数据库属性 |

String |

- |

选择属性不等于 ( |

|

数据库属性 |

String |

- |

unknown 区别于 |

|

数据库属性 |

- |

- |

按给定属性排序结果集 |

3.5. JMX 配置生成器

OpenNMS Horizon 实现 JMX 协议,以采集 Java 应用程序的长期性能数据。 可以的指标种类繁多,管理员必须要选择采集哪些信息。 JMX 配置生成工具 帮助构建生成 OpenNMS Horizon 的复杂 JMX 数据采集配置和 RRD 图 定义。

此工具有 CLI 和基于 web 的两个版本。

3.5.1. 基于 Web 的工具

可以从基于 web 的工具生成复杂的 JMX 数据采集配置。 它从启用了 JMX 的 Java 应用程序中采集所有可用的 MBean 属性 或 复合数据属性。

该工具的工作流程是:

-

通过 JMX 或 JMXMP 连接 Java 应用程序的相应 MBean Server

-

从应用程序中检索所有 MBean 和 复合数据

-

选择由 OpenNMS Horizon 需要采集的指定 MBeans 和 复合数据 对象

-

为 OpenNMS Horizon 生成 JMX Collectd 配置文件和 RRD 图 定义,并且可以作为档案下载

支持以下连接设置:

-

能够使用基于 RMI 的 JMX 连接到 MBean Server

-

JMX 连接的身份验证凭据

-

可选: JMXMP 连接

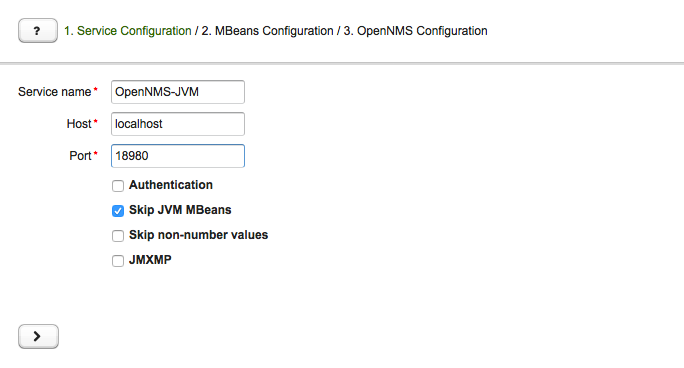

基于 web 的配置工具是在 OpenNMS Horizon Web 应用程序 中的管理部分 Admin → JMX Configuration Generator。

配置 JMX 连接

首先,必须配置与 Java 应用程序的 MBean Server 的连接。

-

Service name: 要为 Collectd 绑定 JMX 数据采集的服务名称

-

Host: 连接到 MBean Server 的 IP 地址或 FQDN,将 MBeans and 复合数据 加载到生成工具中

-

Port: 用于连接 MBean Server 的端口

-

Authentication: 使用用户名和密码启用 / 禁用 JMX 连接的身份验证

-

Skip non-number values: 使用非数字值跳过属性

-

JMXMP: 启用 / 禁用 JMX Messaging Protocol,而不是使用 JMX over RMI

通过单击箭头 ( > ) 将使用给定的连接设置检索 MBeans 和 复合数据。 数据被加载到 MBeans 配置 页面,该页面允许选择要采集的指标配置。

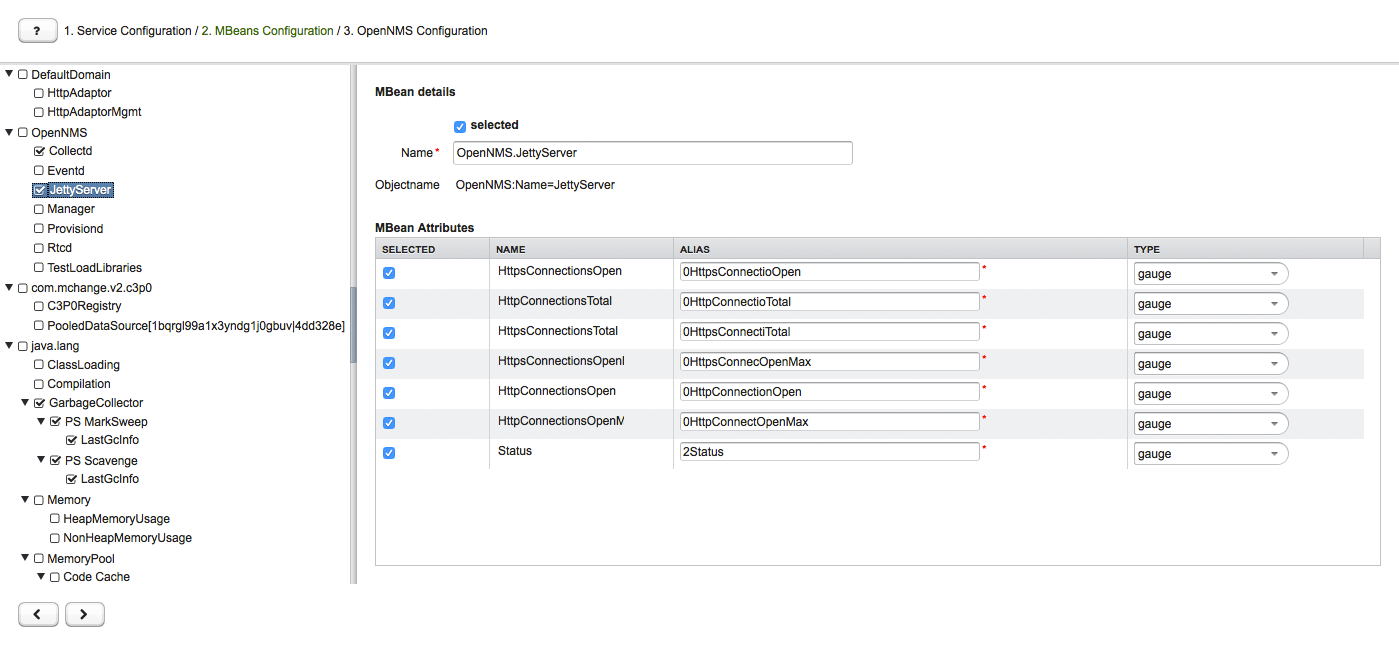

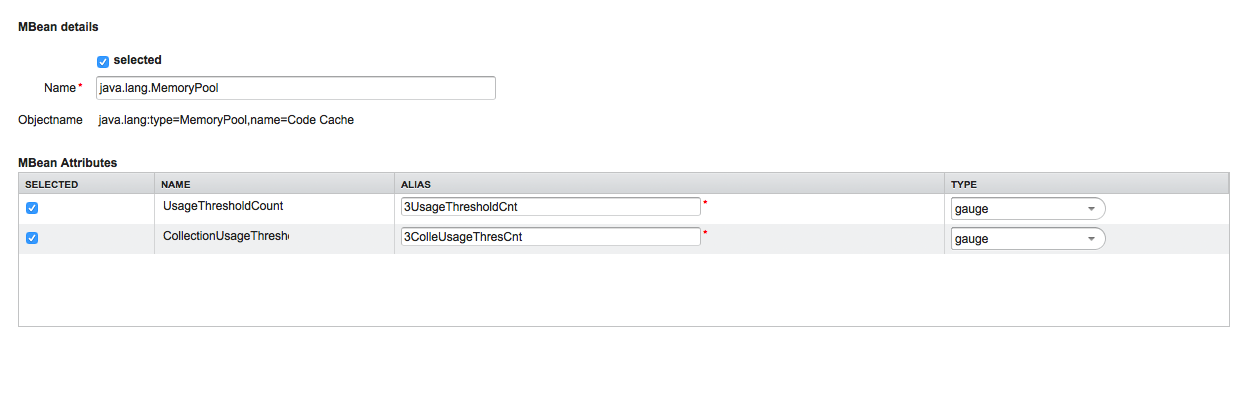

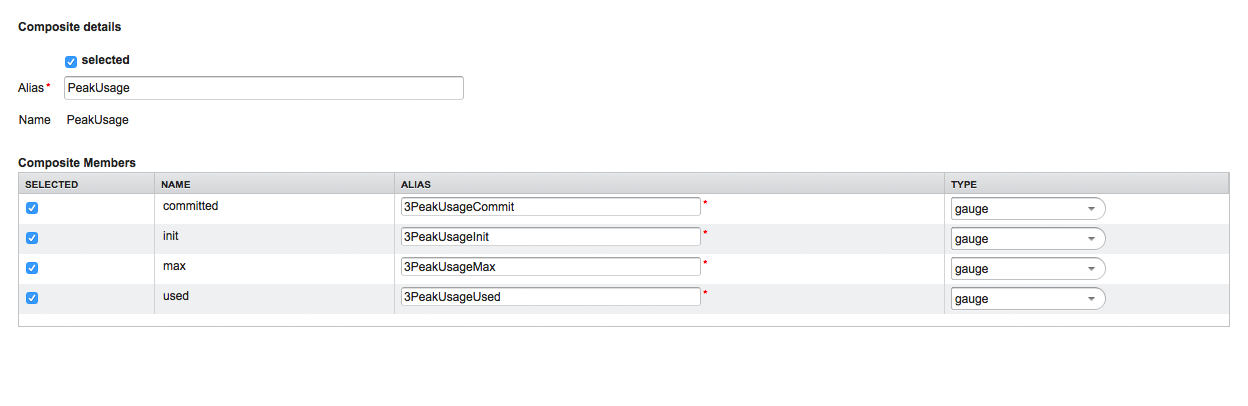

选择 MBeans 和 复合数据

MBeans 配置 部分用于将 MBean 和 复合数据属性 分配给 RRD 域 的指定数据类型和数据源名称。

左侧边栏显示数结构,其中包含从 MBean Server 检索到的 JMX Domain, MBeans 和 复合数据 层次结构。 要选择或取消选择所有属性,请使用 鼠标右键单击 → select/deselect。

右侧面板显示带有 RRD 特定映射的 MBean 属性,并允许为数据采集配置选择或取消选择特定的 MBean 属性 或 复合数据属性。

-

MBean Name or Composite Alias: 标识 MBean 或 复合数据 对象

-

Selected: 启用/禁用 MBean 属性 或 复合成员 以包含在数据采集配置中

-

Name: MBean 属性 或 复合成员 的名称

-

Alias: 用于在 RRD 或 JRobin 文件中存储指标度量的 数据源名称

-

Type: Gauge 或 Counter 数据类型,用于在 RRD 或 JRobin 文件中存储指标度量

MBean Name, Composite Alias 和 Name 需要进行特殊字符验证。 对于 Alias 输入,要不超过19个字符,并且必须在数据采集配置中是唯一的。

下载和引入配置

最后一步是为 OpenNMS Horizon 生成以下配置文件:

-

collectd-configuration.xml: 生成的样本配置分配给匹配数据采集组的服务

-

jmx-datacollection-config.xml: 使用选定的 MBeans 和 复合数据 生成 JMX 数据集合配置

-

snmp-graph.properties: 为所有选定的指标生成默认的 RRD 图定义文件

可以复制和粘贴配置文件的内容,也可以将其下载为 ZIP 存档。

| 如果配置文件的内容超过2,500行,则只能将文件下载为 ZIP 存档。 |

3.5.2. CLI based utility

The command line (CLI) based tool is not installed by default. It is available as Debian and RPM package in the official repositories.

Installation

yum install opennms-jmx-config-generatorapt-get install opennms-jmx-config-generatorIt is required to have the Java 8 Development Kit with Apache Maven installed.

The mvn binary has to be in the path environment.

After cloning the repository you have to enter the source folder and compile an executable JAR.

cd opennms/features/jmx-config-generator

mvn packageInside the newly created target folder a file named jmxconfiggenerator-<VERSION>-onejar.jar is present.

This file can be invoked by:

java -jar target/jmxconfiggenerator-23.0.1-onejar.jarUsage

After installing the the JMX Config Generator the tool’s wrapper script is located in the ${OPENNMS_HOME}/bin directory.

$ cd /path/to/opennms/bin

$ ./jmx-config-generator| When invoked without parameters the usage and help information is printed. |

The JMX Config Generator uses sub-commands for the different configuration generation tasks. Each of these sub-commands provide different options and parameters. The command line tool accepts the following sub-commands.

| Sub-command | Description |

|---|---|

|

Queries a MBean Server for certain MBeans and attributes. |

|

Generates a valid |

|

Generates a RRD graph definition file with matching graph definitions for a given |

The following global options are available in each of the sub-commands of the tool:

| Option/Argument | Description | Default |

|---|---|---|

|

Show help and usage information. |

false |

|

Enables verbose mode for debugging purposes. |

false |

Sub-command: query

This sub-command is used to query a MBean Server for it’s available MBean objects.

The following example queries the server myserver with the credentials myusername/mypassword on port 7199 for MBean objects in the java.lang domain.

./jmx-config-generator query --host myserver --username myusername --password mypassword --port 7199 "java.lang:*"

java.lang:type=ClassLoading

description: Information on the management interface of the MBean

class name: sun.management.ClassLoadingImpl

attributes: (5/5)

TotalLoadedClassCount

id: java.lang:type=ClassLoading:TotalLoadedClassCount

description: TotalLoadedClassCount

type: long

isReadable: true

isWritable: false

isIs: false

LoadedClassCount

id: java.lang:type=ClassLoading:LoadedClassCount

description: LoadedClassCount

type: int

isReadable: true

isWritable: false

isIs: false

<output omitted>The following command line options are available for the query sub-command.

| Option/Argument | Description | Default |

|---|---|---|

|

A filter criteria to query the MBean Server for.

The format is |

- |

|

Hostname or IP address of the remote JMX host. |

- |

|

Only show the ids of the attributes. |

false |

|

Set |

- |

|

Include attribute values. |

false |

|

Use JMXMP and not JMX over RMI. |

false |

|

Password for JMX authentication. |

- |

|

Port of JMX service. |

- |

|

Only lists the available domains. |

true |

|

Includes MBeans, even if they do not have attributes.

Either due to the |

false |

|

Custom connection URL |

- |

|

Username for JMX authentication. |

- |

|

Show help and usage information. |

false |

|

Enables verbose mode for debugging purposes. |

false |

Sub-command: generate-conf

This sub-command can be used to generate a valid jmx-datacollection-config.xml for a given set of MBean objects queried from a MBean Server.

The following example generate a configuration file myconfig.xml for MBean objects in the java.lang domain of the server myserver on port 7199 with the credentials myusername/mypassword.

You have to define either an URL or a hostname and port to connect to a JMX server.

jmx-config-generator generate-conf --host myserver --username myusername --password mypassword --port 7199 "java.lang:*" --output myconfig.xml

Dictionary entries loaded: '18'The following options are available for the generate-conf sub-command.

| Option/Argument | Description | Default |

|---|---|---|

|

A list of attribute Ids to be included for the generation of the configuration file. |

- |

|

Path to a dictionary file for replacing attribute names and part of MBean attributes. The file should have for each line a replacement, e.g. Auxillary:Auxil. |

- |

|

Hostname or IP address of JMX host. |

- |

|

Use JMXMP and not JMX over RMI. |

false |

|

Output filename to write generated |

- |

|

Password for JMX authentication. |

- |

|

Port of JMX service |

- |

|

Prints the used dictionary to STDOUT.

May be used with |

false |

|

The Service Name used as JMX data collection name. |

anyservice |

|

Skip default JavaVM Beans. |

false |

|

Skip attributes with non-number values |

false |

|

Custom connection URL |

- |

|

Username for JMX authentication |

- |

|

Show help and usage information. |

false |

|

Enables verbose mode for debugging purposes. |

false |

The option --skipDefaultVM offers the ability to ignore the MBeans provided as standard by the JVM and just create configurations for the MBeans provided by the Java Application itself.

This is particularly useful if an optimized configuration for the JVM already exists.

If the --skipDefaultVM option is not set the generated configuration will include the MBeans of the JVM and the MBeans of the Java Application.

|

Check the file and see if there are alias names with more than 19 characters.

This errors are marked with NAME_CRASH_AS_19_CHAR_VALUE

|

Sub-command: generate-graph

This sub-command generates a RRD graph definition file for a given configuration file.

The following example generates a graph definition file mygraph.properties using the configuration in file myconfig.xml.

./jmx-config-generator generate-graph --input myconfig.xml --output mygraph.properties

reports=java.lang.ClassLoading.MBeanReport, \

java.lang.ClassLoading.0TotalLoadeClassCnt.AttributeReport, \

java.lang.ClassLoading.0LoadedClassCnt.AttributeReport, \

java.lang.ClassLoading.0UnloadedClassCnt.AttributeReport, \

java.lang.Compilation.MBeanReport, \

<output omitted>The following options are available for this sub-command.

| Option/Argument | Description | Default |

|---|---|---|

|

Configuration file to use as input to generate the graph properties file |

- |

|

Output filename for the generated graph properties file. |

- |

|

Prints the default template. |

false |

|

Template file using Apache Velocity template engine to be used to generate the graph properties. |

- |

|

Show help and usage information. |

false |

|

Enables verbose mode for debugging purposes. |

false |

Graph Templates

The JMX Config Generator uses a template file to generate the graphs.

It is possible to use a user-defined template.

The option --template followed by a file lets the JMX Config Generator use the external template file as base for the graph generation.

The following example illustrates how a custom template mytemplate.vm is used to generate the graph definition file mygraph.properties using the configuration in file myconfig.xml.

./jmx-config-generator generate-graph --input myconfig.xml --output mygraph.properties --template mytemplate.vmThe template file has to be an Apache Velocity template. The following sample represents the template that is used by default:

reports=#foreach( $report in $reportsList )

${report.id}#if( $foreach.hasNext ), \

#end

#end

#foreach( $report in $reportsBody )

#[[###########################################]]#

#[[##]]# $report.id

#[[###########################################]]#

report.${report.id}.name=${report.name}

report.${report.id}.columns=${report.graphResources}

report.${report.id}.type=interfaceSnmp

report.${report.id}.command=--title="${report.title}" \

--vertical-label="${report.verticalLabel}" \

#foreach($graph in $report.graphs )

DEF:${graph.id}={rrd${foreach.count}}:${graph.resourceName}:AVERAGE \

AREA:${graph.id}#${graph.coloreB} \

LINE2:${graph.id}#${graph.coloreA}:"${graph.description}" \

GPRINT:${graph.id}:AVERAGE:" Avg \\: %8.2lf %s" \

GPRINT:${graph.id}:MIN:" Min \\: %8.2lf %s" \

GPRINT:${graph.id}:MAX:" Max \\: %8.2lf %s\\n" \

#end

#endThe JMX Config Generator generates different types of graphs from the jmx-datacollection-config.xml.

The different types are listed below:

| Type | Description |

|---|---|

AttributeReport |

For each attribute of any MBean a graph will be generated. Composite attributes will be ignored. |

MbeanReport |

For each MBean a combined graph with all attributes of the MBeans is generated. Composite attributes will be ignored. |

CompositeReport |

For each composite attribute of every MBean a graph is generated. |

CompositeAttributeReport |

For each composite member of every MBean a combined graph with all composite attributes is generated. |

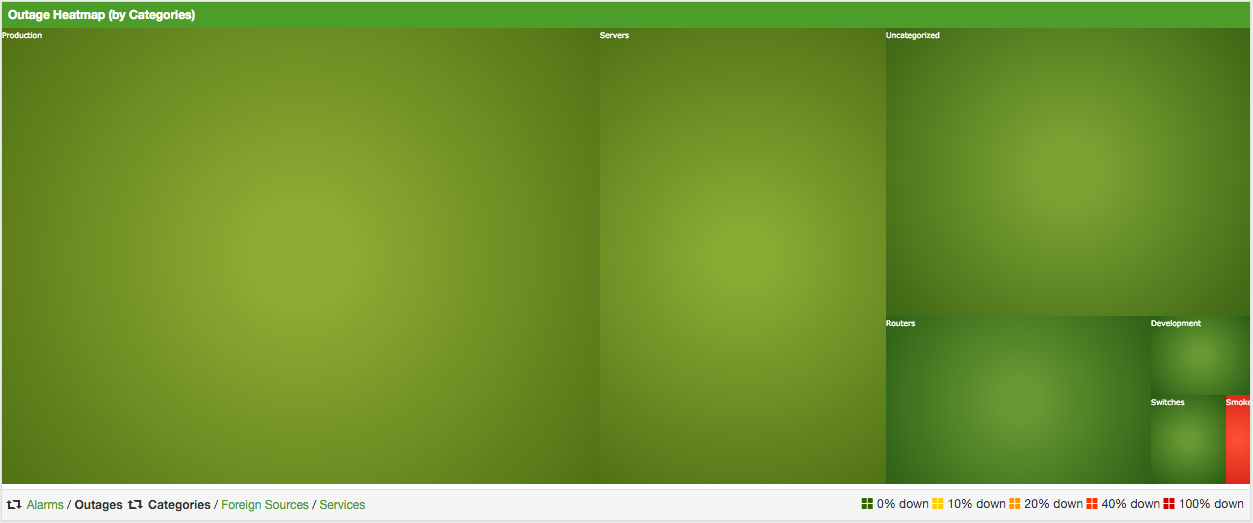

3.6. Heatmap

The Heatmap can be either be used to display unacknowledged alarms or to display ongoing outages of nodes. Each of this visualizations can be applied on categories, foreign sources or services of nodes. The sizing of an entity is calculated by counting the services inside the entity. Thus, a node with fewer services will appear in a smaller box than a node with more services.

The feature is by default deactivated and is configured through opennms.properties.

| Name | Type | Description | Default |

|---|---|---|---|

|

String |

There exist two options for using the heatmap: |

|

|

String |

This option defines which Heatmap is displayed by default.

Valid options are |

|

|

String |

The following option is used to filter for categories to be

displayed in the Heatmap. This option uses the Java regular

expression syntax. The default is |

|

|

String |

The following option is used to filter for foreign sources

to be displayed in the Heatmap. This option uses the Java

regular expression syntax. The default is |

|

|

String |

The following option is used to filter for services to be

displayed in the Heatmap. This option uses the Java regular

expression syntax. The default is |

|

|

Boolean |

This option configures whether only unacknowledged alarms will be taken into account when generating the alarm-based version of the Heatmap. |

|

|

String |

You can also place the Heatmap on the landing page by

setting this option to |

|

You can use negative lookahead expressions for excluding categories you wish not to be displayed in the heatmap,

e.g. by using an expression like ^(?!XY).* you can filter out entities with names starting with XY.

|

3.7. Trend

The Trend feature allows to display small inline charts of database-based statistics.

These chart are accessible in the Status menu of the OpenNMS' web application.

Furthermore it is also possible to configure these charts to be displayed on the OpenNMS' landing page.

To achieve this alter the org.opennms.web.console.centerUrl property to also include the entry /trend/trend-box.htm.

These charts can be configured and defined in the trend-configuration.xml file in your OpenNMS' etc directory.

The following sample defines a Trend chart for displaying nodes with ongoing outages.

<trend-definition name="nodes">

<title>Nodes</title> (1)

<subtitle>w/ Outages</subtitle> (2)

<visible>true</visible> (3)

<icon>glyphicon-fire</icon> (4)

<trend-attributes> (5)

<trend-attribute key="sparkWidth" value="100%"/>

<trend-attribute key="sparkHeight" value="35"/>

<trend-attribute key="sparkChartRangeMin" value="0"/>

<trend-attribute key="sparkLineColor" value="white"/>

<trend-attribute key="sparkLineWidth" value="1.5"/>

<trend-attribute key="sparkFillColor" value="#88BB55"/>

<trend-attribute key="sparkSpotColor" value="white"/>

<trend-attribute key="sparkMinSpotColor" value="white"/>

<trend-attribute key="sparkMaxSpotColor" value="white"/>

<trend-attribute key="sparkSpotRadius" value="3"/>

<trend-attribute key="sparkHighlightSpotColor" value="white"/>

<trend-attribute key="sparkHighlightLineColor" value="white"/>

</trend-attributes>

<descriptionLink>outage/list.htm?outtype=current</descriptionLink> (6)

<description>${intValue[23]} NODES WITH OUTAGE(S)</description> (7)

<query> (8)

<![CDATA[

select (

select

count(distinct nodeid)

from

outages o, events e

where

e.eventid = o.svclosteventid

and iflostservice < E

and (ifregainedservice is null

or ifregainedservice > E)

) from (

select

now() - interval '1 hour' * (O + 1) AS S,

now() - interval '1 hour' * O as E

from

generate_series(0, 23) as O

) I order by S;

]]>

</query>

</trend-definition>| 1 | title of the Trend chart, see below for supported variable substitutions |

| 2 | subtitle of the Trend chart, see below for supported variable substitutions |

| 3 | defines whether the chart is visible by default |

| 4 | icon for the chart, see Glyphicons for viable options |

| 5 | options for inline chart, see jQuery Sparklines for viable options |

| 6 | the description link |

| 7 | the description text, see below for supported variable substitutions |

| 8 | the SQL statement for querying the chart’s values |

| Don’t forget to limit the SQL query’s return values! |

It is possible to use values or aggregated values in the title, subtitle and description fields. The following table describes the available variable substitutions.

| Name | Type | Description |

|---|---|---|

|

Integer |

integer maximum value |

|

Double |

maximum value |

|

Integer |

integer minimum value |

|

Double |

minimum value |

|

Integer |

integer average value |

|

Double |

average value |

|

Integer |

integer sum of values |

|

Double |

sum of value |

|

Integer |

array of integer result values for the given SQL query |

|

Double |

array of result values for the given SQL query |

|

Integer |

array of integer value changes for the given SQL query |

|

Double |

array of value changes for the given SQL query |

|

Integer |

last integer value |

|

Double |

last value |

|

Integer |

last integer value change |

|

Double |

last value change |

You can also display a single graph in your JSP files by including the file /trend/single-trend-box.jsp and specifying the name parameter.

<jsp:include page="/trend/single-trend-box.jsp" flush="false">

<jsp:param name="name" value="example"/>

</jsp:include>4. 服务保障

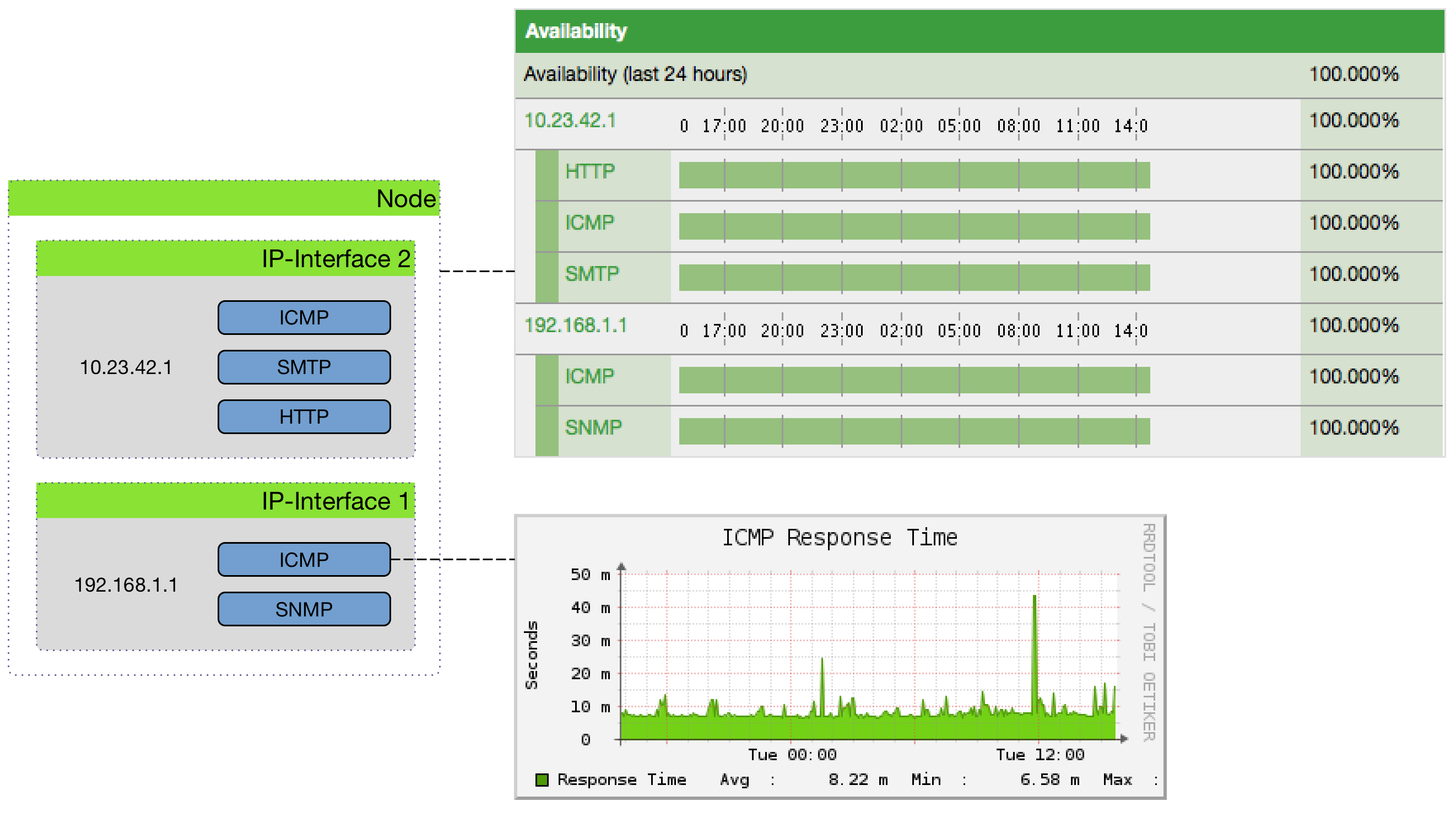

本节将介绍 OpenNMS Horizon 如何监测应用程序或管理代理的可用性和延迟的基本功能。

在 OpenNMS Horizon 中,这个任务由一个 服务监测器 框架提供。 主要组件是 Pollerd,它提供以下功能:

-

跟踪管理资源的可用性计算或应用程序的状态

-

度量服务质量的响应时间

-

基于 关键服务 的设备和接口故障的关联

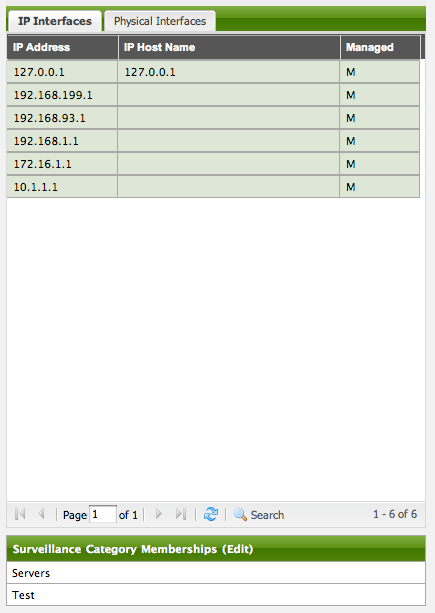

下面的图片显示了可用性和响应时间的模型和表示。

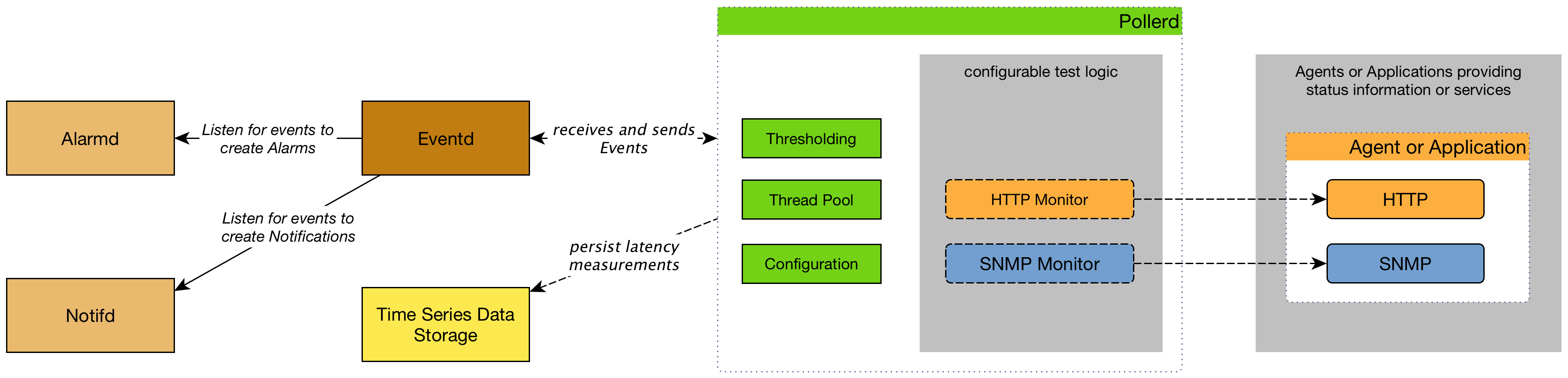

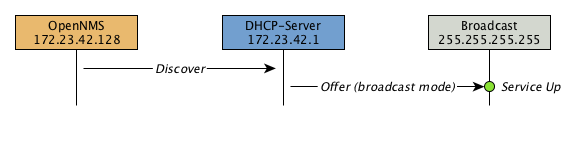

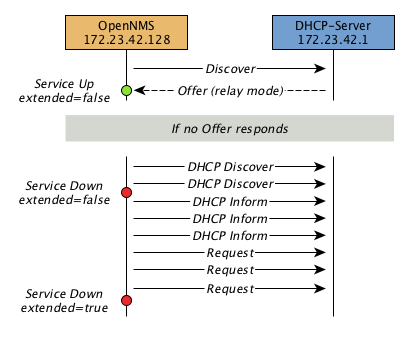

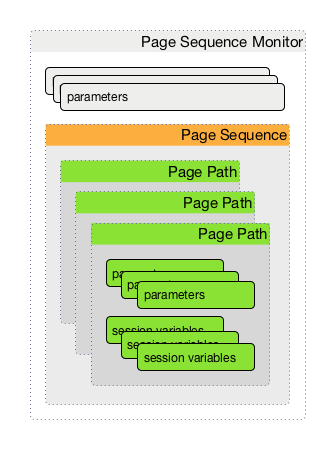

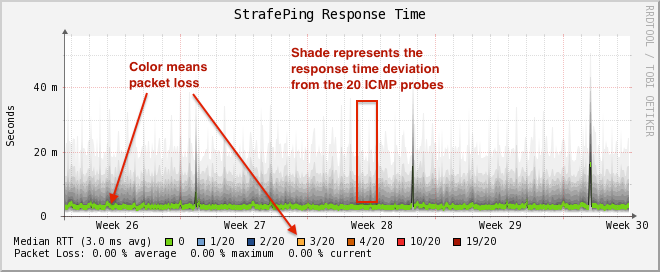

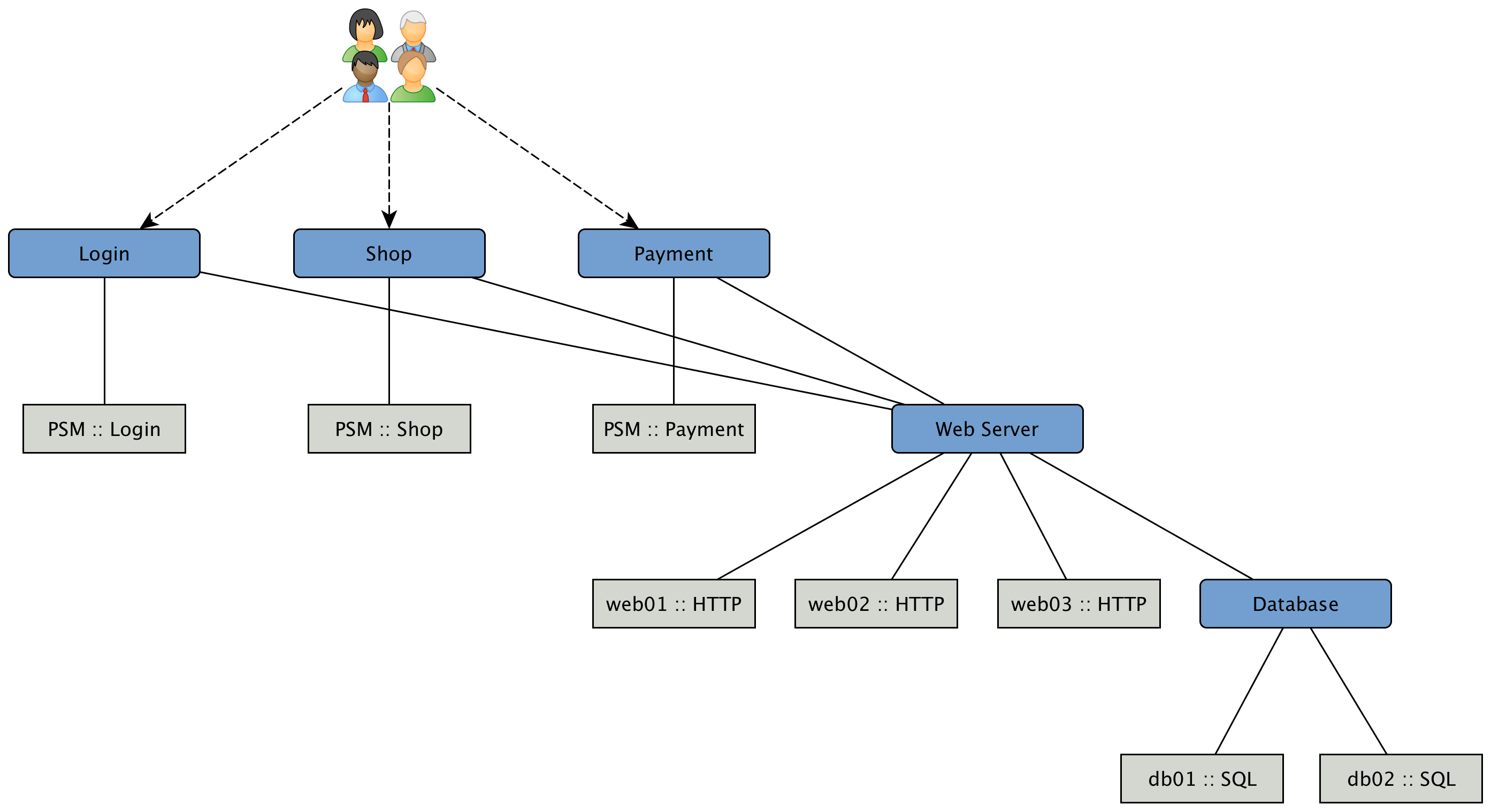

此信息基于调度的 服务监测器 ,并且由 Pollerd 执行。 服务 可以使用任意的名称,并与 服务监测器 相关联。 例如,我们可以定义两个 服务 HTTP 和 HTTP-8080,两个都和 HTTP 服务监测器 关联,但是配置不同的 TCP 端口 参数。 下图显示了 Pollerd 如何与 OpenNMS 中的其它组件以及要监控的应用程序或代理进行交互。

可用性计算的是过去24时内的,在 监测视图, SLA 分组 和 设备详情页面 显示。 响应时间被显示在 IP 接口 的 资源图表 中,在 设备详情页面。 通过单击 设备详情页面 上的 服务名称,可以查看 服务监测器 的配置参数。 服务 的状态可以是 Up 或 Down。

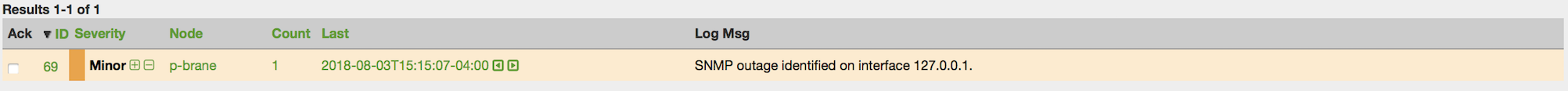

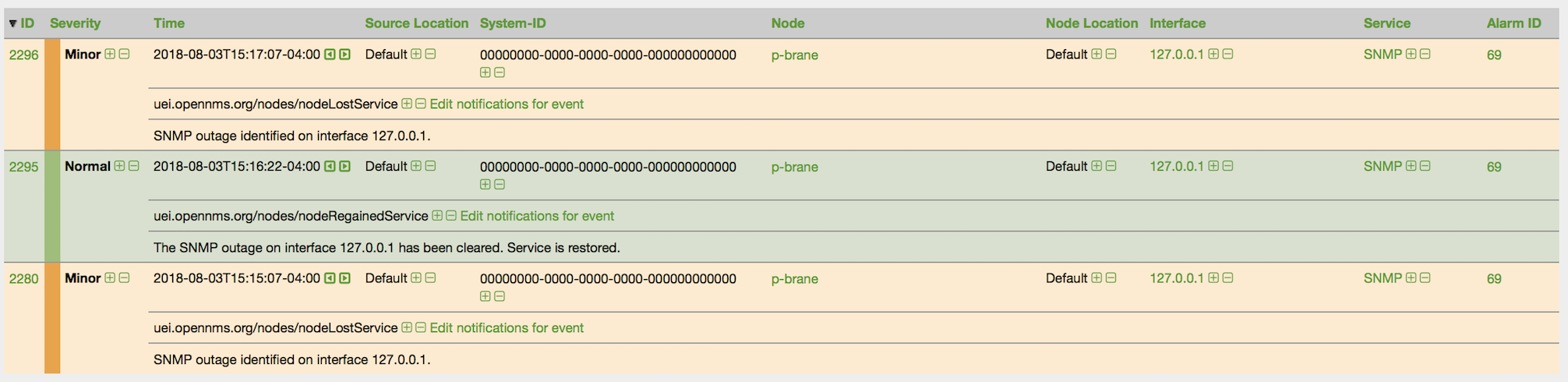

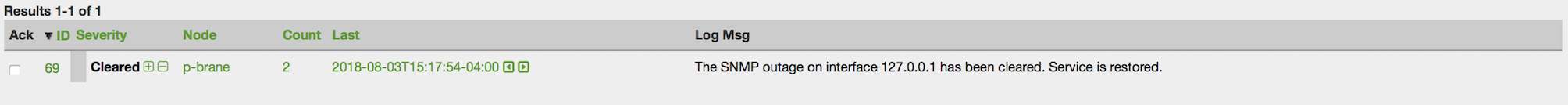

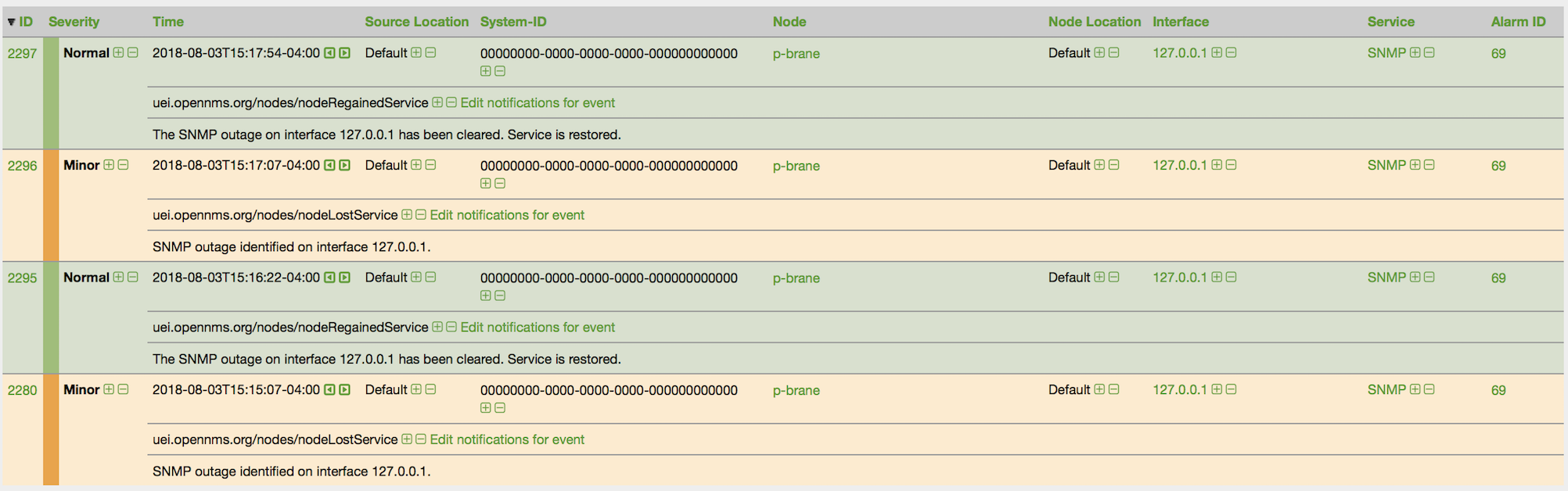

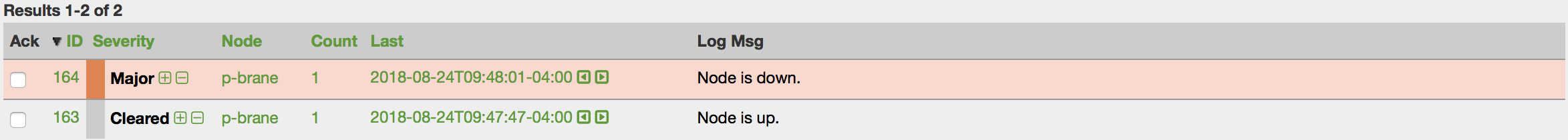

当 服务监测器 检测到一个故障时, Pollerd 将发送一个 事件 ,用来创建一个 告警。 事件 也可以用来生成 通知 ,来联系网络管理员。 下面的图片显示了 OpenNMS 中 Pollerd 的交互。

在 OpenNMS Horizon 中 Pollerd 可以生成以下 事件:

| 事件名称 | 描述 |

|---|---|

|

关键服务 从正常到服务不可用。 |

|

服务恢复正常 |

|

IP接口上的 关键服务 不可用或全部服务不可用。 |

|

接口上的 关键服务 重新恢复正常 |

|

设备的全部IP接口的所有关键服务不可用。 整个主机在网络上是不可达的。 |

|

一些 关键服务 又恢复正常。 |

生成 interfaceDown 和 nodeDown 事件的行为,在 关键服务 章节中进行了描述。

| 这假设启用了设备故障处理。 |

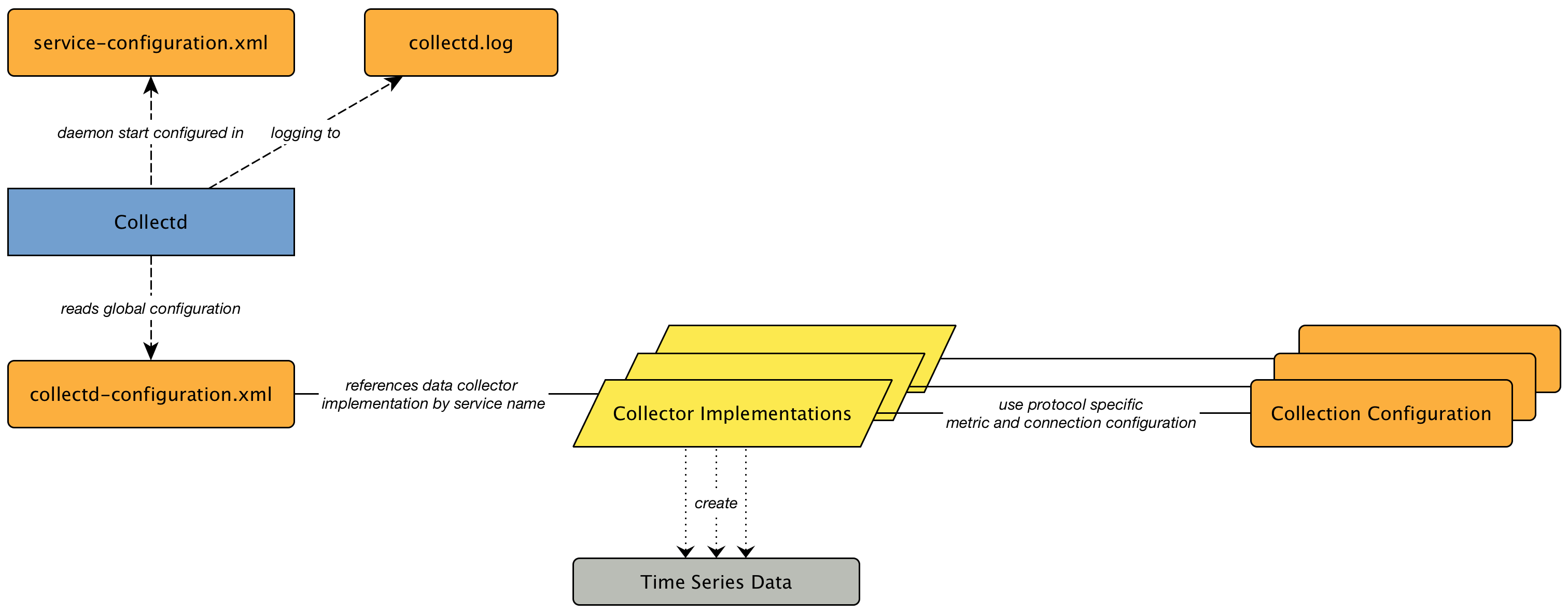

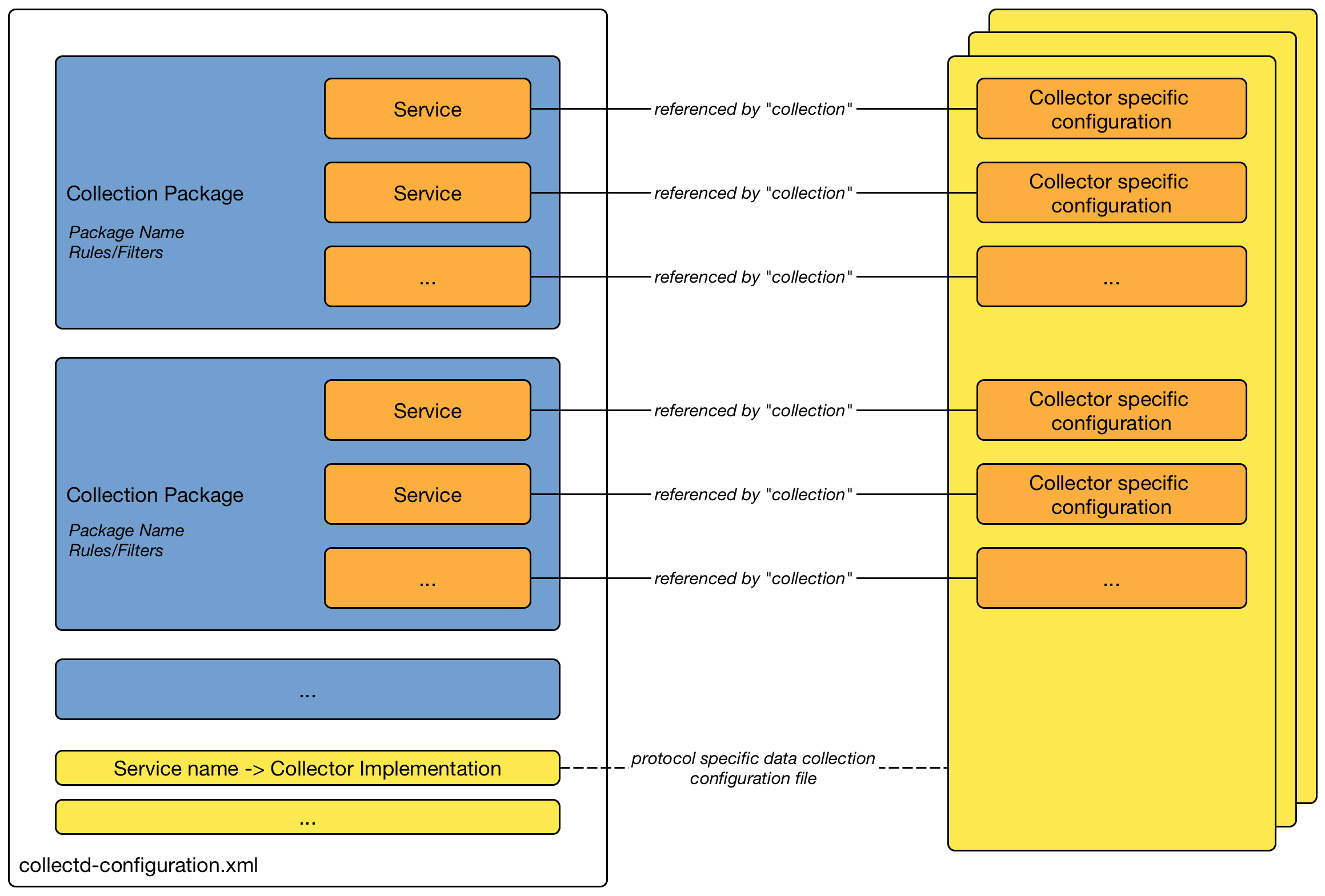

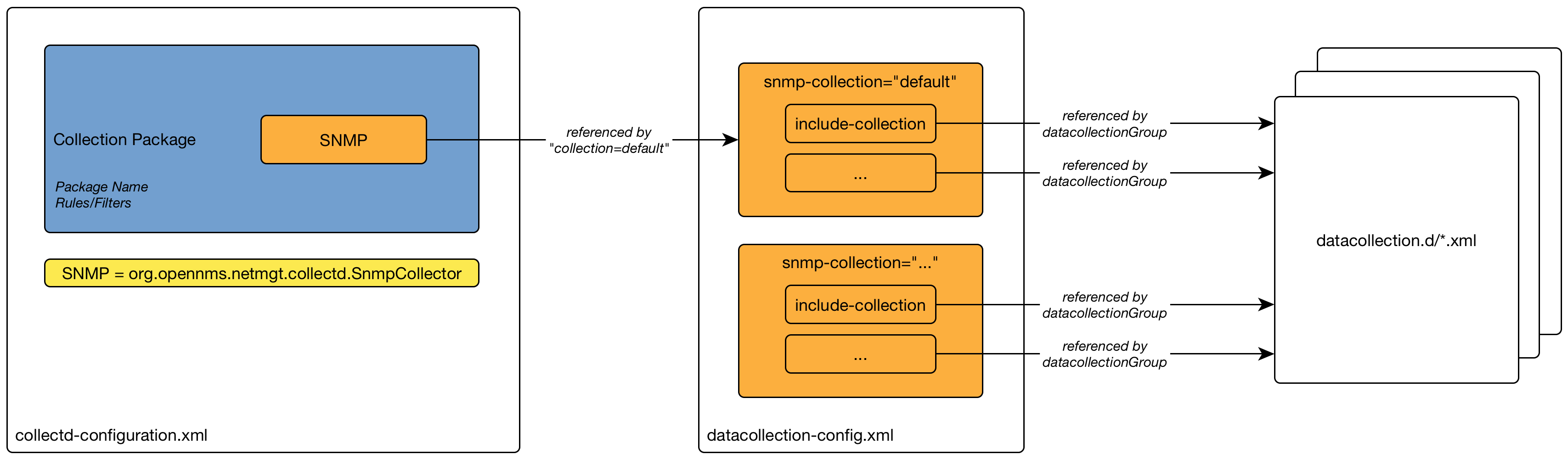

4.1. Pollerd 配置

| 文件 | 描述 |

|---|---|

|

监测器的配置文件和模块全局配置 |

|

Pollerd 自身和所有监测器的日志文件 |

|

服务响应时间的 RRD 图定义 |

|

Pollerd 的事件定义,例如 nodeLostService, interfaceDown 或 nodeDown |

可以在 poller-configuration.xml 配置文件修改服务监测器的特性。

配置文件的结构如下:

-

全局模块配置: 定义并行执行 服务监测器 的 线程池 大小。 定义和配置 设备事件相关 的 关键服务 。

-

轮询包: 允许对 服务监测器 的配置参数进行分组的包。

-

Downtime 模型: 在检测到一个 故障 的情况下,配置 Pollerd 执行测试。

-

监测器服务关联: 基于服务名称,分配应用程序和网络管理协议的实现。

<poller-configuration threads="30" (1)

pathOutageEnabled="false" (2)

serviceUnresponsiveEnabled="false"> (3)| 1 | 要并行运行的 服务监测器 的 线程池 大小 |

| 2 | 基于网络路径中的 关键设备 启用或禁用 路径故障 功能 |

| 3 | 如果服务没有响应,则生成 serviceUnresponsive 事件,而不是故障。 它防止 Downtime Model 在30秒后重新测试服务,并且防止假告警。 |

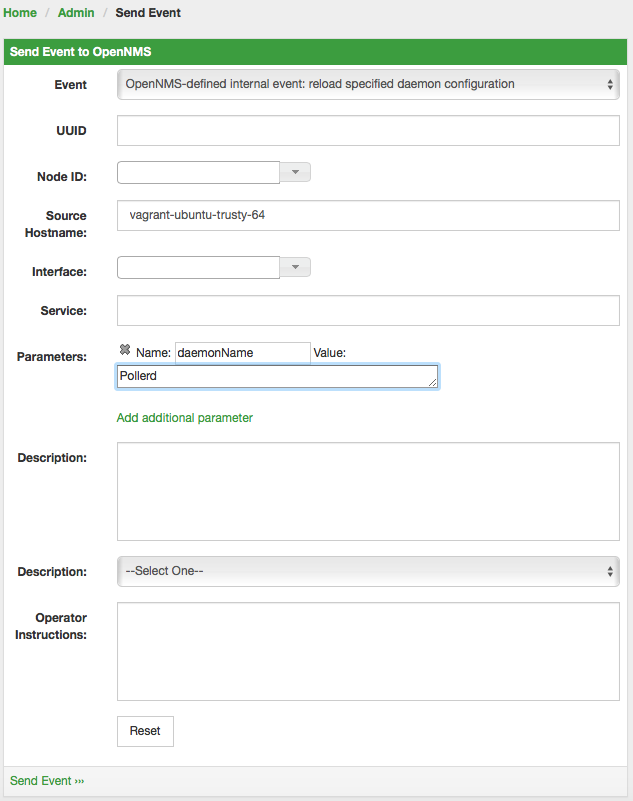

通过重新启动 OpenNMS Horizon 和 Pollerd 来应用配置更改。 还可以通过发送 事件 来让 Pollerd 重新加载配置。 可以通过 CLI 或 Web 用户界面 发送 事件 。

cd $OPENNMS_HOME/bin

./send-event.pl uei.opennms.org/internal/reloadDaemonConfig --parm 'daemonName Pollerd'

如果你在 poller-configuration.xml 中 新 定义了服务,则必须重新启动 OpenNMS Horizon 。

|

4.2. 关键服务

在 IP 网络 上监控服务可能会浪费大量资源,尤其是在其中许多服务不可用的情况下。 当服务处于脱机状态或无法到达时,监控系统花费大部分时间在等待重试和超时。

为了提高效率,如果关键服务为 Down ,则 OpenNMS 认为接口上的所有服务都是 Down。 默认情况下, OpenNMS 使用 ICMP 作为关键服务。

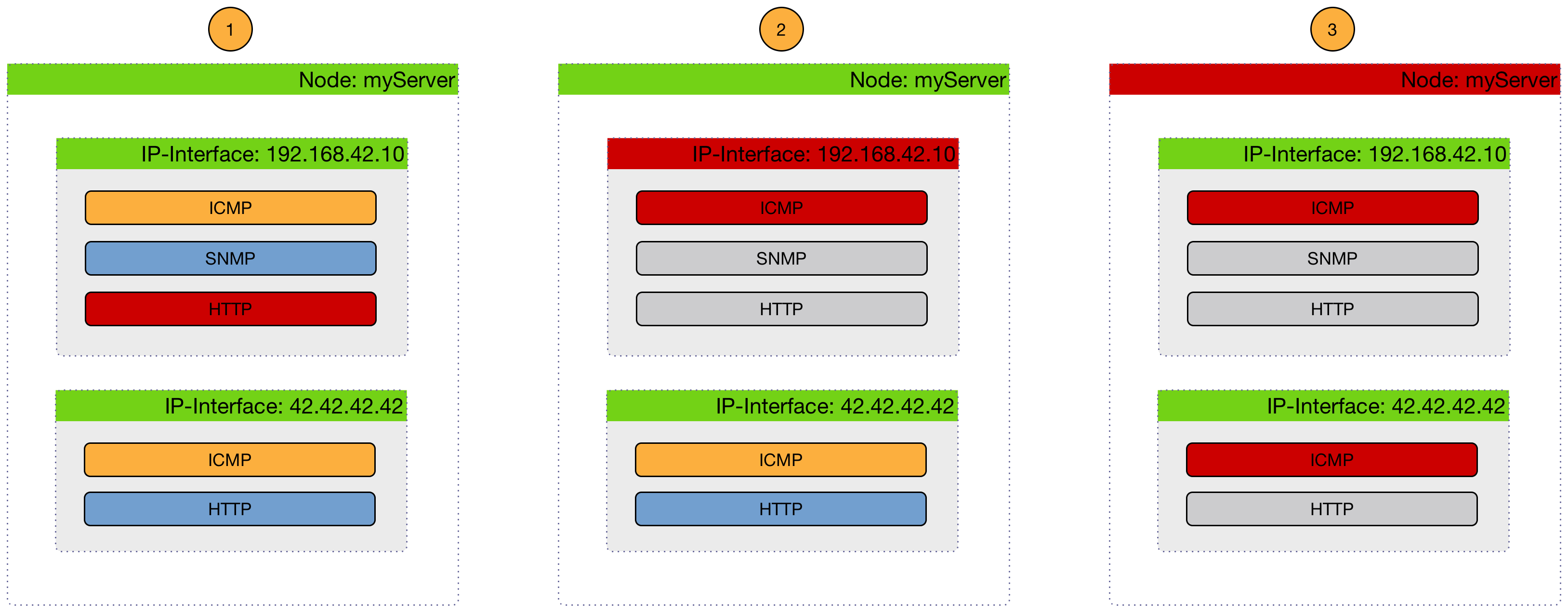

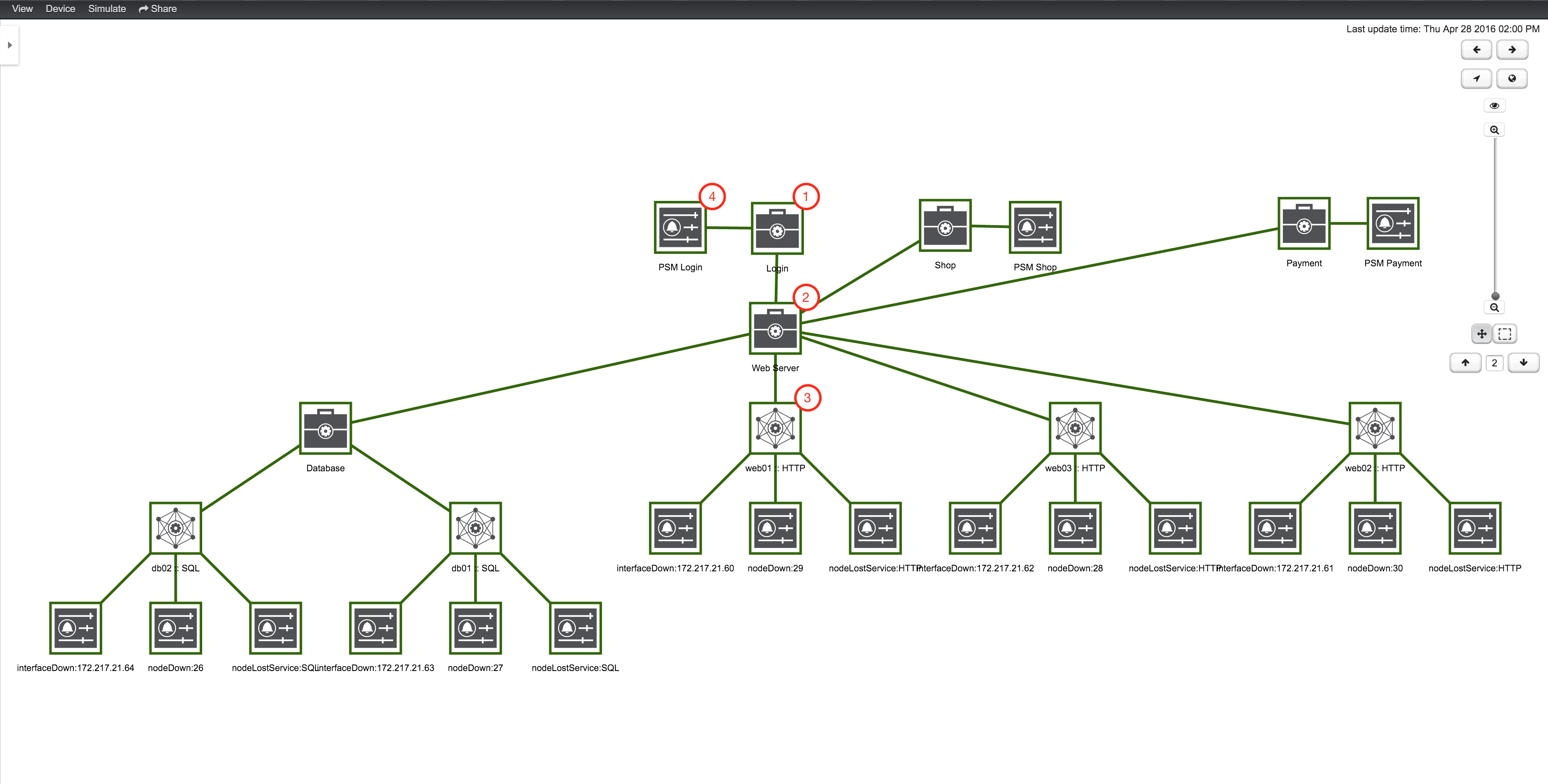

下面的图片显示了如何使用一个 关键服务 来生成这些事件。

-

(1) 设备 上的关键服务都是 Up 的,直到发出了 nodeLostService 事件。

-

(2) 许多 IP 接口 中的一个关键服务 Down ,就会发送 interfaceDown 事件。 所有其它服务都会被探测,并且不会发送任何事件,服务就被认为是不可达的。

-

(3) 设备 上的所有关键服务 Down ,才会发送 nodeDown 事件。 对其它 IP 接口 的所有其它服务都不进行探测,不发送任何事件,这些服务被假定为不可达。

关键服务 用于将 服务 故障与 nodeDown 或 interfaceDown 事件关联起来。

它是 Pollerd 的全局配置,定义在 poller-configuration.xml 文件中。

OpenNMS Horizon 默认情况下,开启此功能。

<poller-configuration threads="30"

pathOutageEnabled="false"

serviceUnresponsiveEnabled="false">

<node-outage status="on" (1)

pollAllIfNoCriticalServiceDefined="true"> (2)

<critical-service name="ICMP" /> (3)

</node-outage>| 1 | 开启 设备故障 关系到 关键服务 的功能 |

| 2 | 可选: 在没有 关键服务 功能的情况下,设备的监测行为。

如果设置为 true,则所有服务将被轮询。

如果设置为 false,则设备存在于轮询包的第一项服务将被轮询,并且直到服务恢复,然后所有服务恢复后,设备恢复。 |

| 3 | 定义 设备故障 相关的 关键服务 |

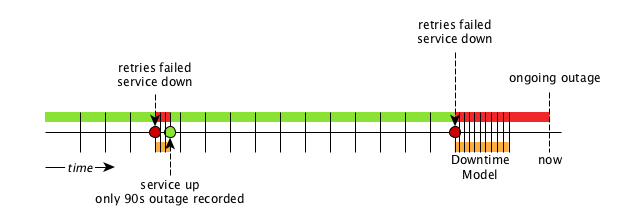

4.3. Downtime Model

默认情况下,服务的轮询时间为5分钟。 例如,为了检测由自动网络重路由引起的短服务故障,可以使用宕机时间模型。 在检测到服务故障时,轮询间隔减少到30秒,并持续5分钟。 如果服务在5分钟内恢复,则记录短故障,那么对服务可用性的影响将小于5分钟。 这种行为被称为 宕机时间模型 ,并且是可以配置的。

在图 故障和宕机时间模型 中有两个故障。 第一次故障显示为短故障,在90秒后检测为 up。 第二次故障现在没有解决,监测器没有检测到可用的服务,并且在前5分钟内不可用 (10此30秒的轮询)。 调度器将轮询器间隔更改为5分钟。

<downtime interval="30000" begin="0" end="300000" /><!-- 30s, 0, 5m -->(1)

<downtime interval="300000" begin="300000" end="43200000" /><!-- 5m, 5m, 12h -->(2)

<downtime interval="600000" begin="43200000" end="432000000" /><!-- 10m, 12h, 5d -->(3)

<downtime interval="3600000" begin="432000000" /><!-- 1h, 5d -->(4)| 1 | 故障发生后0到5分钟,轮询间隔将设置为30秒 |

| 2 | 在持续故障5分钟后,直到12小时,轮询间隔将被设置为5分钟 |

| 3 | 在持续故障12小时后,直到5天,轮询间隔将被设置为10分钟 |

| 4 | 在持续故障5天之后,服务将从监控系统中删除 |

4.4. Path Outages(路径故障)

一个中心的核心组件的故障可能导致许多节点的故障。

Path Outages(路径故障) 可用来抑制对于网络中定义 Critical Path (关键路径) 依赖的 设备 的 通知。

关键路径 必须从监控系统的网络角度配置。

默认情况下, Path Outage (路径故障) 特性被禁用,可以在配置文件 pollerd-configuration.xml 中启用。

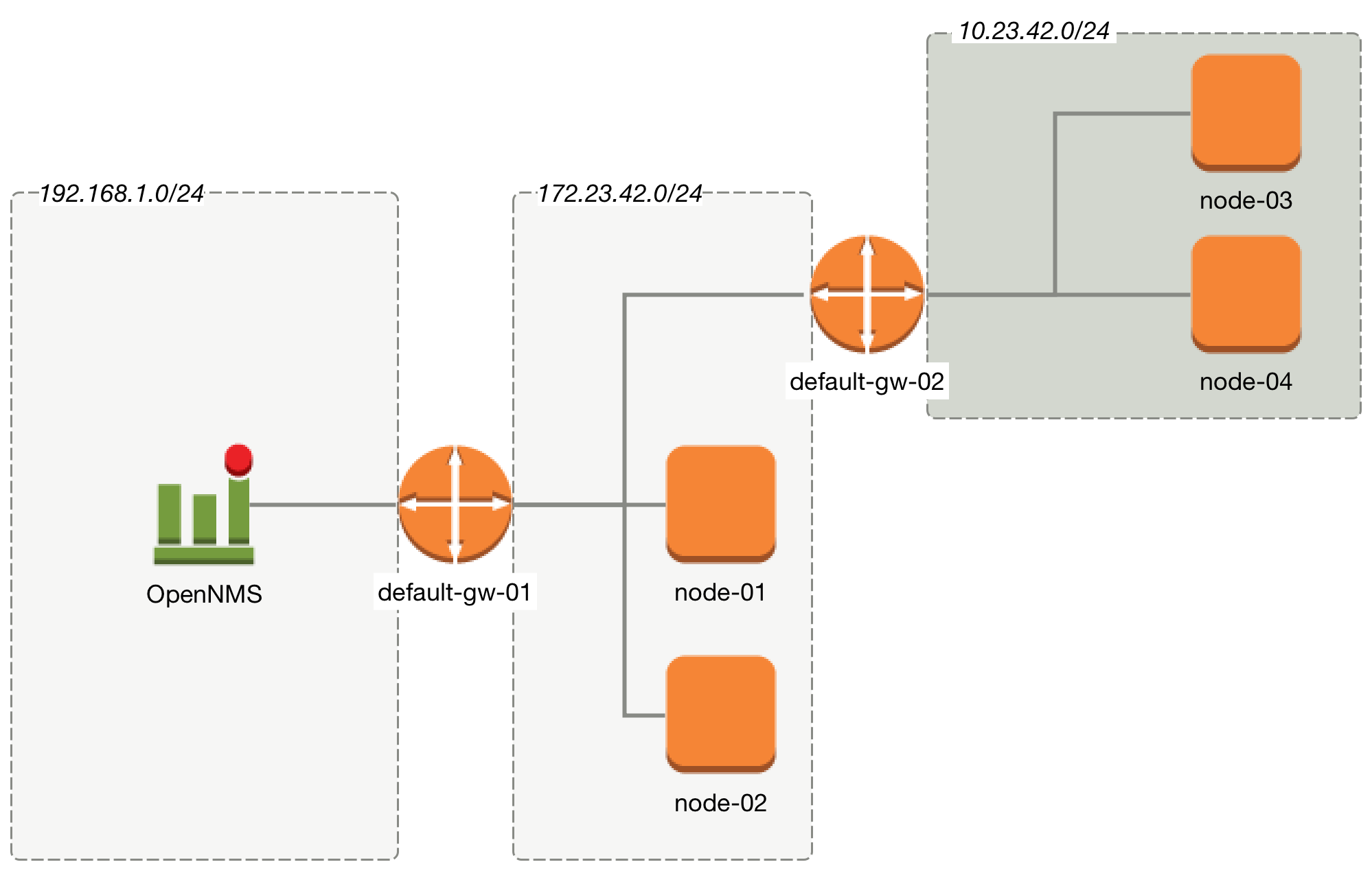

下图显示了一个网络拓扑结构示例。

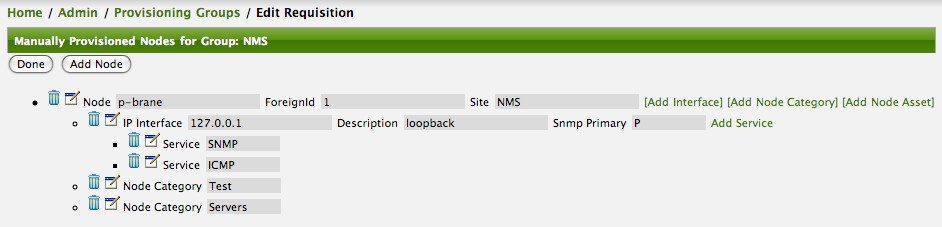

从监控系统的角度看来,名为 default-gw-01 的路由器处于两个网络的 关键路径 上。 如果路由器 default-gw-01 down,则两个网络后面的任何节点都不可达,并且它们也将都不可达。 在这种情况下,管理员希望只收到 default-gw-01 的一个通知,而不是后面其它 设备 的。 在 OpenNMS Horizon 中构建此配置需要以下信息:

-

Parent Foreign Source: 父节点的 Foreign Source 。

-

Parent Foreign ID: 这个节点所依赖的父 节点 的 Foreign ID 。

-

选择 Primary 的 IP 接口 作为 Critical IP

这个例子中所有 节点 定义都在同一个 Provisioning Requisition 中,名称是 Network-ACME ,并且 Foreign ID 和 Node Label (设备名称) 相同。

在 Web UI 进入 Admin → Configure OpenNMS → Manage Provisioning Requisitions → Edit the Requisition → Edit the Node → Path Outage 配置网络路径,设置 Parent Foreign Source, Parent Foreign ID 和 Provisioned Node。

| Parent Foreign Source | Parent Foreign ID | Provisioned Node |

|---|---|---|

not defined |

not defined |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

| 选择 Primary 的 IP Interface (IP接口) 为 Critical IP (关键IP). 在这个例子中最重要的是在网络 192.168.1.0/24 中的 default-gw-01 上的 IP 接口 设置为 Primary 接口。 在网络 172.23.42.0/24 中的 default-gw-02 上的IP接口设置为 Primary 接口。 |

4.5. Polling Packages(轮询包)

为了定义更复杂的监控配置,可以将 服务 配置分组到 Polling Packages (轮询包) 里。 它们允许分配 设备 到不同的 服务配置 里。 为了将 轮询包 分配给设备,可以使用 Rules/Filters 语法。 每个 轮询包 可以包含自己的 Downtime 模型 配置。

可以配置多个包,并且一个接口可以存在于多个包中。 这为确定服务级别提供了很大灵活性。

<package name="example1">(1)

<filter>IPADDR != '0.0.0.0'</filter>(2)

<include-range begin="1.1.1.1" end="254.254.254.254" />(3)

<include-range begin="::1" end="ffff:ffff:ffff:ffff:ffff:ffff:ffff:ffff" />(3)| 1 | 轮询包名称必须唯一。 |

| 2 | 过滤器可以基于 IP 地址,设备类别,或 设备 的资产属性,参考 Rules/Filters。 过滤器会首先使用,并且是 必须的。 这个包用于所有 IP 接口 ,除了 0.0.0.0 的 IP 地址,并且是 必须的。 |

| 3 | 允许指定 服务 的配置是否应用于一个 IP 接口 (IPv4 或 IPv6) 范围。 |

可以添加一个或多个特定的 IP-接口 来代替 include-range:

<specific>192.168.1.59</specific>也可以将 IP 接口 排除在外:

<exclude-range begin="192.168.0.100" end="192.168.0.104"/>4.5.1. 响应时间配置

使用 轮询包 可以定义具有不同轮询间隔的相似范围。 所有响应时间值都保存在 RRD 文件 中,并且需要定义。 每个 轮询包 包含一个 RRD 定义

<package name="example1">

<filter>IPADDR != '0.0.0.0'</filter>

<include-range begin="1.1.1.1" end="254.254.254.254" />

<include-range begin="::1" end="ffff:ffff:ffff:ffff:ffff:ffff:ffff:ffff" />

<rrd step="300">(1)

<rra>RRA:AVERAGE:0.5:1:2016</rra>(2)

<rra>RRA:AVERAGE:0.5:12:1488</rra>(3)

<rra>RRA:AVERAGE:0.5:288:366</rra>(4)

<rra>RRA:MAX:0.5:288:366</rra>(5)

<rra>RRA:MIN:0.5:288:366</rra>(6)

</rrd>| 1 | 在这个 轮询包 中,所有服务的轮询间隔反映在300秒的步长中。 此包中的所有服务必须在5分钟内轮询完成,否则响应时间值不能正确存储。 |

| 2 | 1 步长存储 2016 此: 1 * 5 min * 2016 = 7 天, 5 分钟精度存储 7 天。 |

| 3 | 12 步长平均存储 1488 此: 12 * 5 min * 1488 = 62 天, 汇聚到 60 分钟,存储 62 天。 |

| 4 | 288 步长平均存储 366 次: 288 * 5 min * 366 = 366 天, 汇聚至 24 小时,存储 366 天。 |

| 5 | 288 步长最大值 24 小时,存储 366 天。 |

| 6 | 288 步长最小值 24 小时,存储 366 天。 |

| RRD 配置和服务轮询间隔必须均衡。 否则,存储的响应时间数据不能在图表中正确显示。 |

| 如果轮询间隔改变后,则需要用新定义的配置重新创建 RRD 文件。 |

4.5.2. 覆盖服务

通过指定多个 轮询包 ,可以多次使用与 ICMP 相同的 服务 。

当 IP 接口 匹配具有相同 服务 配置的多个 轮询包 时,如何定义 poller-configuration.xml 中 轮询包 的顺序非常重要。

下面的示例显示针对特定服务应用配置:

<package name="less-specific">

<filter>IPADDR != '0.0.0.0'</filter>

<include-range begin="1.1.1.1" end="254.254.254.254" />

<include-range begin="::1" end="ffff:ffff:ffff:ffff:ffff:ffff:ffff:ffff" />

<rrd step="300">(1)

<rra>RRA:AVERAGE:0.5:1:2016</rra>

<rra>RRA:AVERAGE:0.5:12:1488</rra>

<rra>RRA:AVERAGE:0.5:288:366</rra>

<rra>RRA:MAX:0.5:288:366</rra>

<rra>RRA:MIN:0.5:288:366</rra>

</rrd>

<service name="ICMP" interval="300000" user-defined="false" status="on">(2)

<parameter key="retry" value="5" />(3)

<parameter key="timeout" value="10000" />(4)

<parameter key="rrd-repository" value="/var/lib/opennms/rrd/response" />

<parameter key="rrd-base-name" value="icmp" />

<parameter key="ds-name" value="icmp" />

</service>

<downtime interval="30000" begin="0" end="300000" />

<downtime interval="300000" begin="300000" end="43200000" />

<downtime interval="600000" begin="43200000" end="432000000" />

</package>

<package name="more-specific">

<filter>IPADDR != '0.0.0.0'</filter>

<include-range begin="192.168.1.1" end="192.168.1.254" />

<include-range begin="2600::1" end="2600:::ffff" />

<rrd step="30">(1)

<rra>RRA:AVERAGE:0.5:1:20160</rra>

<rra>RRA:AVERAGE:0.5:12:14880</rra>

<rra>RRA:AVERAGE:0.5:288:3660</rra>

<rra>RRA:MAX:0.5:288:3660</rra>

<rra>RRA:MIN:0.5:288:3660</rra>

</rrd>

<service name="ICMP" interval="30000" user-defined="false" status="on">(2)

<parameter key="retry" value="2" />(3)

<parameter key="timeout" value="3000" />(4)

<parameter key="rrd-repository" value="/var/lib/opennms/rrd/response" />

<parameter key="rrd-base-name" value="icmp" />

<parameter key="ds-name" value="icmp" />

</service>

<downtime interval="10000" begin="0" end="300000" />

<downtime interval="300000" begin="300000" end="43200000" />

<downtime interval="600000" begin="43200000" end="432000000" />

</package>| 1 | 包中的轮询间隔为 300 秒和 30 秒 |

| 2 | 服务 ICMP 的不同轮询间隔 |

| 3 | 服务 ICMP 的不同重试设置 |

| 4 | 服务 ICMP 的不同超时设置 |

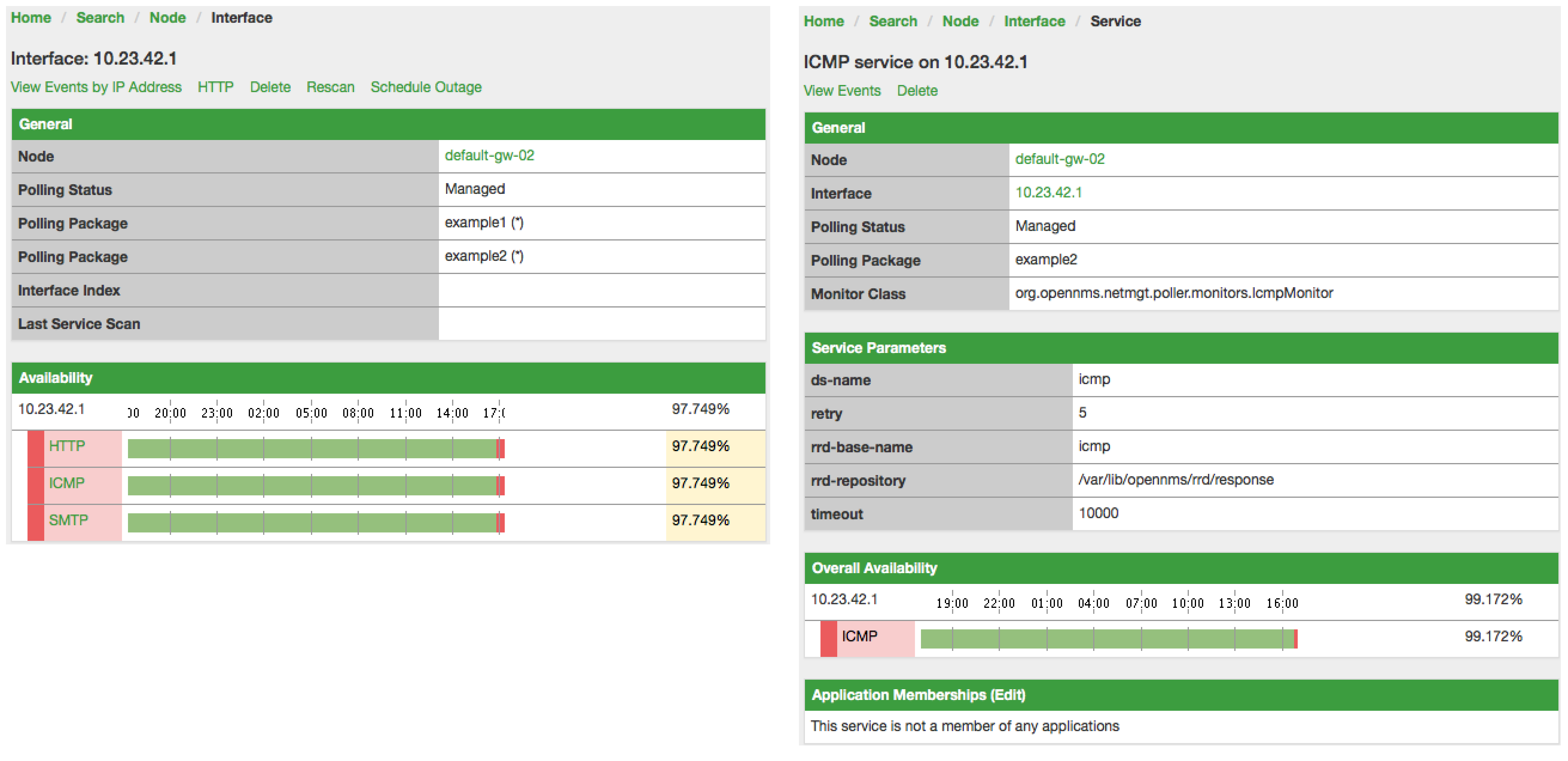

服务的最后一个 轮询包 将被应用。 这可以用于为默认配置定义较少匹配的过滤器。 可以使用更具体的 轮询包 覆盖默认设置。 在上面的示例中,在 192.168.1/24 或 2600:/64 中所有的 IP 接口 将被具有不同轮询,重试和超时设置的 ICMP 轮询监控。

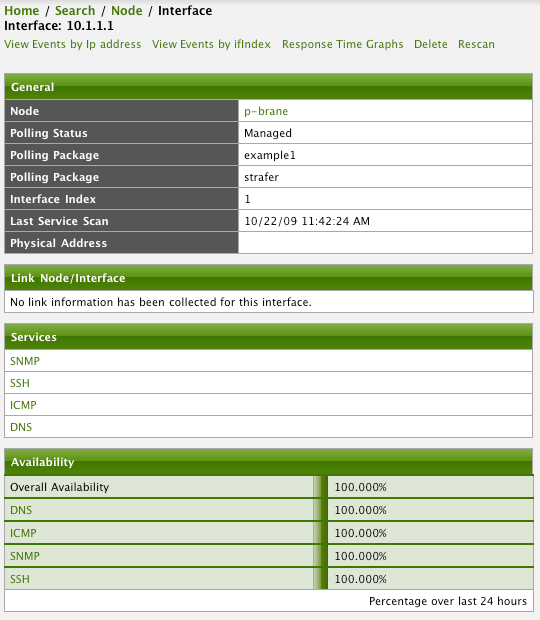

将哪个 轮询包 应用到 IP 接口 和 服务 可以在 Web 用户界面 找到。 IP 接口 和 服务 页面显示了哪个 轮询包 和 服务 配置应用于这个特定的服务。

4.5.3. 手动测试服务

为了排除故障,可以在 Karaf Shell 上执行测试。

ssh -p 8101 admin@localhost登录到 shell,你可以显示命令帮助如下:

opennms> poller:test --help

DESCRIPTION

poller:test

Execute a poller test from the command line using current settings from poller-configuration.xml

SYNTAX

poller:test [options]

OPTIONS

-s, --service

Service name

-p, --param

Service parameter ~ key=value

-i, --ipaddress

IP Address to test

-P, --package

Poller Package

-c, --class

Monitor Class

--help

Display this help message下面的示例在特定的 IP 接口 上运行 ICMP 监测器。

opennms> poller:test -i 10.23.42.1 -s ICMP -P example1允许调试模式的 监测器 配置。 重要的输出行,如下所示:

Checking service ICMP on IP 10.23.42.1 (1)

Package: example1 (2)

Monitor: org.opennms.netmgt.poller.monitors.IcmpMonitor (3)

Parameter ds-name : icmp (4)

Parameter rrd-base-name : icmp (4)

Parameter rrd-repository : /var/lib/opennms/rrd/response (4)

Parameter retry : 2 (5)

Parameter timeout : 3000 (5)

Available ? true (status Up[1])| 1 | 执行测试的 服务 和 IP 接口 |

| 2 | 此测试的 轮询包 应用的 服务 配置 |

| 3 | 此测试使用的 服务监测器 |

| 4 | 响应时间的 RRD 配置 |

| 5 | 此测试的重试和超时设置 |

4.5.4. 在 Karaf Shell 上测试过滤器

过滤器在具有 <filter> 语法的 opennms 配置中无处不在。 此 karaf shell 可用于验证过滤器。有关详细信息,请参阅 过滤器。

ssh -p 8101 admin@localhost进入 shell 后,打印命令帮助如下

opennms> filters:filter --help

DESCRIPTION

filters:filter

Enumerates nodes/interfaces that match a give filter

SYNTAX

filters:filter filterRule

ARGUMENTS

filterRule

A filter Rule例如:运行与 location(站点/位置)匹配的过滤规则

filters:filter "location='MINION'"输出显示如下

nodeId=2 nodeLabel=00000000-0000-0000-0000-000000ddba11 location=MINION

IpAddresses:

127.0.0.1另一个例子:运行与设备位置和给定IP地址范围匹配的过滤器。 有关使用 IPLIKE 语法的详细信息,请参阅 IPLIKE。

filters:filter "location='Default' & (IPADDR IPLIKE 172.*.*.*)"输出显示如下

nodeId=3 nodeLabel=label1 location=Default

IpAddresses:

172.10.154.1

172.20.12.12

172.20.2.14

172.01.134.1

172.20.11.15

172.40.12.18

nodeId=5 nodeLabel=label2 location=Default

IpAddresses:

172.17.0.111

nodeId=6 nodeLabel=label3 location=Default

IpAddresses:

172.20.12.22

172.17.0.123| 显示的设备信息将包含 nodeId, nodeLabel, location ,和可选的字段像 foreignId, foreignSource, categories ,如果存在。 |

4.6. 服务监测器

为了支持多种应用程序和管理代理, Pollerd 执行 服务监测器。 本节描述所有可用的内置 服务监测器 ,并且可以通过配置完成复杂的监控。 关于如何扩展这些信息,请参考 OpenNMS 的 开发指南 。

4.6.1. 常见配置参数

应用程序或设备的对应 监测器 通常基于相应的常用 API,并且指定相应的配置参数。 这些最小配置参数可以在所有 监测器 中使用,并附加超时、重试等参数。

| 参数 | 描述 | 必须 | 默认值 |

|---|---|---|---|

|

测试 服务 重试次数。 |

可选 |

|

|

执行 isReachable 方法的超时时间,单位毫秒。 |

可选 |

|

|

是否反转监测器 up/down 状态 |

可选 |

|

如果 监测器 正在使用 SNMP 协议 ,那么 timeout 和 retry 默认使用的是 SNMP 配置 (snmp-config.xml)。

|

Minion 配置参数

当使用非默认站点设备时,相关 服务监测器 将与 Minion 使用相同站点的配置。 如果在给定的站点有多个 Minions ,可以在当前任意一个 Minions 上执行 服务监测器 。 用户可以选择在特定的 Minion 上执行 服务监测器 ,通过指定 Minion 的 System ID 。 这种机制用来让 Minions 单独监控。

可以使用以下参数来覆盖 服务监测器 执行的站点 位置。

| 参数 | 描述 | 必须 | 默认值 |

|---|---|---|---|

|

指定应该执行 服务监测器 的站点。 |

可选 |

(设备关联的位置) |

|

指定应该执行 服务监测器 的 System ID 。 |

可选 |

(None) |

|

使用关联设备的外部源id,作为 System ID |

可选 |

|

| 当指定一个 System ID 时,该位置应该与系统设置的位置一致。 |

4.6.2. 在参数中使用占位符

一些监测器参数支持占位符替换。

可以将某些设备、接口和资产记录属性封装在 { 和 } 中来引用它们。

支持的属性是:

-

nodeId -

nodeLabel -

foreignSource -

foreignId -

ipAddr(或ipAddress) -

所有设备资产记录字段 (例如

username,password)

支持占位符替换的参数在监测器文档的 配置与使用 部分的 '占位符替换' 列中标记 'Yes'。

4.6.3. AvailabilityMonitor

该监测器通过使用 InetAddress java 类的 isReachable 方法来测试设备的可达性。 如果 isReachable 返回 true,则认为服务可用。 参考 Oracle’s documentation 更多的细节。

| 该监测器与 IcmpMonitor 监测器是不同的。你应该只在远程轮询器运行该监测器,并且使用不同的配置 (有关详细信息,请参考 below )。 |

监测器定义

类名 |

|

是否支持远程轮询 |

true |

配置与使用

该监测器实现 公共配置参数。

实例

<service name="AVAIL" interval="300000" user-defined="false" status="on">

<parameter key="retry" value="2"/>

<parameter key="timeout" value="5000"/>

</service>

<monitor service="AVAIL" class-name="org.opennms.netmgt.poller.monitors.AvailabilityMonitor"/>IcmpMonitor 与 AvailabilityMonitor

这个监测器用来当 IcmpMonitor 监测器不能在远程轮询上启用的,以弥补这个限制。 现在,使用 JNA ICMP 实现,在大多数配置下远程轮询都启用了 IcmpMonitor 监测器,并且应该不需要改监测器,除非你使用不同的配置运行远程轮询器 (参考 issue NMS-6735 查看更多信息)。

4.6.4. BgpSessionMonitor

此监测器检查 BGP-Session 两端 (相对等-ip)是否具备相关功能。 为了监控 BGP-Session(会话),使用 RFC1269 SNMP MIB,并使用以下 OIDs 测试会话的状态:

BGP_PEER_STATE_OID = .1.3.6.1.2.1.15.3.1.2.<peer-ip> BGP_PEER_ADMIN_STATE_OID = .1.3.6.1.2.1.15.3.1.3.<peer-ip> BGP_PEER_REMOTEAS_OID = .1.3.6.1.2.1.15.3.1.9.<peer-ip> BGP_PEER_LAST_ERROR_OID = .1.3.6.1.2.1.15.3.1.14.<peer-ip> BGP_PEER_FSM_EST_TIME_OID = .1.3.6.1.2.1.15.3.1.16.<peer-ip>

<peer-ip>(对等ip)是 BGP 会话结束点的远端IP地址。

一个 SNMP get 请求获取 BGP_PEER_STATE_OID 的结果,返回结果在 1 到 6 之间。

OpenNMS Horizon 的服务状态映射如下:

| 结果 | 状态描述 | 在 OpenNMS Horizon 的监控状态 |

|---|---|---|

|

Idle |

DOWN |

|

Connect |

DOWN |

|

Active |

DOWN |

|

OpenSent |

DOWN |

|

OpenConfirm |

DOWN |

|

Established |

UP |

监测器定义

类名 |

|

是否支持远程轮询 |

false |

为了定义映射关系,我们使用了来自 RFC1771 BGP Finite State Machine 的描述。

实例

为了监控会话状态是否建立,需要在轮询配置文件 '$OPENNMS_HOME/etc/poller-configuration.xml' 中添加 service(服务),例如:

<!-- Example configuration poller-configuration.xml -->

<service name="BGP-Peer-99.99.99.99-AS65423" interval="300000"

user-defined="false" status="on">

<parameter key="retry" value="2" />

<parameter key="timeout" value="3000" />

<parameter key="port" value="161" />

<parameter key="bgpPeerIp" value="99.99.99.99" />

</service>

<monitor service="BGP-Peer-99.99.99.99-AS65423" class-name="org.opennms.netmgt.poller.monitors.BgpSessionMonitor" />错误代码映射

BGP_PEER_LAST_ERROR_OID 给出的是十六进制代码的错误表示。 为了增加可读性,给出了一个代码映射表:

| 错误代码 | 错误消息 |

|---|---|

|

Message Header Error |

|

Message Header Error - Connection Not Synchronized |

|

Message Header Error - Bad Message Length |

|

Message Header Error - Bad Message Type |

|

OPEN Message Error |

|

OPEN Message Error - Unsupported Version Number |

|

OPEN Message Error - Bad Peer AS |

|

OPEN Message Error - Bad BGP Identifier |

|

OPEN Message Error - Unsupported Optional Parameter |

|

OPEN Message Error (deprecated) |

|

OPEN Message Error - Unacceptable Hold Time |

|

UPDATE Message Error |

|

UPDATE Message Error - Malformed Attribute List |

|

UPDATE Message Error - Unrecognized Well-known Attribute |

|

UPDATE Message Error - Missing Well-known Attribute |

|

UPDATE Message Error - Attribute Flags Error |

|

UPDATE Message Error - Attribute Length Error |

|

UPDATE Message Error - Invalid ORIGIN Attribute |

|

UPDATE Message Error (deprecated) |

|

UPDATE Message Error - Invalid NEXT_HOP Attribute |

|

UPDATE Message Error - Optional Attribute Error |

|

UPDATE Message Error - Invalid Network Field |

|

UPDATE Message Error - Malformed AS_PATH |

|

Hold Timer Expired |

|

Finite State Machine Error |

|

Cease |

|

Cease - Maximum Number of Prefixes Reached |

|

Cease - Administrative Shutdown |

|

Cease - Peer De-configured |

|

Cease - Administrative Reset |

|

Cease - Connection Rejected |

|

Cease - Other Configuration Change |

|

Cease - Connection Collision Resolution |

|

Cease - Out of Resources |

代替十六进制代码,错误消息将显示在服务 down 的日志消息中。 为了提高一些附加信息,日志消息也包含

BGP-Peer Adminstate BGP-Peer Remote AS BGP-Peer established time in seconds

调试

如果要检查或监控 BGP 会话有问题,可以使用以下命令找出问题原因。

snmpwalk -v 2c -c <myCommunity> <myRouter2Monitor> .1.3.6.1.2.1.15.3.1.2.99.99.99.99用你的 BGP-Peer IP 替换 99.99.99.99。

结果应该是 1 到 6 之间的整数。

4.6.5. BSFMonitor

此监测器运行 Bean Scripting Framework BSF 兼容的脚本来确定服务的状态。 用户可以编写脚本来执行高度定制的服务检查。 这个监测器没有进行优化。 它用于少量的自定义检查或原型的监控。

BSFMonitor 与 SystemExecuteMonitor

BSFMonitor 避免了由 SystemExecuteMonitor 使用的 fork(2) 的开销。 BSFMonitor 还授予对脚本中使用 OpenNMS Horizon 内部方法和类的访问权。

监测器定义

类名 |

|

是否支持远程轮询 |

false |

配置与使用

| 参数 | 描述 | 必须 | 默认值 |

|---|---|---|---|

|

脚本文件的路径。 |

必须 |

|

|

BSF 引擎运行不同脚本语言 |

必须 |

|

|

|

可选 |

|

|

BSF 语言类,像 |

可选 |

默认情况下解析文件扩展名 |

|

逗号分隔列表 |

可选 |

|

该监测器实现 公共配置参数。

| 变量 | 类型 | 描述 |

|---|---|---|

|

Map<String, Object> |

map 包含从 |

|

String |

当前轮询的 IP 地址。 |

|

int |

|

|

String |

|

|

String |

要轮询的服务名称。 |

|

BSFMonitor |

BSFMonitor 对象调用的脚本实例。 通过它的 log(String sev, String fmt, Object... args) 方法进行日志记录。 |

|

HashMap<String, String> |

将脚本结果 put 到这个对象。

状态标识应该组合成键值对加入,key 使用 |

|

LinkedHashMap<String, Number> |

脚本希望 put 一个或多个响应时间到这个对象。 |

此外,添加到 poller-configuration.xml 中的 service(服务)定义的每个参数都可以作为脚本中的 String 对象。

参数的 key 属性表示 String 对象的名称,value 属性表示 String 对象的值。

| 请注意,这些参数也可以通过 map bean 访问。 |

| 避免参数使用 non-character 的名称,以免在脚本语言中出现问题。 |

响应代码

脚本必须提供表示关联服务状态的状态代码。 定义了下列状态代码:

| 代码 | 描述 |

|---|---|

OK |

服务可用 |

UNK |

服务状态未知 |

UNR |

服务无响应 |

NOK |

服务不可用 |

响应时间跟踪

默认情况下,BSFMonitor 执行脚本文件消耗的全部时间作为响应时间。 如果要存储响应时间,则需要添加以下参数:

poller-configuration.xml 中定义 service(服务)的 RRD 响应时间<!-- where in the filesystem response times are stored -->

<parameter key="rrd-repository" value="/opt/opennms/share/rrd/response" />

<!-- name of the rrd file -->

<parameter key="rrd-base-name" value="minimalbshbase" />

<!-- name of the data source in the rrd file -->

<!-- by default "response-time" is used as ds-name -->

<parameter key="ds-name" value="myResponseTime" />还可以直接从脚本返回一个或多个响应时间。

若要添加自定义响应时间或重写默认值,请向 times 对象添加条目。

这些条目使用 String 类型 key 的数据源,并且 value 是数值的响应时间。

若要覆盖默认响应时间数据源,请将一个名为 response-time 的条目添加到 times 中。

超时与重试

BSFMonitor 本身不执行任何超时或重试处理。 如果需要重试和超时行为,则必须在脚本中实现。

脚本的要求(运行类型)

根据 run-type,脚本必须以不同的方式提供结果。

对于简单逻辑的小脚本 run-type 使用 eval。

在 eval 模式下运行的脚本必须返回一个匹配 status codes 的 String。

如果你的脚本不是简单的,则 run-type` 配置为 exec。

在 exec 模式下运行的脚本不需要返回任何内容,但是它们必须向 results 对象添加带有 status code 的 status 条目。

此外,results 对象还可以携带一个 "reason":"message" 条目,用于非 OK 状态。

常用语言设置

BSF 支持多种语言,下表提供了常用语言所需的设置。

| 语言 | 语言名 | bsf-引擎 | 所需库 |

|---|---|---|---|

beanshell |

|

supported by default |

|

groovy |

|

groovy-all-[version].jar |

|

jython |

|

jython-[version].jar |

Bean Shell 实例

poller-configuration.xml 中配置实例<service name="MinimalBeanShell" interval="300000" user-defined="true" status="on">

<parameter key="file-name" value="/tmp/MinimalBeanShell.bsh"/>

<parameter key="bsf-engine" value="bsh.util.BeanShellBSFEngine"/>

</service>

<monitor service="MinimalBeanShell" class-name="org.opennms.netmgt.poller.monitors.BSFMonitor" />MinimalBeanShell.bsh 脚本文件bsf_monitor.log("ERROR", "Starting MinimalBeanShell.bsf", null);

File testFile = new File("/tmp/TestFile");

if (testFile.exists()) {

return "OK";

} else {

results.put("reason", "file does not exist");

return "NOK";

}Groovy 实例

要使用 Groovy 语言,需要一个额外的库。

将兼容的 groovy-all.jar 拷贝到 opennms/lib 文件夹,并重新启动 OpenNMS Horizon。

poller-configuration.xml 中的实例,默认 run-type 设置为 eval<service name="MinimalGroovy" interval="300000" user-defined="true" status="on">

<parameter key="file-name" value="/tmp/MinimalGroovy.groovy"/>

<parameter key="bsf-engine" value="org.codehaus.groovy.bsf.GroovyEngine"/>

</service>

<monitor service="MinimalGroovy" class-name="org.opennms.netmgt.poller.monitors.BSFMonitor" />MinimalGroovy.groovy 脚本文件,run-type 配置为 evalbsf_monitor.log("ERROR", "Starting MinimalGroovy.groovy", null);

File testFile = new File("/tmp/TestFile");

if (testFile.exists()) {

return "OK";

} else {

results.put("reason", "file does not exist");

return "NOK";

}poller-configuration.xml 中的实例,run-type 设置为 exec<service name="MinimalGroovy" interval="300000" user-defined="true" status="on">

<parameter key="file-name" value="/tmp/MinimalGroovy.groovy"/>

<parameter key="bsf-engine" value="org.codehaus.groovy.bsf.GroovyEngine"/>

<parameter key="run-type" value="exec"/>

</service>

<monitor service="MinimalGroovy" class-name="org.opennms.netmgt.poller.monitors.BSFMonitor" />MinimalGroovy.groovy 脚本文件,run-type 设置为 execbsf_monitor.log("ERROR", "Starting MinimalGroovy", null);

def testFile = new File("/tmp/TestFile");

if (testFile.exists()) {

results.put("status", "OK")

} else {

results.put("reason", "file does not exist");

results.put("status", "NOK");

}Jython 实例

要使用 Jython (Python 的 Java 实现) 语言,需要一个额外的库。

将一个兼容的 jython-x.y.z.jar 拷贝到 opennms/lib 文件夹中,并重新启动 OpenNMS Horizon。

这样,BSFMonitor 就可以使用 Jython 了。

poller-configuration.xml 中的配置实例,run-type 配置为 exec<service name="MinimalJython" interval="300000" user-defined="true" status="on">

<parameter key="file-name" value="/tmp/MinimalJython.py"/>

<parameter key="bsf-engine" value="org.apache.bsf.engines.jython.JythonEngine"/>

<parameter key="run-type" value="exec"/>

</service>

<monitor service="MinimalJython" class-name="org.opennms.netmgt.poller.monitors.BSFMonitor" />MinimalJython.py 脚本文件,run-type 设置为 execfrom java.io import File

bsf_monitor.log("ERROR", "Starting MinimalJython.py", None);

if (File("/tmp/TestFile").exists()):

results.put("status", "OK")

else:

results.put("reason", "file does not exist")

results.put("status", "NOK")

这里必须将 run-type 设置为 exec,因为在 eval 模式下,Jython 将阻塞在 import 关键字。

|

| 为了证明这是真正的 Python,注意在日志调用中将 Python’s None 值替换为 Java’s null 。 |

高级实例

下面的示例引用向脚本公开的所有 beans,包括自定义参数。

poller-configuration.xml 中配置实例<service name="MinimalGroovy" interval="30000" user-defined="true" status="on">

<parameter key="file-name" value="/tmp/MinimalGroovy.groovy"/>

<parameter key="bsf-engine" value="org.codehaus.groovy.bsf.GroovyEngine"/>

<!-- custom parameters (passed to the script) -->

<parameter key="myParameter" value="Hello Groovy" />

<!-- optional for response time tracking -->

<parameter key="rrd-repository" value="/opt/opennms/share/rrd/response" />

<parameter key="rrd-base-name" value="minimalgroovybase" />

<parameter key="ds-name" value="minimalgroovyds" />

</service>

<monitor service="MinimalGroovy" class-name="org.opennms.netmgt.poller.monitors.BSFMonitor" />bsf_monitor.log("ERROR", "Starting MinimalGroovy", null);

//list of all available objects from the BSFMonitor

Map<String, Object> map = map;

bsf_monitor.log("ERROR", "---- map ----", null);

bsf_monitor.log("ERROR", map.toString(), null);

String ip_addr = ip_addr;

bsf_monitor.log("ERROR", "---- ip_addr ----", null);

bsf_monitor.log("ERROR", ip_addr, null);

int node_id = node_id;

bsf_monitor.log("ERROR", "---- node_id ----", null);

bsf_monitor.log("ERROR", node_id.toString(), null);

String node_label = node_label;

bsf_monitor.log("ERROR", "---- node_label ----", null);

bsf_monitor.log("ERROR", node_label, null);

String svc_name = svc_name;

bsf_monitor.log("ERROR", "---- svc_name ----", null);

bsf_monitor.log("ERROR", svc_name, null);

org.opennms.netmgt.poller.monitors.BSFMonitor bsf_monitor = bsf_monitor;

bsf_monitor.log("ERROR", "---- bsf_monitor ----", null);

bsf_monitor.log("ERROR", bsf_monitor.toString(), null);

HashMap<String, String> results = results;

bsf_monitor.log("ERROR", "---- results ----", null);

bsf_monitor.log("ERROR", results.toString(), null);

LinkedHashMap<String, Number> times = times;

bsf_monitor.log("ERROR", "---- times ----", null);

bsf_monitor.log("ERROR", times.toString(), null);

// reading a parameter from the service definition

String myParameter = myParameter;

bsf_monitor.log("ERROR", "---- myParameter ----", null);

bsf_monitor.log("ERROR", myParameter, null);

// minimal example

def testFile = new File("/tmp/TestFile");

if (testFile.exists()) {

bsf_monitor.log("ERROR", "Done MinimalGroovy ---- OK ----", null);

return "OK";

} else {

results.put("reason", "file does not exist");

bsf_monitor.log("ERROR", "Done MinimalGroovy ---- NOK ----", null);

return "NOK";

}4.6.6. CiscoIpSlaMonitor

这个监测器可以用来检测 Cisco 设备上的 IP SLA 配置。 此监测器支持以下的 SNMP OIDS CISCO-RTT-MON-MIB:

RTT_ADMIN_TAG_OID = .1.3.6.1.4.1.9.9.42.1.2.1.1.3 RTT_OPER_STATE_OID = .1.3.6.1.4.1.9.9.42.1.2.9.1.10 RTT_LATEST_OPERSENSE_OID = .1.3.6.1.4.1.9.9.42.1.2.10.1.2 RTT_ADMIN_THRESH_OID = .1.3.6.1.4.1.9.9.42.1.2.1.1.5 RTT_ADMIN_TYPE_OID = .1.3.6.1.4.1.9.9.42.1.2.1.1.4 RTT_LATEST_OID = .1.3.6.1.4.1.9.9.42.1.2.10.1.1

监测器可以在两种情况下运行。 第一个测试 RTT_LATEST_OPERSENSE 是一个用于最新 RTT 操作的完成状态的传感代码。 如果 RTT_LATEST_OPERSENSE 返回 ok(1) ,则服务被标记为 up。

第二种方案是检测在 IP SLA 协议中的阀值配置。 如果 RTT_LATEST_OPERSENSE 返回 overThreshold(3) ,则服务被标记为 down。

监测器定义

类名 |

|

是否支持远程轮询 |

false |

配置与使用

| 参数 | 描述 | 必须 | 默认值 |

|---|---|---|---|

|

|

必须 |

|

|

布尔值表示是否只检测状态或配置的阀值。 |

必须 |

`` |

该监测器实现 公共配置参数。

HTTP 和 ICMP 应答示例

在这个例子中,我们配置了一个 IP SLA 记录,用 Cisco 设备来检测 Google 网站的 HTTP GET 请求。

我们使用 8.8.8.8 作为 DNS 解析器。

在我们的例子中,我们的 SLA 显示我们可以在200毫秒之内到达 Google 的网站。

为了通知同事这个监测器条目用于监控,我将所有者设置为 OpenNMS。

标签 tag 用于标识 SNMP 表后面的检测条目。

ip sla monitor 1

type http operation get url http://www.google.de name-server 8.8.8.8

timeout 3000

threshold 200

owner OpenNMS

tag Google Website

ip sla monitor schedule 3 life forever start-time now在第二个示例中,我们配置一个 IP SLA 来测试从 Cisco 设备的角度,来自 www.opennms.org IP地址是否可以通过 ICMP 访问。 像上面的例子一样,我们有一个门限和一个超时.

ip sla 1

icmp-echo 64.146.64.212

timeout 3000

threshold 150

owner OpenNMS

tag OpenNMS Host

ip sla schedule 1 life forever start-time now| 重新配置 IP SLA 条目是不可能的。 如果要更改参数,则必须删除整个配置并用新参数重新配置它. 手动备份你的 Cisco 配置请参考 RANCID。 |

要检测这两个服务,要在 poller-configuration.xml 中配置两个实例:

<service name="IP-SLA-WEB-Google" interval="300000"

user-defined="false" status="on">

<parameter key="retry" value="2" />

<parameter key="timeout" value="3000" />

<parameter key="admin-tag" value="Google Website" />

<parameter key="ignore-thresh" value="false" />(1)

</service>

<service name="IP-SLA-PING-OpenNMS" interval="300000"

user-defined="false" status="on">

<parameter key="retry" value="2" />

<parameter key="timeout" value="3000" />

<parameter key="admin-tag" value="OpenNMS Host" />

<parameter key="ignore-thresh" value="true" />(2)

</service>

<monitor service="IP-SLA-WEB-Google" class-name="org.opennms.netmgt.poller.monitors.CiscoIpSlaMonitor" />

<monitor service="IP-SLA-PING-OpenNMS" class-name="org.opennms.netmgt.poller.monitors.CiscoIpSlaMonitor" />| 1 | 如果 IP SLA 状态为 ok(1),则服务为 up |

| 2 | 如果 IP SLA 状态为 overThreshold(3),则服务为 down |

4.6.7. CiscoPingMibMonitor

这个轮询器是使用 ciscoPingTable 来检测 Cisco IOS 设备,支持信息参考 CISCO-PING-MIB。 这些检测项可以远程让 IOS 设备配置一组参数执行 IPv4 或 IPv6 地址 ping 命令。 在 IOS 设备完成 ping 操作之后,轮询监测器查询 IOS 设备,以确定结果。 如果结果和服务配置参数指示一致,则监测器报告服务可用,并且将可用性计算结果时间序列化(RRD)存储。 如果结果指示失败,则报告服务不可用,并描述原因代码。 如果在设置检测项或之后查询状态期间出现错误,则监测器的服务报告 unknown 状态。

与大多数轮询器不同, CiscoPingMibMonitor 不接受 timeout 和 retries 参数。

参数 packet-count 和 packet-timeout 是提供给远程 IOS 设备,执行命令使用。

|

ciscoPingEntry 1.3.6.1.4.1.9.9.16.1.1.1

ciscoPingSerialNumber 1.3.6.1.4.1.9.9.16.1.1.1.1

ciscoPingProtocol 1.3.6.1.4.1.9.9.16.1.1.1.2

ciscoPingAddress 1.3.6.1.4.1.9.9.16.1.1.1.3

ciscoPingPacketCount 1.3.6.1.4.1.9.9.16.1.1.1.4

ciscoPingPacketSize 1.3.6.1.4.1.9.9.16.1.1.1.5

ciscoPingPacketTimeout 1.3.6.1.4.1.9.9.16.1.1.1.6

ciscoPingDelay 1.3.6.1.4.1.9.9.16.1.1.1.7

ciscoPingTrapOnCompletion 1.3.6.1.4.1.9.9.16.1.1.1.8

ciscoPingSentPackets 1.3.6.1.4.1.9.9.16.1.1.1.9

ciscoPingReceivedPackets 1.3.6.1.4.1.9.9.16.1.1.1.10

ciscoPingMinRtt 1.3.6.1.4.1.9.9.16.1.1.1.11

ciscoPingAvgRtt 1.3.6.1.4.1.9.9.16.1.1.1.12

ciscoPingMaxRtt 1.3.6.1.4.1.9.9.16.1.1.1.13

ciscoPingCompleted 1.3.6.1.4.1.9.9.16.1.1.1.14

ciscoPingEntryOwner 1.3.6.1.4.1.9.9.16.1.1.1.15

ciscoPingEntryStatus 1.3.6.1.4.1.9.9.16.1.1.1.16

ciscoPingVrfName 1.3.6.1.4.1.9.9.16.1.1.1.17准备条件

-

一个或多个 Cisco 设备,并且运行比较新版本 IOS ;任何 12.2 或更新版本都是可以的。 即使是非常低端的设备也支持 CISCO-PING-MIB。

-

执行远程 pings 命令的 IOS 设备通过 SNMP 写团体名 进行配置,OpenNMS Horizon 服务器包含源地址访问列表,ciscoPingTable 包含检测项 OID。

-

相应的 SNMP 写团体名 字符串可以在

snmp-config.xml文件中顶层<snmp-config>元素上使用write-community属性进行配置,也可以在要执行远程 pings 的 IOS 设备的 SNMP-primary 接口对应的<definition>子元素上配置。

扩展信息

这个监测器相当多时间是在等待状态,等待远程 IOS 设备完成 ping 操作。

监测器在计算创建 ciscoPingTable 检测项和它第一次尝试检索 ping 操作结果之间的延迟要是保守的 — 它至少要等待 (packet-count * (packet-timeout + packet-delay)) 毫秒,在检查远程 pings 是否完成之前。

因此,如果使用过大的 packet-count, packet-timeout, 和/或 packet-delay 参数值,则容易过多占用轮询器线程。

将这些值保持在使用范围内,以避免不必要地绑定查询线程。

此监测器通常使用 UNIX 计时方式标记 ciscoPingTable 检测项的创建时间。 使用一个带符号 32-bit 整数表示这个对象,放弃精度。 最好混合毫秒时间的最低有效字节,以代替整秒值的最低有效字节,以避免冲突。 IOS 似乎在 ping 操作完成后,几分钟内清理这个表中的记录。

监测器定义

类名 |

|

是否支持远程轮询 |

false |

配置与使用

| 参数 | 描述 | 必须 | 默认值 |

|---|---|---|---|

|

超时,以毫秒为单位,如果需要可以在

|

可选 |

配置在 |

|

失败重试次数。

如果需要可以在 |

可选 |

配置在 |

|

SNMP 协议版本 (1, 2c, 或 3) ,用于该服务监测器执行操作。 |

可选 |

配置在 |

|

远程 IOS 设备应该发送的 ping 数据包的数量。 |

可选 |

|

|

远程 IOS 设备应该发送的每个 ping 数据包的字节大小。 |

可选 |

|

|

远程 IOS 设备发送的每个 ping 数据包的超时,单位毫秒。 |

可选 |

|

|

延迟,单位毫秒,是远程 IOS 设备发送 ping 数据包之间的延迟。 |

可选 |

|

|

一个字符串值,是该服务设置 ciscoPingEntryOwner 项。 |

可选 |

|

|

设置 VRF (VLAN) 名称的字符串值,远程 IOS 设备在其上下文中应该为该服务执行 pings 操作。 |

可选 |

空字符串 |

|

主 SNMP 接口的设备数据库标识符应该用作该服务的 代理。

如果连同

|

可选 |

|

|

主 SNMP 接口的设备 |

可选 |

|

|

接口的 IP 地址应该用作这个服务的代理。

只有在 |

可选 |

|

|

远程 IOS 设备要 ping 的IP地址。 |

可选 |

|

|

一个 pings 成功率百分比 (从远程

IOS 设备的角度来看) ,以便该服务被认为是可用的。

例如,如果 |

可选 |

|

|

RRD 存储库的根目录, 存储该服务监测器的响应时间采样值 |

可选 |

|

|

RRD 数据源 (DS) 名称,用于存储该服务检测响应时间采样值;

RRD文件的基本名称 (去掉 |

可选 |

|

该监测器实现 公共配置参数。

如果你可以在配置中使用变量,这里可以忽略

| 变量 | 描述 |

|---|---|

|

该值将被监测器服务出现的接口的 IP 地址替换。 |

示例: 从客户Foo的所有路由器中提取相同的不可路由地址

服务提供商的客户,Foo 公司,在多个地点有网络服务。 在每个 Foo 位置,销售点系统的静态 IPv4 地址是 192.168.255.1。 Foo 想要随时通知销售点系统变得不可达。 使用 OpenNMS Horizon 的远程位置监测器是不可行的。 所有的 Foo 公司的 CPE 路由器必须是 Cisco IOS 设备,以便在这种情况下实现完全覆盖。

实现这一要求的一种方法是将所有 Foo 公司的前端路由器配置为监测类别 Customer_Foo, CPE, 和 Routers,并使用过滤器来创建仅适用于这些路由器的轮询包。

我们将使用特殊值 ${ipaddr} 作为 proxy-ip-addr 参数,以便在每个 Foo CPE 路由器上提供 pings。

用于我们希望每个 Foo CPE 路由器 ping 相同的 IP 地址 192.168.255.1,所以我们静态地列出 target-ip-addr 地址的值。

<package name="ciscoping-foo-pos">

<filter>catincCustomer_Foo & catincCPE & catincRouters & nodeSysOID LIKE '.1.3.6.1.4.1.9.%'</filter>

<include-range begin="0.0.0.0" end="254.254.254.254" />

<rrd step="300">

<rra>RRA:AVERAGE:0.5:1:2016</rra>

<rra>RRA:AVERAGE:0.5:12:1488</rra>

<rra>RRA:AVERAGE:0.5:288:366</rra>

<rra>RRA:MAX:0.5:288:366</rra>

<rra>RRA:MIN:0.5:288:366</rra>

</rrd>

<service name="FooPOS" interval="300000" user-defined="false" status="on">

<parameter key="rrd-repository" value="/opt/opennms/share/rrd/response" />

<parameter key="rrd-base-name" value="ciscoping" />

<parameter key="ds-name" value="ciscoping" />

<parameter key="proxy-ip-addr" value="${ipaddr}" />

<parameter key="target-ip-addr" value="192.168.255.1" />

</service>

<downtime interval="30000" begin="0" end="300000" /><!-- 30s, 0, 5m -->

<downtime interval="300000" begin="300000" end="43200000" /><!-- 5m, 5m, 12h -->

<downtime interval="600000" begin="43200000" end="432000000" /><!-- 10m, 12h, 5d -->

<downtime begin="432000000" delete="true" /><!-- anything after 5 days delete -->

</package>

<monitor service="FooPOS" class-name="org.opennms.netmgt.poller.monitors.CiscoPingMibMonitor" />示例: 从单个 IOS 设备 Ping 每个可路由的客户路由器。

服务提供商的客户端,中心有限,在多个位置提供网络服务。 虽然 OpenNMS Horizon' 提供世界级的服务保障是足够的,中心也希望随时通知一个前端路由器从 IOS 设备的主数据中心角度某位置不可达。 在这种情况下,一些或所有受限的中心 CPE 路由器可能是非思科设备。

为了满足这一要求,我们的方法是将中心限制的前端路由器配置为监测类别 Customer_Bar, CPE, 和 Routers,并使用过滤器来创建仅适用于这类路由器的轮询器包。

但是,这次我们不在 proxy-ip-addr 参数中使用 ${ipaddr} 特殊值,而是在 target-ip-addr 参数中使用特殊值,以便为每个中心 CPE 路由器执行远程 pings。

由于我们希望使用相同的 IOS 设备 20.11.5.11 来 ping CPE 路由器,所以我们静态地列出 proxy-ip-addr 地址的值。

附 poller-configuration.xml 配置实例

<package name="ciscoping-bar-cpe">

<filter>catincCustomer_Bar & catincCPE & catincRouters</filter>

<include-range begin="0.0.0.0" end="254.254.254.254" />

<rrd step="300">

<rra>RRA:AVERAGE:0.5:1:2016</rra>

<rra>RRA:AVERAGE:0.5:12:1488</rra>

<rra>RRA:AVERAGE:0.5:288:366</rra>

<rra>RRA:MAX:0.5:288:366</rra>

<rra>RRA:MIN:0.5:288:366</rra>

</rrd>

<service name="BarCentral" interval="300000" user-defined="false" status="on">

<parameter key="rrd-repository" value="/opt/opennms/share/rrd/response" />

<parameter key="rrd-base-name" value="ciscoping" />

<parameter key="ds-name" value="ciscoping" />